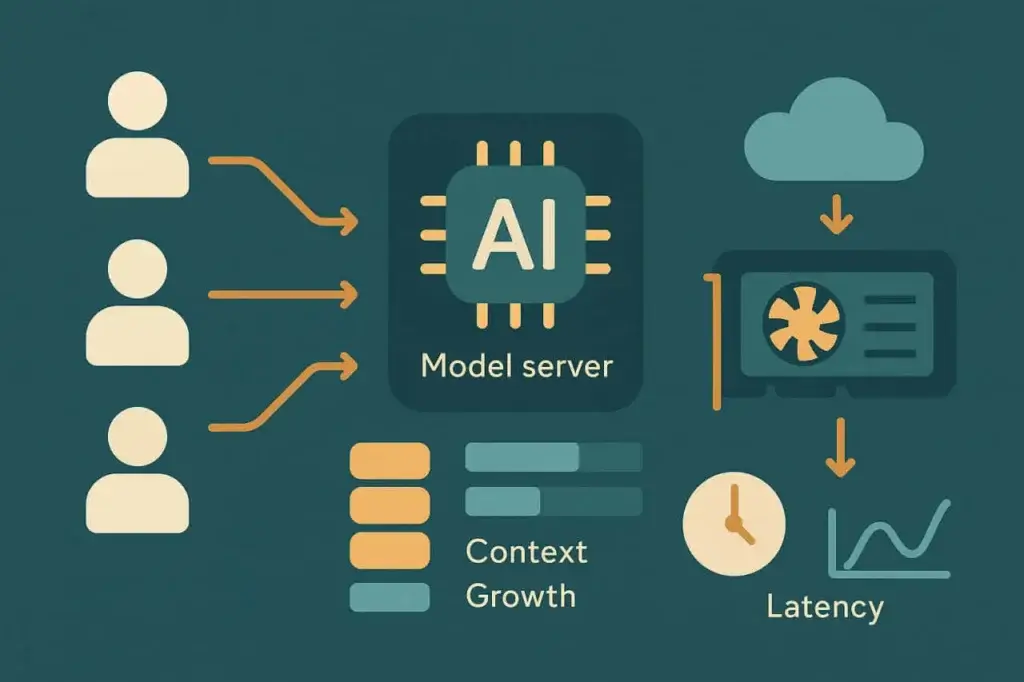

AIエージェントは「負荷」の意味を変えつつあります。従来の負荷テストは、ウェブページ、API、トランザクション向けに構築されており、ストレス下で予測可能に振る舞うシステムを対象にしていました。AI駆動のワークロードはそうではありません。入力の長さ、複雑さ、コンテキストが変動します。処理は確率的であり、決定論的ではありません。パフォーマンスはネットワーク遅延やバックエンドのスループットと同じくらいGPUのスケジューリングやトークン生成に依存します。

その変化は、ほとんどの負荷テストが前提としていた仮定を覆します。AIエージェントを他のAPIエンドポイントと同じように扱うことはできません。各リクエストはクリックではなく会話です。各応答は前の応答に依存します。そしてコンテキストが蓄積するにつれて各セッションは重くなります。

これらのシステムを信頼性高く維持するには、パフォーマンスエンジニアは新しいプレイブックが必要です—同時トラフィックだけでなく、同時に発生する推論(共同の思考)をシミュレートする方法を理解するものです。本稿は、エージェントを大規模にテストし、複雑性が増す中で性能を維持するための、現代的でAI駆動の戦略を概説します。

AIエージェントの負荷テストにおけるパフォーマンスの課題

AIワークロードはウェブやモバイルのトラフィックのようには振る舞いません。AI駆動システムの各「ユーザー」は、プロンプトの展開、関連コンテキストの取得、モデル推論、後処理やツール実行といった一連の連鎖した操作を表す場合があります。負荷は固定ではなく、各インタラクションのターンごとに進化します。

これらの層が積み重なると、パフォーマンスの劣化は非線形になります。並列ユーザーが2倍になったからといってレイテンシが2倍になるとは限らず、モデル負荷、メモリ、GPU割り当てによっては5倍になることもあります。リクエスト毎秒や平均応答時間のような従来の負荷テスト指標は、これらの根本的な動的挙動を見逃します。ここで重要なのは、レイテンシの弾力性—セッションが増えるにつれて性能がどのように曲がるか、です。

AIエージェントシステムにはいくつかの繰り返し現れるストレス要因があります:

コンテキストの蓄積

各ユーザークエリは履歴コンテキストを伴います—時には以前の会話や文書データの何千ものトークンに及ぶこともあります。コンテキスト長が増すとプロンプトサイズが膨張し、モデルの推論時間が長くなります。大規模では、これが予測不能なレイテンシのスパイクやGPUのキュー圧力を生みます。

計算に制約されたスケーリング

ウェブサーバーとは異なり、大規模モデルの推論は常に水平スケールできるわけではありません。モデルの重みやコンテキストウィンドウは固定のGPUメモリを消費し、容量を超えるとリクエストがキューされるか、より小さなモデルにフォールバックする必要があります。これにより、同時実行の上限はCPUベースのシステムよりはるかに厳しくなります。

検索(Retrieval)レイテンシ

多くのエージェントは応答を生成する前に、ベクターデータベース、API、ドキュメントストア経由で外部データを取得します。これらの依存はI/Oレイテンシを追加し、バーストトラフィック下で最初のボトルネックになります。

セッションの永続化

従来の負荷テストはステートレスなリクエストを再生します。AIセッションはステートフルです。各セッションはメモリ、埋め込み、キャッシュされたコンテキストを保持します。会話が長くなるほど、セッションのフットプリントは重くなります。

これらの要因が組み合わさって新しい種類のストレスプロファイルを生みます。システムは100の同時ユーザーでは正常に見えても、120で崩れる可能性がありますが、それは帯域の枯渇ではなくGPUキューの飽和やコンテキストキャッシュのオーバーフローが原因です。AIシステムの負荷テストは、これらの非線形な転換点がどこで始まるかを明らかにすることを意味します。

AIエージェントのワークロード挙動を理解する

テストを設計する前に、AIエージェントが内部で実際にどのように振る舞うかをモデリングすることが役立ちます。ほとんどのプロダクションエージェントは類似したパイプラインに従います:

- 入力の取り込み。 ユーザーがクエリまたはメッセージを送信する。

- コンテキストの組み立て。 エージェントは前のターンや外部ストアから関連データを収集する。

- モデル推論。 組み立てられたプロンプトがローカルまたはリモートのモデルエンドポイントに送られる。

- 後処理。 出力は返却前に解析、検証、あるいは強化されることがある。

- 応答の配信。 エージェントはUIの状態を更新するか、API応答を送信する。

各段階が変動を追加します。推論時間は入力および出力のトークン数に概ね比例してスケールします。検索レイテンシはデータベースの近さやキャッシュヒット率に依存します。コンテキスト組み立てのコストは会話のターンごとに増加します。

パフォーマンス挙動を把握するには、これらの次元がどのように相互作用するかを観察する必要があります。例えば、プロンプト長を倍にすると平均推論レイテンシが60%増えることがある一方、ある閾値を超えた並列性はそれを300%増加させるかもしれません。これらの曲線は、どの単一指標よりも重要です。

実践的には、ワークロード挙動をマッピングするにはプログレッシブなランプテストを実行します。少数の同時セッションで開始し、ベースラインのレイテンシを取得してから段階的にスケールアップします。トークンのスループット、キュー時間、GPU利用率がどのように反応するかを観察してください。各エージェントには独自のスケーリング特性があり、それを見つけることが信頼性ある運用への第一歩です。

AIエージェントの負荷テストで測定すべき主要指標

従来の指標—RPS、TTFB、エラー率—は依然として適用されますが、全てを語るわけではありません。AIエージェントの負荷テストでは、インフラだけでなく「知能」がどのようにスケールするかを反映する新しい指標が導入されます。

推論レイテンシ はプロンプト送信からモデル応答完了までの総時間を測定します。最も直接的なパフォーマンス信号ですが、入力サイズやモデルタイプとともに追跡する必要があります。コンテキストサイズで正規化せずに単純な平均を比較すると誤解を招くことがあります。

コンテキストスケーリング はプロンプトウィンドウが拡大するにつれてレイテンシがどのように増加するかを定量化します。エンジニアは応答時間をトークン数に対してプロットしてコスト曲線を可視化できます。最適化されたシステムは線形または亜線形のスケーリングを示し、最適化が不十分なシステムは特定のコンテキスト閾値を超えて指数的なスパイクを示します。

トークン・スループット—同時セッション全体で処理されるトークン/秒—はパフォーマンスとコスト効率の両方を反映します。ほとんどのAPIがトークン単位で課金するため、スループットの低下は直接的にコスト非効率に繋がります。

依存性レイテンシ はベクタ検索インデックス、ナレッジベース、プラグインAPIなどの補助システムからの遅延を捉えます。推論が速くても、これらが総応答時間を支配することがあります。

同時実行時の安定性 は同時負荷下でシステムがどのように振る舞うかを測ります。レイテンシは予測可能に増加しますか?エラー率は抑制されますか?それともキューが形成されると応答時間が乱高下しますか?

これらの指標を組み合わせることで、チームはパフォーマンスの全体像を構築できます。目的は単に速度を測ることではなく、どこで、なぜ劣化が始まるのかを理解することです。

AIシステム向けに効果的な負荷テストを設計する

指標が定義されたら、テスト戦略はシミュレーションの忠実度に関わる問題になります。AIエージェントは同一のリクエストを処理しないため、単一のトランザクションを記録して負荷下で再生するのは無意味です。各合成ユーザーは異なるプロンプト、長さ、振る舞いを表現しなければなりません。目標は均一性ではなく現実性です。

1. エンドポイントだけでなく、完全な推論パイプラインをモデル化する

実際のユーザーは /generate に単独でアクセスするわけではありません。認証し、コンテキストを送信し、リトリーバルを呼び出し、そして出力を生成します。信頼できる負荷テストはそのシーケンスを模倣します。一層を飛ばすと、データは無意味になります。

2. プロンプトをパラメータ化して実際の多様性を反映する

入力の長さや意味的な複雑さが増すとAIシステムは遅くなります。トークン数、文構造、組み込まれたコンテキスト深度を調整する可変プロンプトテンプレートを使用してください。これにより、スケーリングが応答時間分布に与える影響が浮き彫りになります。

3. 同時実行を段階的にランプアップする

AIバックエンドはしばしば推論層でリクエストをキューイングします。瞬時に1000ユーザーにスパイクするのではなく、10 → 50 → 100 → 200 のように定義された段階で徐々に増やし、各段階を数分間維持します。得られる曲線はGPUやスレッドの飽和がどこで始まるかを示します。

4. パフォーマンスと並んでコストを追跡する

ウェブサーバーとは異なり、推論APIはトークンごとにコストが発生します。負荷テスト中は各同時レベルで1リクエストあたりのコストを計算してください。パフォーマンスのチューニングには経済的効率も含めるべきです—高速だが高価なモデルは技術的に合格しても、スケール時に経済的に破綻する可能性があります。

5. リトライとタイムアウトの挙動を含める

AIエンドポイントは重負荷時にレート制限を行ったり性能を落としたりします。クライアントのリトライロジックをシミュレートして負荷の複合効果を観察してください。素朴な指数バックオフは、障害が増加すると有効トラフィックを倍増させることがあります。

これらの戦略は、古い「記録して再生する」モデルを行動シミュレーションの考え方に置き換えます。トランザクションをテストするのではなく、認知をテストするのです—システムがどのように考え、同時にスケールするかを。

AI駆動の負荷テスト:モデルに支援させる

皮肉なことに、AIはそれ自身が生み出した問題を解決するのに役立ちます。最新のテストプラットフォームは分析ループに機械学習モデルを組み込み始めており、これがいわゆるAI駆動の負荷テストを生み出しています。

ここでAIは三つの役割を果たします:

プロンプト生成

何百ものテスト入力を手作業で作る代わりに、生成モデルが実際のユーザー多様性を模したプロンプト変種を生成できます。トーン、構造、コンテキストを自動的に調整して、システムをより広範なストレスパターンにさらします。

異常検知

AIモデルは静的閾値よりも速くパフォーマンスデータの統計的ドリフトを検出できます。レイテンシが固定の閾値を超えたときにアラートを出すのではなく、異常検知モデルは通常の変動を学習し、本当に劣化を示す外れ値を浮かび上がらせます。

予測的飽和分析

過去の負荷データを分析することで、AIはシステムが次にどのタイミングで性能の崖に達するかを予測できます。回帰モデルや時系列予測器は、運用を破綻させる前に非線形なスケーリングパターンを特定します。

利点は魔法のような自動化ではなく、加速です。エンジニアは反復的なメンテナンスに費やす時間を減らし、パフォーマンス変化の理由を解釈する時間を増やせます。AI駆動の負荷テストは手作業のスクリプトを適応的な実験へと変えます。

LoadViewでのAIエージェントテストの実装

AIエージェントは最先端かもしれませんが、HTTP、WebSocket、REST APIといった馴染みのあるプロトコルで通信します。つまり、既存のLoadViewが提供するインフラでテストできます。

APIベースのテスト が基盤です。エージェントの各リクエストは、その複雑さにかかわらず最終的にAPI呼び出しに帰着します—多くの場合HTTPS上のJSONです。LoadViewのAPIテストにより、チームは数千の同時推論リクエストを、動的ペイロードでそれぞれパラメータ化してシミュレートできます。プロンプトサイズを変え、コンテキストを注入し、エンドツーエンドでレイテンシを測定できます。

UserViewスクリプティング はユーザーインターフェースを通したそのシミュレーションを拡張します。多くのエージェントはダッシュボード、チャットポータル、SaaS統合の中に存在します。LoadViewでは、ログイン、プロンプト入力、応答レンダリングといった完全なワークフローを記録して、分散クラウドロケーションから再生できます。このアプローチはブラウザ条件でのバックエンドとフロントエンドの両方の挙動を検証します。

スケーラブルなオーケストレーション がすべてを結びつけます。LoadViewのクラウドネットワークはテストを地理的に分散し、集中型GPUクラスターに依存するAIエンドポイントに対してグローバルトラフィックがどのように影響するかを見ることを可能にします。応答時間を地理的距離と相関させることで、ネットワーク遅延とモデル遅延を切り分けられます。

分析とレポート がフィードバックループを完成させます。LoadViewはすべての標準パフォーマンス指標を追跡しますが、処理トークン数やセッションあたりのコストのようなモデル固有データをキャプチャするようカスタマイズすることも可能です。この組み合わせにより、合成テストはAIパフォーマンスの観測性レイヤーになります。

言い換えれば、AIシステムのために新しいテストプラットフォームは必要なく、既存のプラットフォームの中でより賢いテスト設計が必要なだけです。LoadViewはすでにその原始的要素を備えており、この新しい種類のワークロードは単に異なるテスト哲学を要求するにすぎません。

AI負荷テストの未来

AIシステムは静的なサービスではありません—適応的で確率的、継続的に再訓練されます。つまり、インフラが同じでも性能特性は変化します。精度を向上させるモデルの更新が推論時間を倍増させることがあります。コヒーレンスを高めるプロンプト変更がコンテキストサイズを爆発させることがあります。負荷テストはこれらの移動する目標に対応するために進化しなければなりません。

将来のパフォーマンステストは、シミュレーション、分析、自己学習的フィードバックループを融合させるでしょう。テストはリアルタイムで適応し、観測されたモデルの安定性に基づいて負荷を拡大・縮小します。「テストを実行してレポートを読む」の代わりに、エンジニアはモデルのドリフトに合わせて更新される継続的なパフォーマンスベースラインを維持することになるでしょう。

焦点はスループットを超えて移動します。主要な質問は「1000人のユーザーに耐えられるか?」ではなく「圧力下で一貫して考えられるか?」になります。負荷が高まったときに推論の品質がどのように低下するかという認知的安定性を測定することが標準的な指標になるでしょう。

AIコパイロット、チャットアシスタント、自動意思決定エージェントを展開する組織にとって、この進化はすでに始まっています。システムは新しいが、原則は普遍的です:測定しないものは改善できません。負荷テストは常に隠れた限界を露呈する学問でした。AIは単に性能と知能の間に新たな境界を追加するのです。

AIエージェントの負荷テスト — まとめ

AIエージェントはパフォーマンステストに新たな次元を導入します。高度な計算、動的なコンテキスト、予測不能なスケーリングを組み合わせます。従来のテストスクリプトは追いつけませんが、AI駆動のアプローチが助けになります。推論レイテンシ、コンテキストスケーリング、同時実行安定性に注力し、LoadViewのようなツールで完全な推論ワークフローをシミュレートすることで、知能がシステムの核になる状況でもチームは信頼性を維持できます。

次の時代の負荷テストは単にシステムの応答速度を測るだけでなく、全員が同時に質問したときにシステムがどれだけ「考えられる」かを測るでしょう。