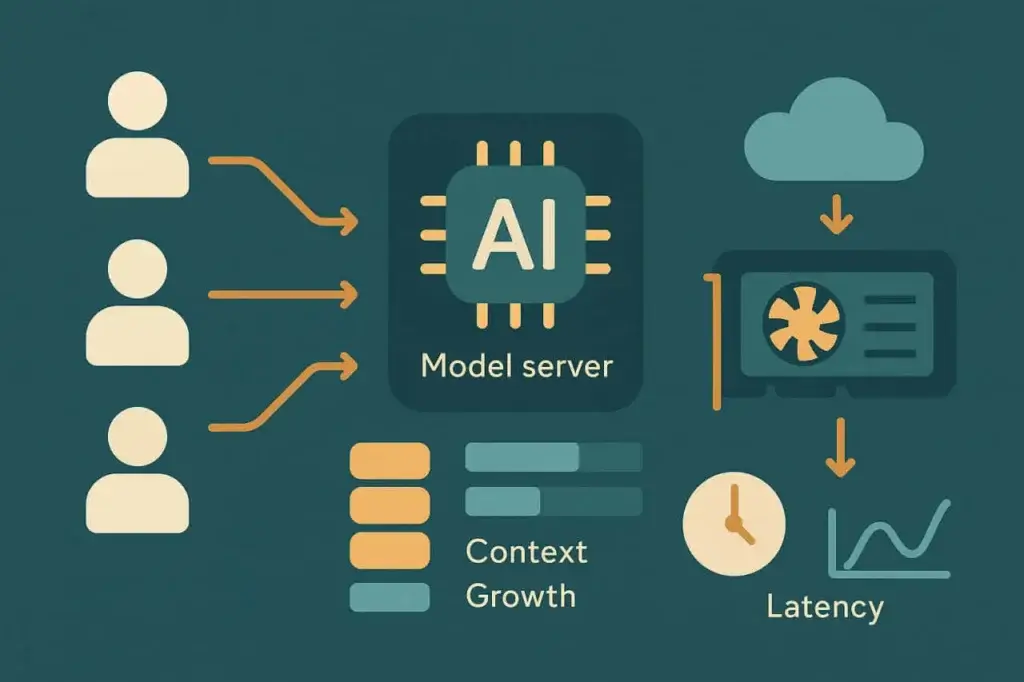

Los agentes de IA están cambiando lo que significa “carga”. Las pruebas de carga tradicionales se diseñaron para páginas web, API y transacciones: sistemas que se comportan de manera predecible bajo estrés. Las cargas de trabajo impulsadas por IA no lo hacen. Sus entradas varían en longitud, complejidad y contexto. Su procesamiento es probabilístico, no determinista. Su rendimiento depende tanto de la planificación de la GPU y la generación de tokens como de la latencia de la red o el rendimiento del backend.

Ese cambio rompe las suposiciones con las que se construyeron la mayoría de las pruebas de carga. No se puede tratar a un agente de IA como otro endpoint de API. Cada solicitud es una conversación, no un clic. Cada respuesta depende de la anterior. Y cada sesión se vuelve más pesada a medida que se acumula el contexto.

Para mantener estos sistemas fiables, los ingenieros de rendimiento necesitan un nuevo manual: uno que entienda cómo simular razonamiento concurrente, no solo tráfico concurrente. Este artículo describe estrategias modernas, impulsadas por IA, para probar agentes a escala y mantener su rendimiento a medida que aumenta la complejidad.

Desafíos de rendimiento en las pruebas de carga de agentes de IA

Las cargas de trabajo de IA no se comportan como el tráfico web o móvil. Cada “usuario” en un sistema impulsado por IA puede representar una serie de operaciones encadenadas: una expansión de prompt, la recuperación de contexto relevante, la inferencia del modelo y el posprocesamiento o la ejecución de herramientas. La carga no es fija: evoluciona con cada turno de la interacción.

A medida que estas capas se apilan, la degradación del rendimiento se vuelve no lineal. Un aumento de 2x en usuarios concurrentes no significa 2x de latencia: podría significar 5x, dependiendo de la carga del modelo, la memoria y la asignación de GPU. Las métricas tradicionales de pruebas de carga, como solicitudes por segundo o tiempo de respuesta promedio, no captan las dinámicas subyacentes. Lo que importa aquí es la elasticidad de la latencia: cómo cede el rendimiento a medida que se multiplican las sesiones.

Hay varios factores de estrés recurrentes en los sistemas de agentes de IA:

Acumulación de contexto

Cada consulta de usuario lleva contexto histórico: a veces miles de tokens de conversación previa o datos de documentos. A medida que crece la longitud del contexto, aumenta el tamaño del prompt y sube el tiempo de inferencia del modelo. A escala, esto crea picos de latencia impredecibles y presión de colas en las GPUs.

Escalado limitado por cómputo

A diferencia de los servidores web, la inferencia de modelos grandes no siempre puede escalar horizontalmente. Los pesos del modelo y las ventanas de contexto consumen memoria GPU fija; superar la capacidad significa encolar solicitudes o recurrir a modelos más pequeños. Eso hace que los límites de concurrencia sean mucho más estrictos que en sistemas basados en CPU.

Latencia de recuperación

Muchos agentes obtienen datos externos —mediante bases de datos vectoriales, APIs o almacenes de documentos— antes de generar una respuesta. Estas dependencias añaden latencia de E/S y se convierten en el primer cuello de botella bajo tráfico súbito.

Persistencia de sesión

Las pruebas de carga tradicionales reproducen solicitudes sin estado. Las sesiones de IA son con estado. Cada una lleva memoria, embeddings y contexto en caché. Cuanto más larga es la conversación, mayor es la huella de la sesión.

Estos factores se combinan en un nuevo perfil de estrés. El sistema puede parecer sano con 100 usuarios concurrentes pero colapsar con 120, no por agotamiento de ancho de banda sino por saturación de la cola de GPU o desbordamiento del caché de contexto. Probar la carga de sistemas IA significa revelar dónde comienzan esos puntos de inflexión no lineales.

Comprender el comportamiento de la carga de trabajo de agentes de IA

Antes de diseñar pruebas, ayuda modelar cómo se comporta realmente un agente de IA internamente. La mayoría de los agentes de producción siguen una canalización similar:

- Ingesta de entrada. El usuario envía una consulta o mensaje.

- Ensamblaje de contexto. El agente recopila datos relevantes de turnos previos o de un almacén externo.

- Inferencia del modelo. El prompt ensamblado se envía a un endpoint de modelo local o remoto.

- Posprocesamiento. La salida puede ser analizada, validada o enriquecida antes de devolverla.

- Entrega de la respuesta. El agente actualiza el estado de la interfaz o envía una respuesta API.

Cada etapa añade variabilidad. El tiempo de inferencia escala aproximadamente con la cantidad de tokens de entrada y salida. La latencia de recuperación depende de la proximidad de la base de datos y de las tasas de aciertos del caché. El coste del ensamblaje de contexto aumenta con cada turno de la conversación.

Para entender el comportamiento del rendimiento, hay que observar cómo interactúan estas dimensiones. Por ejemplo, doblar la longitud del prompt puede aumentar la latencia media de inferencia en un 60 %, pero la concurrencia más allá de cierto umbral puede aumentarla en un 300 %. Esas curvas importan más que cualquier métrica aislada.

En la práctica, mapear el comportamiento de la carga implica ejecutar pruebas de rampa progresiva. Empiece con unas pocas sesiones concurrentes, capture la latencia base y luego incremente gradualmente. Observe cómo responden el rendimiento de tokens, los tiempos de cola y la utilización de la GPU. Cada agente tiene su propia firma de escalado, y encontrarla es el primer paso hacia operaciones fiables.

Métricas clave a medir en pruebas de carga para agentes de IA

Las métricas tradicionales —RPS, TTFB, tasa de errores— siguen siendo aplicables, pero no cuentan toda la historia. Las pruebas de carga para agentes de IA introducen nuevas métricas que reflejan cómo escala la inteligencia, no solo la infraestructura.

Latencia de inferencia mide el tiempo total desde el envío del prompt hasta la respuesta completa del modelo. Es la señal de rendimiento más directa, pero debe registrarse junto con el tamaño de la entrada y el tipo de modelo. Comparar promedios sin normalizar por tamaño de contexto puede ser engañoso.

Escalado del contexto cuantifica cómo crece la latencia a medida que se amplía la ventana de prompt. Los ingenieros pueden trazar el tiempo de respuesta frente al número de tokens para visualizar la curva de coste. Un sistema bien optimizado muestra escalado lineal o sublineal, mientras que los sistemas mal optimizados presentan picos exponenciales más allá de ciertos umbrales de contexto.

Rendimiento de tokens —tokens procesados por segundo a través de sesiones concurrentes— refleja tanto el rendimiento como la eficiencia de costes. Dado que la mayoría de las APIs cobran por token, la caída del rendimiento se traduce directamente en ineficiencia económica.

Latencia de dependencias captura retrasos de los sistemas auxiliares: índices de búsqueda vectorial, bases de conocimiento o APIs de plugins. Estas pueden dominar el tiempo total de respuesta incluso cuando la inferencia es rápida.

Estabilidad de la concurrencia mide cómo se comporta el sistema bajo carga simultánea. ¿Aumenta la latencia de forma predecible? ¿Se mantienen acotadas las tasas de error? ¿O los tiempos de respuesta oscilan salvajemente cuando se forman colas?

Combinando estas métricas, los equipos pueden construir una imagen holística del rendimiento. El objetivo no es solo medir la velocidad: es entender dónde y por qué empieza la degradación.

Diseñar pruebas de carga eficaces para sistemas IA

Con las métricas definidas, la estrategia de prueba se trata de la fidelidad de la simulación. Los agentes de IA no sirven solicitudes idénticas, por lo que grabar una transacción y reproducirla bajo carga es inútil. Cada usuario sintético debe representar variación: distintos prompts, longitudes y comportamientos. El objetivo no es la uniformidad sino el realismo.

1. Modele toda la canalización de razonamiento, no solo el endpoint

Los usuarios reales no llaman a /generate de forma aislada. Se autentican, envían contexto, invocan la recuperación y luego generan la salida. Una prueba de carga creíble imita esa secuencia. Omitir una capa y sus datos pierden valor.

2. Parâmetrize los prompts para reflejar diversidad real

Los sistemas IA se ralentizan a medida que aumenta la longitud de entrada o la complejidad semántica. Use plantillas de prompt variables que ajusten el número de tokens, las estructuras de las oraciones o la profundidad del contexto integrado. Esto revela cómo la escala afecta la distribución de tiempos de respuesta.

3. Aumente la concurrencia gradualmente

Los backends de IA a menudo encolan peticiones en la capa de inferencia. En lugar de pasar instantáneamente a 1000 usuarios, aumente gradualmente en etapas definidas —por ejemplo 10 → 50 → 100 → 200— manteniendo cada etapa varios minutos. La curva resultante revela dónde empieza la saturación de GPU o hilos.

4. Controle el coste junto con el rendimiento

A diferencia de los servidores web, las APIs de inferencia implican coste por token. Durante las pruebas de carga, calcule el coste por petición en cada nivel de concurrencia. La optimización del rendimiento debe incluir eficiencia económica: modelos rápidos pero caros pueden fallar financieramente al escalar, aunque técnicamente pasen.

5. Incluya comportamiento de reintento y timeout

Los endpoints de IA a menudo limitan la tasa o se degradan bajo uso intensivo. Modele la lógica de reintento del cliente para observar efectos compuestos de carga. Un backoff exponencial ingenuo puede duplicar el tráfico efectivo cuando aumentan los fallos.

Estas estrategias reemplazan el antiguo modelo de “grabar y reproducir” por una mentalidad de simulación conductual. En lugar de probar transacciones, se prueba la cognición: cómo el sistema piensa y escala simultáneamente.

Pruebas de carga potenciadas por IA: deje que los modelos ayuden

Irónicamente, la IA puede ayudar a resolver el problema que ella misma crea. Las plataformas de prueba modernas están empezando a integrar modelos de aprendizaje automático directamente en sus bucles de análisis, produciendo lo que a menudo se denomina pruebas de carga potenciadas por IA.

Aquí, la IA desempeña tres papeles:

Generación de prompts

En lugar de crear manualmente cientos de entradas de prueba, un modelo generativo puede producir variaciones de prompts que simulen la diversidad real de usuarios. Puede ajustar tono, estructura y contexto automáticamente, exponiendo al sistema a una gama más amplia de patrones de estrés.

Detección de anomalías

Los modelos de IA pueden detectar la deriva estadística en los datos de rendimiento más rápido que umbrales estáticos. En lugar de alertar cuando la latencia supera un límite fijo, los modelos de anomalías aprenden la varianza normal y señalan los outliers que indican una degradación real.

Análisis predictivo de saturación

Analizando datos históricos de carga, la IA puede predecir cuándo un sistema alcanzará su próximo acantilado de rendimiento. Modelos de regresión o predictores de series temporales identifican patrones de escalado no lineales antes de que rompan la producción.

El beneficio no es una automatización mágica, es aceleración. Los ingenieros dedican menos tiempo a tareas repetitivas y más tiempo a interpretar por qué cambia el rendimiento. Las pruebas de carga potenciadas por IA convierten el scripting manual en experimentación adaptativa.

Implementación de pruebas para agentes de IA en LoadView

Los agentes de IA pueden ser de vanguardia, pero siguen comunicándose a través de protocolos familiares —HTTP, WebSocket o APIs REST. Eso significa que puede probarlos con la misma infraestructura que LoadView ya proporciona.

Las pruebas basadas en API son la base. Cada solicitud de agente, con independencia de su complejidad, acaba resolviéndose en una llamada API —a menudo JSON sobre HTTPS. Las pruebas de API de LoadView permiten a los equipos simular miles de solicitudes de inferencia concurrentes, cada una parametrizada con payloads dinámicos. Puede variar el tamaño del prompt, inyectar contexto y medir la latencia de extremo a extremo.

El scripting UserView amplía esa simulación a través de la interfaz de usuario. Muchos agentes se alojan en paneles, portales de chat o integraciones SaaS. Con LoadView, puede grabar flujos completos —inicio de sesión, entrada del prompt, renderizado de la respuesta— y reproducirlos desde ubicaciones en la nube distribuidas. Este enfoque valida tanto el backend como el frontend bajo condiciones reales de navegador.

La orquestación escalable conecta todo. La red en la nube de LoadView distribuye las pruebas entre geografías, permitiendo a los equipos ver cómo el tráfico global afecta a endpoints de IA que dependen de clústeres GPU centralizados. Al correlacionar los tiempos de respuesta con la distancia geográfica, puede separar la latencia de red de la latencia del modelo.

Analíticas e informes completan el ciclo de retroalimentación. LoadView rastrea todas las métricas de rendimiento estándar, pero también puede personalizarse para capturar datos específicos del modelo, como tokens procesados o coste por sesión. Esa combinación transforma las pruebas sintéticas en una capa de observabilidad para el rendimiento de IA.

En otras palabras, no necesita una nueva plataforma de pruebas para sistemas IA: necesita un diseño de pruebas más inteligente dentro de una existente. LoadView ya dispone de las primitivas, y esta nueva clase de cargas de trabajo simplemente exige una filosofía de prueba diferente.

El futuro de las pruebas de carga para IA

Los sistemas de IA no son servicios estáticos: son adaptativos, estocásticos y se reentrenan continuamente. Eso significa que sus características de rendimiento cambian incluso cuando la infraestructura permanece igual. Una actualización del modelo que mejore la precisión puede duplicar el tiempo de inferencia. Un cambio de prompt que aumente la coherencia puede hacer explotar el tamaño del contexto. Las pruebas de carga deben evolucionar para tener en cuenta estos objetivos móviles.

Las futuras pruebas de rendimiento mezclarán simulación, análisis y bucles de retroalimentación autoaprendentes. Las pruebas se adaptarán en tiempo real, ampliando o reduciendo la carga según la estabilidad observada del modelo. En lugar de “ejecutar la prueba, leer el informe”, los ingenieros mantendrán líneas base de rendimiento continuas que se actualicen a medida que los modelos derivan.

El foco se desplazará más allá del rendimiento. La pregunta clave ya no será “¿Puede manejar 1000 usuarios?” sino “¿Puede pensar de manera consistente bajo presión?” Medir la estabilidad cognitiva —cómo se degrada la calidad del razonamiento cuando aumenta la demanda— se convertirá en una métrica estándar.

Para las organizaciones que despliegan copilotos IA, asistentes de chat y agentes de decisión automatizados, esta evolución ya está en marcha. Los sistemas son nuevos, pero el principio sigue siendo intemporal: no se puede mejorar lo que no se mide. Las pruebas de carga siempre han sido la disciplina que expone los límites ocultos. La IA simplemente añade un nuevo límite: la frontera entre el rendimiento y la inteligencia.

Pruebas de carga para agentes de IA – Resumen

Los agentes de IA introducen una nueva dimensión en las pruebas de rendimiento. Combinan computación intensiva, contexto dinámico y escalado impredecible. Los scripts de prueba tradicionales no dan abasto, pero los enfoques potenciados por IA pueden ayudar. Al centrarse en la latencia de inferencia, el escalado del contexto y la estabilidad de la concurrencia —y al utilizar herramientas como LoadView para simular flujos completos de razonamiento— los equipos pueden preservar la fiabilidad incluso cuando la inteligencia se convierte en el núcleo de sus sistemas.

La próxima era de las pruebas de carga no medirá solo la rapidez de las respuestas. Medirá lo bien que piensan cuando todos preguntan a la vez.