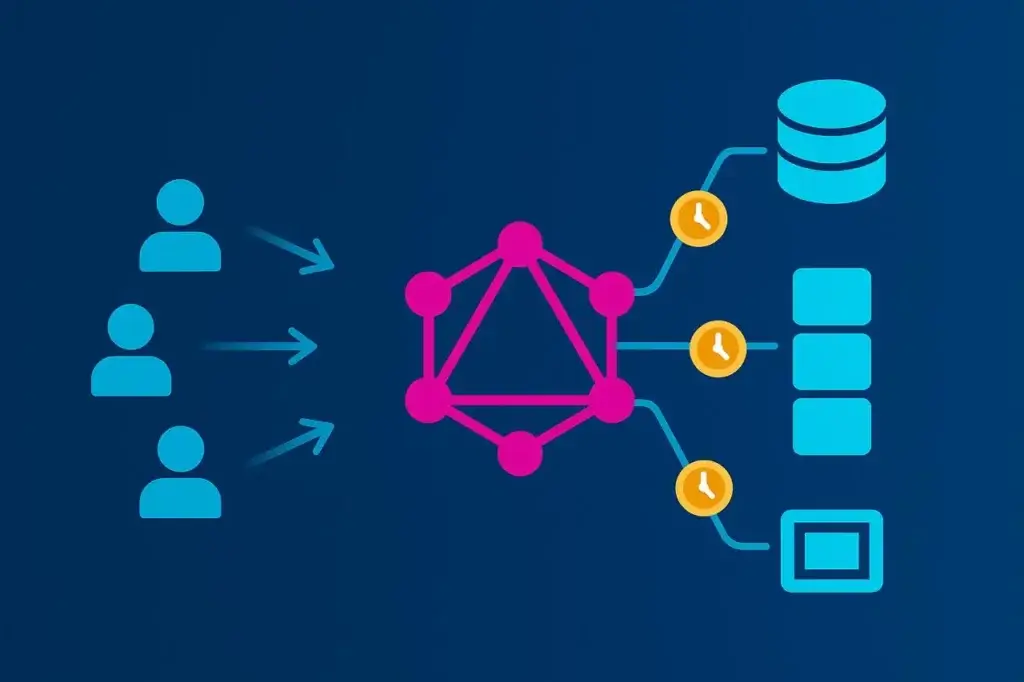

GraphQL cambió la forma en que los frontends consumen datos—y al hacerlo, cambió la forma en que las API fallan bajo presión.

A diferencia de REST, donde cada ruta define qué datos devuelve, GraphQL invierte el control. El cliente decide qué campos solicitar, qué tan profundo recorrer y con qué frecuencia repetir la petición. Esa flexibilidad libera a los desarrolladores, pero hace que el rendimiento sea impredecible. Dos consultas al mismo endpoint pueden generar cargas de trabajo del servidor totalmente distintas.

Las pruebas de carga tradicionales suponen consistencia: una ruta fija, una carga útil predecible, una latencia medible. GraphQL rompe esas suposiciones. Para probarlo de forma efectiva, tienes que modelar la variación de consultas, la profundidad de los resolvers y los patrones de concurrencia que reflejen el uso real. De lo contrario, sólo estarás probando tu caché, no tu API.

Este artículo desglosa cómo diseñar, ejecutar e interpretar pruebas de carga que capturen lo que realmente importa en un sistema GraphQL: el coste de los resolvers, la orquestación del backend y la compensación entre flexibilidad y escalabilidad.

Why GraphQL Load Testing Is Different

La mayoría de las pruebas de carga se construyen sobre la repetición. Grabas una transacción de API y la reproduces a escala, midiendo cuánto tarda en completarse. Eso funciona bien para REST. Cada llamada a /api/orders devuelve aproximadamente la misma carga, ejecuta la misma lógica y cuesta más o menos lo mismo en cómputo.

GraphQL, por otro lado, ejecuta un planificador de consultas personalizado para cada petición. Cada solicitud del cliente define su propia carga de trabajo:

- Algunas obtienen uno o dos campos.

- Otras se adentran cinco niveles en relaciones anidadas.

- Muchas combinan consultas y mutaciones en una sola llamada.

Para el generador de carga, todo parece un único POST /graphql—pero bajo la superficie, tus servidores podrían estar haciendo 50 consultas a la base de datos, expandiéndose a media docena de microservicios y serializando cientos de campos JSON.

Por eso las pruebas de carga de GraphQL no pueden tratarse como una simple prueba de rendimiento por throughput. No se trata de cuántas peticiones por segundo puedes manejar. Se trata de cómo la forma de la consulta impulsa el comportamiento del backend. La “forma correcta” significa diseñar pruebas que reflejen esa variabilidad en lugar de ocultarla.

The Hidden Cost of Query Complexity

Una de las características de GraphQL más malentendidas es lo costoso que puede volverse con la profundidad. Una consulta aparentemente inocua puede convertirse en una bomba computacional cuando se despliega a través de resolvers anidados.

Toma un esquema básico de comercio electrónico:

query GetCustomer {

customer(id: "42") {

name

orders {

id

total

products {

id

name

price

}

}

}

}

En el papel, parece simple. Pero si cada resolver llama a la base de datos por separado—uno para el cliente, uno por cada pedido, uno por producto—acabas de multiplicar el coste de la consulta exponencialmente. El famoso “problema N+1” convierte una sola petición del cliente en un enjambre de llamadas al backend.

Ahora imagina 1.000 usuarios virtuales golpeando esa consulta en paralelo. Ya no estás probando carga en un único endpoint; estás probando carga en cada tabla de la base de datos y microservicio aguas abajo. El desafío no es sólo la concurrencia—es entender dónde se manifiesta esa concurrencia.

Para que las pruebas de carga sean significativas, necesitas visibilidad a nivel de resolver. La profundidad de la consulta y el número de resolvers deben formar parte de tu perfil de prueba, no sólo el tiempo de respuesta. De lo contrario, sólo verás el humo, no el fuego.

What to Measure (and Why)

Las métricas de rendimiento para GraphQL deben verse en capas: consulta, resolver y sistema. Cada una cuenta una parte diferente de la historia.

En la capa de consulta, céntrate en:

- Distribuciones de latencia (p50, p95, p99) para ver cómo las consultas complejas deforman el rendimiento en la cola.

- Throughput (QPS)—útil principalmente como métrica contextual, no como objetivo en sí mismo.

- Tasas de error y de timeout para detectar degradación inducida por la carga.

En la capa de resolver, recopila datos de instrumentación siempre que sea posible:

- Tiempo de ejecución por resolver o campo.

- Número de invocaciones de resolvers por consulta.

- Ratios de aciertos/fallos de caché.

- Latencia de llamadas aguas abajo (bases de datos, APIs externas).

En la capa de sistema, vincula esas métricas con la utilización de la infraestructura—CPU, memoria, conteo de hilos y saturación de pools de conexión. Los servidores GraphQL a menudo están limitados por CPU durante picos de carga debido al análisis de consultas y la serialización de resolvers, por lo que tu cuello de botella puede no vivir siquiera en la base de datos.

Los tiempos de respuesta crudos por sí solos no te dirán mucho. Correlacionar la ejecución de resolvers con la telemetría de infraestructura es como aislar verdaderas limitaciones de escalabilidad.

Building a Realistic GraphQL Load Model

GraphQL no es una única API—es una interfaz para docenas. Para probarlo de forma realista, tienes que reflejar esa diversidad.

Empieza por extraer tráfico de producción o registros de acceso para nombres de operación y firmas de consulta. Estos revelan la mezcla real del comportamiento del cliente—búsquedas cortas, agregaciones profundas, mutaciones y ocasionalmente consultas “fetch everything” abusivas.

Desde ahí:

- Pesa las consultas por frecuencia. Tu mezcla de pruebas debe reflejar las proporciones de producción—por ejemplo, 80% búsquedas ligeras, 20% consultas anidadas complejas.

- Aleatoriza los valores de las variables para que las capas de caché no sesguen los resultados.

- Incluye flujos de autenticación cuando sea relevante. La generación de tokens, la validación de sesiones y el rate limiting pueden convertirse en puntos de estrangulamiento bajo carga.

- Modela patrones de concurrencia. Los usuarios reales no llegan de forma constante. Simula picos, ramp-ups y valles de inactividad para ver cómo se comporta el autoscaling.

Una prueba de carga que sólo reproduce una consulta es como una prueba de estrés que sólo golpea tu página principal—parece bien hasta que llega el mundo real. Cuanto más representativa sea tu carga de trabajo, más valiosos serán tus datos.

Executing GraphQL Load Tests

Probar la carga de GraphQL de forma efectiva significa añadir realismo y escala. La flexibilidad de la API exige tanto pruebas controladas basadas en scripts como ejecuciones distribuidas que simulen condiciones reales de usuarios.

Scripted HTTP-Based Testing

JMeter sigue siendo una base sólida para las pruebas de carga de GraphQL. Dado que GraphQL funciona sobre solicitudes HTTP POST estándar, puedes definir consultas como payloads JSON, inyectar variables dinámicamente y parametrizar tokens o datos de sesión dentro de un plan de prueba de JMeter.

Este enfoque ofrece control total sobre la concurrencia, los encabezados y la estructura del payload—ideal para validar el rendimiento del backend bajo mezclas de consultas realistas. Es ligero y repetible, pero sólo cuenta una parte de la historia: el tiempo de respuesta a nivel de protocolo. No tiene en cuenta la latencia de red o el comportamiento del navegador.

Scaling GraphQL Tests with LoadView

Para pasar de ejecuciones locales con JMeter a validaciones a escala de producción, LoadView proporciona una capa de ejecución gestionada diseñada específicamente para pruebas distribuidas. Ejecuta tus planes de JMeter en múltiples ubicaciones geográficas, introduciendo latencia y variabilidad de ancho de banda del mundo real que los entornos locales no pueden reproducir.

LoadView extiende la misma flexibilidad de scripting mientras gestiona toda la orquestación:

- Importa planes de JMeter existentes directamente.

- Ejecuta solicitudes POST de GraphQL con variables dinámicas y tokens de autenticación.

- Ejecuta usuarios concurrentes desde regiones globales para datos de rendimiento realistas.

- Visualiza percentiles de latencia, throughput y tendencias de errores en tiempo real.

Este enfoque híbrido—usar JMeter para definir pruebas y LoadView para la ejecución distribuida—ofrece precisión y escala. Los equipos pueden iterar rápidamente durante el desarrollo y luego validar a plena carga antes del lanzamiento, usando la misma lógica de prueba de extremo a extremo.

Browser-Level Load Testing

Cuando GraphQL alimenta frontends orientados al usuario, merece la pena validar cómo se siente el rendimiento a nivel de navegador. LoadView también puede ejecutar escenarios a nivel de navegador, renderizando páginas y desencadenando solicitudes GraphQL a través de navegadores reales. Esto mide los tiempos de transacción completos—incluyendo renderizado, retardos de red y comportamiento de caché—ofreciendo una visión de extremo a extremo de la experiencia del usuario bajo carga.

Usados conjuntamente, estos niveles—pruebas HTTP scriptadas y ejecuciones a nivel de navegador—crean un modelo realista de cómo GraphQL realmente se comporta cuando cientos o miles de usuarios consultan simultáneamente.

Avoiding the Classic Testing Pitfalls

Las pruebas de rendimiento de GraphQL están llenas de trampas que hacen que los datos sean insignificantes. Lo peor es que la mayoría de ellas parecen éxito hasta que la producción las desmiente.

Un error frecuente es probar una sola consulta estática. Proporciona números limpios y consistentes—y no te dice nada sobre cómo el sistema maneja la diversidad.

Otro es ignorar el estado de la caché. La primera ejecución golpea la base de datos, y las siguientes cinco golpean Redis, y de repente el rendimiento parece magnífico. Ejecuta siempre escenarios de caché fría y caliente.

Una trampa más sutil es no contabilizar la variabilidad a nivel de resolver. Sin datos de tracing, no puedes saber si una respuesta lenta provino de una consulta pesada o de un fallo temporal en el backend. Los hooks de temporización de resolvers o las extensiones de tracing (Apollo Tracing, GraphQL Yoga, etc.) ayudan a separar el coste de la consulta del ruido de la infraestructura.

Finalmente, no confundas las pruebas de carga con el caos. El objetivo no es tumbar tu API—es encontrar la pendiente donde la latencia comienza a aumentar. Más allá de ese punto, estás midiendo fallos, no rendimiento.

La mentalidad correcta es diagnóstica, no destructiva.

Interpreting GraphQL Load Testing Results and Acting on Them

Las pruebas de carga no consisten sólo en recopilar datos, sino en traducirlos en decisiones.

Empieza por la correlación. Si los picos de latencia se alinean con el recuento de llamadas a resolvers, has encontrado un problema N+1. Si la CPU sube mientras las métricas de la base de datos se mantienen planas, tu cuello de botella está en el análisis de consultas o la serialización de respuestas.

A partir de ahí, se abren caminos de optimización:

- Resolver agrupados usando dataloaders o joins a nivel de consulta para reducir fetches redundantes.

- Añadir caché a nivel de resolver u objeto para cortar trabajo duplicado.

- Implementar puntuación de complejidad de consultas para que la API pueda rechazar o limitar consultas patológicas antes de que fundan el backend.

- Introducir consultas persistidas—operaciones preaprobadas almacenadas en el servidor—para eliminar la sobrecarga de parseo y limitar el comportamiento impredecible del cliente.

Una vez aplicadas las mejoras, vuelve a ejecutar el mismo modelo de carga. Afinar rendimiento sin volver a probar es como depurar sin registros—estás adivinando.

Making GraphQL Load Testing Continuous

Una prueba de carga puntual es una casilla de cumplimiento. Una prueba continua es una ventaja de ingeniería.

Los esquemas GraphQL evolucionan constantemente a medida que el producto crece. Nuevos campos, nuevos joins y nuevas funciones del cliente cambian las características de rendimiento. Cada cambio de esquema puede alterar sutilmente las rutas de los resolvers o los volúmenes de datos.

Integra pruebas de carga reducidas en los pipelines de CI/CD—suficientes para detectar regresiones antes del despliegue. Mantén tus conjuntos de consultas actualizados conforme evolucione el tráfico de producción. Programa pruebas más profundas mensualmente o antes de lanzamientos importantes para validar que las optimizaciones siguen siendo efectivas.

Trata el rendimiento como parte del ciclo de vida del esquema, no como una fase separada. En GraphQL, cada nuevo campo es una potencial responsabilidad de rendimiento hasta que se demuestre lo contrario.

Conclusion

El poder de GraphQL reside en su flexibilidad. Esa misma flexibilidad hace fácil construir una API que parece perfecta bajo pruebas ligeras pero que se colapsa bajo la variedad del mundo real.

La forma correcta de probar la carga de GraphQL no consiste en números brutos—consiste en contexto. Simula consultas reales, mide el coste de su profundidad y complejidad, y rastrea cómo cada una se expande a través de los sistemas. Entiende la pendiente donde el rendimiento comienza a degradarse, no sólo el punto donde se rompe.

Para equipos que ejecutan estas pruebas a escala, LoadView ayuda a extender el proceso más allá del laboratorio. Al ejecutar escenarios basados en JMeter o en navegadores desde múltiples regiones globales, ofrece una imagen más fiel del rendimiento en condiciones reales de internet—latencia, variabilidad y todo.

Usado de este modo, LoadView deja de ser sólo una herramienta y se convierte en un campo de pruebas: el entorno donde las APIs flexibles se enfrentan a la demanda del mundo real. Haz eso, y las pruebas de carga dejarán de ser un ritual técnico—se convertirán en un mapa de cómo tu arquitectura se comporta realmente cuando la libertad se encuentra con la escala.