Agentes de IA estão mudando o que “carga” significa. O teste de carga tradicional foi construído para páginas web, APIs e transações—sistemas que se comportam de forma previsível sob estresse. Cargas de trabalho movidas por IA não. Seus inputs variam em comprimento, complexidade e contexto. Seu processamento é probabilístico, não determinístico. Seu desempenho depende tanto do agendamento de GPU e da geração de tokens quanto da latência de rede ou da capacidade de processamento do backend.

Essa mudança rompe as suposições sobre as quais a maioria dos testes de carga foi construída. Você não pode tratar um agente de IA como outro endpoint de API. Cada solicitação é uma conversa, não um clique. Cada resposta depende da anterior. E cada sessão fica mais pesada conforme o contexto se acumula.

Para manter esses sistemas confiáveis, engenheiros de desempenho precisam de um novo manual—um que entenda como simular raciocínio concorrente, não apenas tráfego concorrente. Este artigo descreve estratégias modernas, impulsionadas por IA, para testar agentes em escala e mantê-los com bom desempenho à medida que a complexidade aumenta.

Desafios de Desempenho no Teste de Carga de Agentes de IA

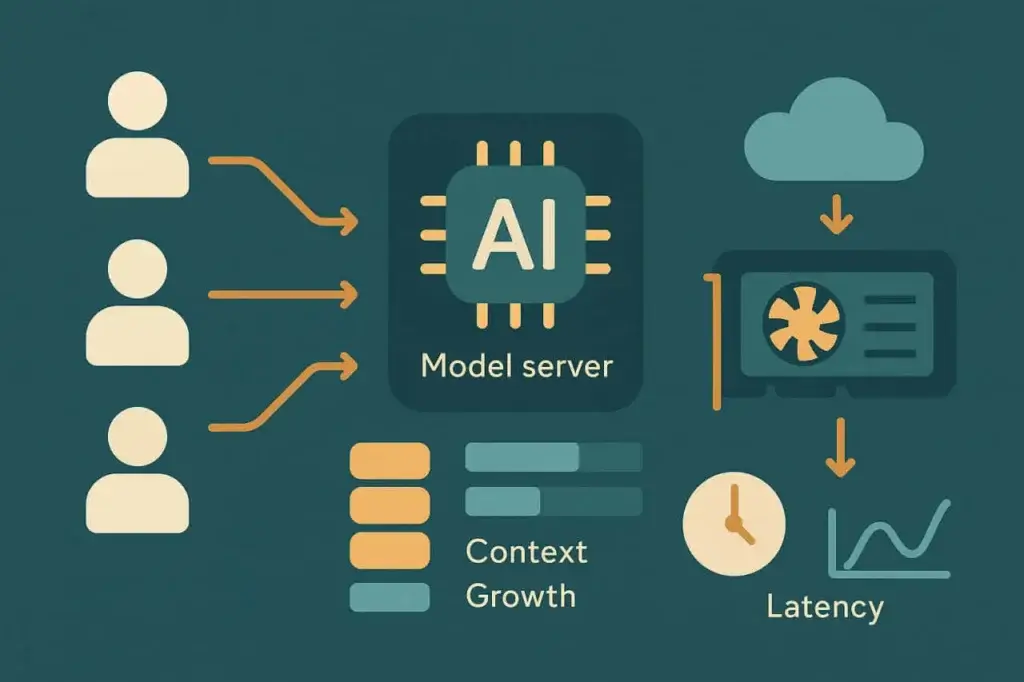

Cargas de trabalho de IA não se comportam como tráfego web ou móvel. Cada “usuário” em um sistema movido por IA pode representar uma série de operações encadeadas: uma expansão de prompt, recuperação de contexto relevante, inferência do modelo e pós-processamento ou execução de ferramenta. A carga não é fixa—ela evolui a cada turno na interação.

Conforme essas camadas se empilham, a degradação de desempenho torna-se não linear. Um aumento de 2x em usuários concorrentes não significa 2x a latência—pode significar 5x, dependendo da carga do modelo, da memória e da alocação de GPU. Métricas tradicionais de teste de carga como requisições por segundo ou tempo médio de resposta deixam de capturar as dinâmicas subjacentes. O que importa aqui é a elasticidade da latência—como o desempenho se curva conforme as sessões se multiplicam.

Existem vários fatores de estresse recorrentes em sistemas de agentes de IA:

Acúmulo de Contexto

Cada consulta do usuário carrega contexto histórico—às vezes milhares de tokens de conversas anteriores ou dados de documentos. À medida que o comprimento do contexto cresce, o tamanho do prompt aumenta e o tempo de inferência do modelo sobe. Em escala, isso cria picos de latência imprevisíveis e pressão de enfileiramento nas GPUs.

Escalonamento Limitado por Computação

Ao contrário de servidores web, a inferência de grandes modelos nem sempre escala horizontalmente. Pesos do modelo e janelas de contexto consomem memória fixa da GPU; exceder a capacidade significa enfileirar requisições ou recorrer a modelos menores. Isso torna os limites de concorrência muito mais rígidos do que em sistemas baseados em CPU.

Latência de Recuperação

Muitos agentes puxam dados externos—via bancos de dados vetoriais, APIs ou repositórios de documentos—antes de gerar uma resposta. Essas dependências adicionam latência de E/S e se tornam o primeiro gargalo sob tráfego em rajada.

Persistência de Sessão

Testes de carga tradicionais reproduzem requisições sem estado. Sessões de IA são com estado. Cada uma carrega memória, embeddings e contexto em cache. Quanto mais longa a conversa, maior a pegada da sessão.

Esses fatores se combinam em um novo tipo de perfil de estresse. O sistema pode parecer saudável com 100 usuários concorrentes, mas ceder aos 120, não por esgotamento de banda, mas por saturação da fila da GPU ou transbordo do cache de contexto. Testar carga em sistemas de IA significa revelar onde esses pontos de inflexão não lineares começam.

Entendendo o Comportamento da Carga de Trabalho de Agentes de IA

Antes de projetar testes, ajuda modelar como um agente de IA realmente se comporta internamente. A maioria dos agentes em produção segue um pipeline semelhante:

- Ingestão de entrada. O usuário envia uma consulta ou mensagem.

- Montagem de contexto. O agente coleta dados relevantes de interações anteriores ou de um armazenamento externo.

- Inferência do modelo. O prompt montado é enviado para um endpoint do modelo local ou remoto.

- Pós-processamento. A saída pode ser analisada, validada ou enriquecida antes de retornar.

- Entrega da resposta. O agente atualiza o estado da interface ou envia uma resposta via API.

Cada etapa adiciona variabilidade. O tempo de inferência escala aproximadamente com a contagem de tokens de entrada e saída. A latência de recuperação depende da proximidade do banco de dados e das taxas de acerto do cache. O custo de montagem de contexto aumenta a cada interação na conversa.

Para entender o comportamento de desempenho, você precisa observar como essas dimensões interagem. Por exemplo, dobrar o comprimento do prompt pode aumentar a latência média de inferência em 60%, mas a concorrência além de um certo limiar pode aumentá-la em 300%. Essas curvas importam mais do que qualquer métrica isolada.

Na prática, mapear o comportamento da carga de trabalho significa rodar testes de rampa progressiva. Comece com algumas sessões concorrentes, capture a latência de referência e então aumente incrementalmente. Observe como vazão de tokens, tempos de fila e utilização de GPU respondem. Cada agente tem sua própria assinatura de escalabilidade, e encontrá-la é o primeiro passo rumo a operações confiáveis.

Métricas Principais a Medir em Testes de Carga para Agentes de IA

Métricas tradicionais—RPS, TTFB, taxa de erro—ainda se aplicam, mas não contam toda a história. O teste de carga de agentes de IA introduz novas métricas que refletem como a inteligência, não apenas a infraestrutura, escala.

Latência de inferência mede o tempo total desde o envio do prompt até a conclusão da resposta do modelo. É o sinal de desempenho mais direto, mas deve ser rastreada junto com o tamanho de entrada e o tipo de modelo. Comparar médias brutas sem normalizar pelo tamanho do contexto pode ser enganoso.

Escalonamento de contexto quantifica como a latência cresce à medida que a janela de prompt se expande. Engenheiros podem traçar o tempo de resposta contra a contagem de tokens para visualizar a curva de custo. Um sistema bem otimizado mostra escalabilidade linear ou sublinear, enquanto sistemas mal otimizados exibem picos exponenciais além de certos limites de contexto.

Vazão de tokens—tokens processados por segundo através de sessões concorrentes—reflete tanto desempenho quanto eficiência de custo. Como a maioria das APIs cobra por token, a queda de vazão se traduz diretamente em ineficiência econômica.

Latência de dependências captura atrasos de sistemas de suporte: índices de busca vetorial, bases de conhecimento ou APIs de plugins. Estas podem dominar o tempo total de resposta mesmo quando a inferência é rápida.

Estabilidade de concorrência mede como o sistema se comporta sob carga simultânea. A latência cresce de forma previsível? As taxas de erro permanecem limitadas? Ou os tempos de resposta oscilam violentamente conforme as filas se formam?

Ao combinar essas métricas, equipes podem construir um quadro holístico do desempenho. O objetivo não é apenas medir velocidade—é entender onde e por que a degradação começa.

Projetando Testes de Carga Eficazes para Sistemas de IA

Com as métricas definidas, a estratégia de teste passa a ser sobre fidelidade da simulação. Agentes de IA não atendem requisições idênticas, então gravar uma única transação e reproduzi-la sob carga é inútil. Cada usuário sintético deve representar variação—prompts diferentes, comprimentos variados e comportamentos distintos. O objetivo não é uniformidade, mas realismo.

1. Modele todo o pipeline de raciocínio, não apenas o endpoint

Usuários reais não acessam /generate isoladamente. Eles autenticam, enviam contexto, invocam recuperação e então geram saída. Um teste de carga credível imita essa sequência. Pular uma camada e seus dados perdem significado.

2. Parametrize prompts para refletir diversidade real

Sistemas de IA desaceleram conforme o comprimento da entrada ou a complexidade semântica aumentam. Use templates de prompt variáveis que ajustem contagens de tokens, estruturas de frases ou profundidade de contexto embutido. Isso revela como o escalonamento afeta a distribuição dos tempos de resposta.

3. Aumente a concorrência gradualmente

Backends de IA frequentemente enfileiram requisições na camada de inferência. Em vez de pular instantaneamente para 1000 usuários, aumente gradualmente em estágios definidos—por exemplo, 10 → 50 → 100 → 200—mantendo cada nível por vários minutos. A curva resultante revela onde começa a saturação da GPU ou de threads.

4. Acompanhe custo junto com desempenho

Ao contrário de servidores web, APIs de inferência acarretam custo por token. Durante testes de carga, calcule o custo por requisição em cada nível de concorrência. Otimização de desempenho deve incluir eficiência econômica—modelos rápidos, porém caros, podem falhar financeiramente em escala mesmo que tecnicamente passem.

5. Inclua comportamento de retry e timeout

Endpoints de IA frequentemente limitam taxa ou degradam sob uso intenso. Simule a lógica de retry do cliente para observar efeitos de carga compostos. Um backoff exponencial ingênuo pode dobrar o tráfego efetivo quando falhas disparam.

Essas estratégias substituem o velho modelo de “gravar e reproduzir” por uma mentalidade de simulação comportamental. Em vez de testar transações, você está testando cognição—como o sistema pensa e escala simultaneamente.

Teste de Carga Impulsionado por IA: Deixe os Modelos Ajudarem

Ironicamente, a IA pode ajudar a resolver o próprio problema que cria. Plataformas modernas de teste estão começando a incorporar modelos de machine learning diretamente em seus loops de análise, produzindo o que frequentemente é chamado de teste de carga impulsionado por IA.

Aqui, a IA desempenha três papéis:

Geração de prompts

Em vez de criar manualmente centenas de entradas de teste, um modelo gerativo pode produzir variações de prompts que simulam a diversidade real de usuários. Ele pode ajustar tom, estrutura e contexto automaticamente, expondo o sistema a um leque mais amplo de padrões de estresse.

Detecção de anomalias

Modelos de IA podem detectar deriva estatística em dados de desempenho mais rápido do que limiares estáticos. Em vez de alertar apenas quando a latência excede um limite fixo, modelos de anomalia aprendem a variância normal e destacam outliers que sinalizam degradação genuína.

Análise preditiva de saturação

Analisando dados históricos de carga, a IA pode prever quando um sistema atingirá seu próximo penhasco de desempenho. Modelos de regressão ou preditores de séries temporais identificam padrões de escalonamento não lineares antes que quebrem a produção.

O benefício não é automação mágica, é aceleração. Engenheiros gastam menos tempo em manutenção repetitiva e mais tempo interpretando por que o desempenho muda. O teste de carga impulsionado por IA transforma scripts manuais em experimentação adaptativa.

Implementando Testes de Agentes de IA no LoadView

Agentes de IA podem ser de ponta, mas ainda se comunicam por protocolos familiares—HTTP, WebSocket ou APIs REST. Isso significa que você pode testá-los com a mesma infraestrutura que o LoadView já fornece.

Testes baseados em API são a base. Cada requisição de agente, independentemente da complexidade, acaba sendo uma chamada de API—frequentemente JSON sobre HTTPS. Os testes de API do LoadView permitem que equipes simulem milhares de requisições de inferência concorrentes, cada uma parametrizada com payloads dinâmicos. Você pode variar o tamanho do prompt, injetar contexto e medir latência de ponta a ponta.

Scripting UserView estende essa simulação pela interface do usuário. Muitos agentes de IA vivem dentro de dashboards, portais de chat ou integrações SaaS. Com o LoadView, você pode gravar fluxos completos—login, entrada de prompt, renderização de resposta—e reproduzi-los a partir de locais distribuídos na nuvem. Essa abordagem valida tanto o backend quanto o frontend sob condições reais de navegador.

Orquestração escalável amarra tudo. A rede em nuvem do LoadView distribui testes por geografia, permitindo que equipes vejam como o tráfego global afeta endpoints de IA que dependem de clusters centralizados de GPU. Correlacionando tempos de resposta com distância geográfica, você pode separar latência de rede de latência do modelo.

Analytics e relatórios completam o ciclo de feedback. O LoadView rastreia todas as métricas padrão de desempenho, mas também pode ser customizado para capturar dados específicos do modelo como tokens processados ou custo por sessão. Essa combinação transforma testes sintéticos em uma camada de observabilidade para desempenho de IA.

Em outras palavras, você não precisa de uma nova plataforma de testes para sistemas de IA—você precisa de um design de teste mais inteligente dentro de uma já existente. O LoadView já tem os elementos fundamentais, e essa nova classe de cargas simplesmente exige uma filosofia de teste diferente.

O Futuro dos Testes de Carga para IA

Sistemas de IA não são serviços estáticos—são adaptativos, estocásticos e continuamente re-treinados. Isso significa que suas características de desempenho mudam mesmo quando a infraestrutura permanece a mesma. Uma atualização de modelo que melhora a precisão pode dobrar o tempo de inferência. Uma mudança de prompt que aumenta a coerência pode explodir o tamanho do contexto. Os testes de carga devem evoluir para levar em conta esses alvos móveis.

Testes futuros de desempenho irão mesclar simulação, análises e loops de feedback auto-aprendentes. Os testes irão se adaptar em tempo real, expandindo ou restringindo a carga com base na estabilidade observada do modelo. Em vez de “rodar teste, ler relatório”, engenheiros manterão linhas de base contínuas de desempenho que se atualizam conforme os modelos derivam.

O foco vai além da vazão. A pergunta-chave não será “Consegue aguentar 1000 usuários?” mas “Consegue pensar de forma consistente sob pressão?” Medir a estabilidade cognitiva—como a qualidade do raciocínio se degrada quando a demanda sobe—virará uma métrica padrão.

Para organizações que implementam copilotos de IA, assistentes de chat e agentes de decisão automatizados, essa evolução já está em andamento. Os sistemas são novos, mas o princípio é imutável: você não pode melhorar o que não mede. O teste de carga sempre expôs limites ocultos. A IA apenas adiciona um novo tipo de limite—a fronteira entre desempenho e inteligência.

Teste de Carga para Agentes de IA – Concluindo

Agentes de IA introduzem uma nova dimensão aos testes de desempenho. Eles combinam computação pesada, contexto dinâmico e escalabilidade imprevisível. Scripts de teste tradicionais não acompanham, mas abordagens impulsionadas por IA podem. Focando em latência de inferência, escalonamento de contexto e estabilidade de concorrência—e usando ferramentas como o LoadView para simular fluxos completos de raciocínio—equipes podem preservar a confiabilidade mesmo quando a inteligência se torna o núcleo dos sistemas.

A próxima era do teste de carga não medirá apenas quão rápido os sistemas respondem. Medirá quão bem eles pensam quando todos perguntam ao mesmo tempo.