GraphQL mudou a forma como os frontends consomem dados — e, ao fazê-lo, mudou a forma como APIs falham sob pressão.

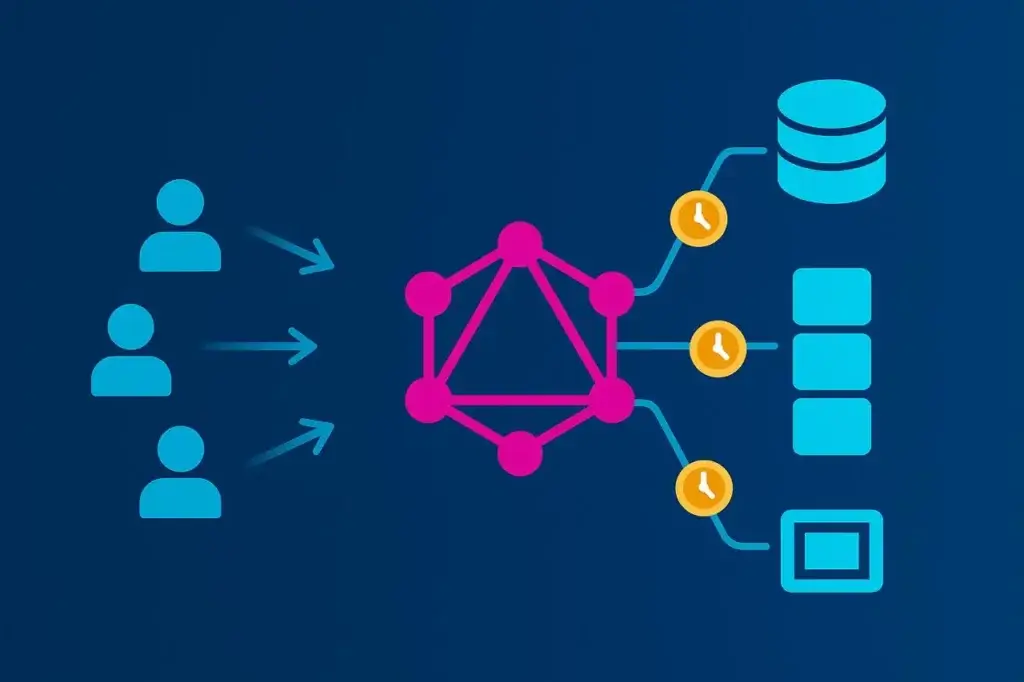

Ao contrário do REST, onde cada rota define quais dados retornam, o GraphQL inverte o controle. O cliente decide quais campos buscar, quão profundo navegar e com que frequência repetir a requisição. Essa flexibilidade é libertadora para desenvolvedores, mas torna o desempenho imprevisível. Duas consultas ao mesmo endpoint podem gerar cargas de trabalho de servidor totalmente diferentes.

Testes de carga tradicionais assumem consistência: um caminho fixo, payload previsível, latência mensurável. O GraphQL destrói essas suposições. Para testá-lo de forma eficaz, você precisa modelar a variabilidade das consultas, a profundidade dos resolvers e os padrões de concorrência que espelham o uso real. Caso contrário, você estará apenas testando seu cache — não sua API.

Este artigo detalha como projetar, executar e interpretar testes de carga que capturam o que realmente importa em um sistema GraphQL: custo dos resolvers, orquestração de back-end e o trade-off entre flexibilidade e escalabilidade.

Por que o Teste de Carga em GraphQL é Diferente

A maioria dos testes de carga é construída sobre repetição. Você grava uma transação de API e a reproduz em escala, medindo quanto tempo leva para ser concluída. Isso funciona bem para REST. Cada chamada /api/orders retorna aproximadamente o mesmo payload, exercita a mesma lógica e custa mais ou menos o mesmo em termos de processamento.

GraphQL, por outro lado, executa um planejador de consultas personalizado para cada requisição. Cada solicitação do cliente define sua própria carga de trabalho:

- Algumas buscam um ou dois campos.

- Outras mergulham cinco camadas em relacionamentos aninhados.

- Muitas combinam queries e mutations em uma única chamada.

Para o gerador de carga, tudo parece um único POST /graphql — mas sob a superfície, seus servidores podem estar fazendo 50 consultas ao banco de dados, distribuindo chamadas para meia dúzia de microserviços e serializando centenas de campos JSON.

Por isso o teste de carga de GraphQL não pode ser tratado como um simples teste de taxa de transferência. Não se trata de quantas requisições por segundo você consegue suportar. Trata-se de como o formato da consulta shape direciona o comportamento do back-end. O “jeito certo” significa projetar testes que reflitam essa variabilidade em vez de escondê-la.

O Custo Oculto da Complexidade das Consultas

Uma das características mais mal compreendidas do GraphQL é o quão custoso ele pode se tornar com profundidade. Uma consulta aparentemente inofensiva pode virar uma bomba computacional quando se desenrola por resolvers aninhados.

Considere um esquema básico de e-commerce:

query GetCustomer {

customer(id: "42") {

name

orders {

id

total

products {

id

name

price

}

}

}

}

No papel, isso parece simples. Mas se cada resolver chama o banco de dados separadamente — um para o cliente, um para cada pedido, um por produto — você acabou de multiplicar o custo da consulta exponencialmente. O infame “problema N+1” transforma uma única requisição do cliente em um enxame de chamadas no back-end.

Agora imagine 1.000 usuários virtuais atingindo essa consulta em paralelo. Você não está mais testando um endpoint; você está testando cada tabela do banco de dados e cada microserviço a jusante. O desafio não é apenas a concorrência — é entender ondeO que Medir (e Por Quê)

Métricas de desempenho para GraphQL devem ser vistas em camadas: query, resolver e sistema. Cada uma conta uma parte diferente da história.

No nível da query, foque em:

- Distribuições de latência (p50, p95, p99) para ver como consultas complexas distorcem a performance de cauda.

- Throughput (QPS) — útil principalmente como métrica contextual, não como objetivo em si.

- Taxas de erro e timeout para detectar degradação induzida pela carga.

No nível do resolver, colete dados de instrumentação sempre que possível:

- Tempo de execução por resolver ou por campo.

- Número de invocações de resolver por consulta.

- Taxas de acerto/erro de cache.

- Latência de chamadas a sistemas a jusante (bancos de dados, APIs externas).

No nível do sistema, correlacione essas métricas com a utilização da infraestrutura — CPU, memória, contagem de threads e saturação de pools de conexão. Servidores GraphQL frequentemente ficam limitados por CPU durante picos de carga devido ao parsing de consultas e à serialização de resolvers, então seu gargalo pode nem estar no banco de dados.

Tempos de resposta brutos sozinhos não dizem muito. Correlacionar execução de resolvers com telemetria de infraestrutura é como isolar restrições reais de escalabilidade.

Construindo um Modelo de Carga Realista para GraphQL

GraphQL não é uma única API — é uma interface para dezenas. Para testá-lo realisticamente, você precisa refletir essa diversidade.

Comece minerando o tráfego de produção ou logs de acesso pelos nomes de operações e assinaturas de consultas. Isso revela a mistura real do comportamento do cliente — consultas curtas, agregações profundas, mutations e, ocasionalmente, consultas “abusivas” que pedem tudo.

A partir daí:

- Pese as consultas pela frequência. Sua mistura de teste deve espelhar as proporções de produção — 80% consultas leves, 20% consultas complexas, por exemplo.

- Randomize os valores das variáveis para que camadas de cache não distorçam os resultados.

- Inclua fluxos de autenticação quando relevante. Geração de tokens, validação de sessão e limitação de taxa podem se tornar pontos de estrangulamento sob carga.

- Modele padrões de concorrência. Usuários reais não chegam de forma constante. Simule rajadas, ramp-ups e vales de inatividade para ver como o autoscaling se comporta.

Um teste de carga que apenas repete uma consulta é como um teste de estresse que só atinge sua página inicial — parece tudo bem até que o mundo real apareça. Quanto mais representativa for sua carga de trabalho, mais valiosos serão seus dados.

Executando Testes de Carga em GraphQL

Testar GraphQL de forma eficaz significa sobrepor realismo e escala. A flexibilidade da API exige tanto testes controlados baseados em scripts quanto execuções distribuídas que simulem condições reais de usuários.

Teste Baseado em HTTP com Scripts

JMeter continua sendo uma base sólida para testes de carga em GraphQL. Como GraphQL opera sobre requisições HTTP POST padrão, você pode definir queries como payloads JSON, injetar variáveis dinamicamente e parametrizar tokens ou dados de sessão dentro de um plano de teste JMeter.

Essa abordagem dá controle total sobre concorrência, headers e estrutura de payload — ideal para validar o desempenho do back-end sob uma mistura realista de consultas. É leve e repetível, mas conta apenas parte da história: o tempo de resposta ao nível do protocolo. Não considera latência de rede ou comportamento do navegador.

Escalando Testes com o LoadView

Para sair de execuções locais do JMeter e validar em escala de produção, o LoadView fornece uma camada de execução gerenciada criada especificamente para testes distribuídos. Ele executa seus scripts JMeter em múltiplas localidades geográficas, introduzindo latência e variabilidade de banda do mundo real que ambientes locais não conseguem simular.

O LoadView estende a mesma flexibilidade de scripting enquanto lida com toda a orquestração:

- Importe planos JMeter existentes diretamente.

- Execute requisições POST GraphQL com variáveis dinâmicas e tokens de autenticação.

- Execute usuários concorrentes em regiões globais para dados de performance realistas.

- Visualize percentis de latência, throughput e tendências de erro em tempo real.

Essa abordagem híbrida — usar JMeter para definição de testes e LoadView para execução distribuída — oferece precisão e escala. Equipes podem iterar rapidamente durante o desenvolvimento e depois validar em carga total antes do lançamento, usando a mesma lógica de teste de ponta a ponta.

Teste ao Nível do Navegador

Quando o GraphQL alimenta frontends voltados ao usuário, vale a pena validar como o desempenho se sente no nível do navegador. O LoadView também pode executar cenários baseados em navegador, renderizando páginas e disparando requisições GraphQL através de navegadores reais. Isso mede tempos de transação completos — incluindo renderização, atrasos de rede e comportamento de cache — oferecendo uma visão de ponta a ponta da experiência do usuário sob carga.

Usadas em conjunto, essas camadas — testes HTTP scriptados e execuções ao nível do navegador — criam um modelo realista de como o GraphQL realmente se comporta quando centenas ou milhares de usuários consultam simultaneamente.

Evitar os Erros Clássicos de Teste

Testes de desempenho em GraphQL estão cheios de armadilhas que tornam os dados sem sentido. O pior é que a maioria delas parece sucesso até que a produção prove o contrário.

Um erro frequente é testar uma única consulta estática. Isso dá números limpos e consistentes — e não diz nada sobre como o sistema lida com diversidade.

Outro é ignorar o estado do cache. A primeira execução acerta o banco, e as cinco seguintes batem no Redis, e de repente o desempenho parece ótimo. Sempre execute cenários com cache frio e quente.

Uma armadilha mais sutil é não considerar a variabilidade ao nível do resolver. Sem dados de tracing, você não consegue dizer se uma resposta lenta veio de uma consulta pesada ou de um problema transitório no back-end. Hooks de timing de resolver ou extensões de tracing (Apollo Tracing, GraphQL Yoga, etc.) ajudam a separar custo de consulta de ruído da infraestrutura.

Por fim, não confunda teste de carga com caos. O objetivo não é derrubar sua API — é encontrar a inclinação onde a latência começa a subir. Depois desse ponto, você está medindo falha, não desempenho.

A mentalidade correta é diagnóstica, não destrutiva.

Interpretando Resultados de Teste de Carga em GraphQL e Agindo

Testar carga não é apenas coletar dados; é traduzi-los em decisões.

Comece pela correlação. Se picos de latência se alinham com contagens de chamadas de resolvers, você encontrou um problema N+1. Se a CPU sobe enquanto as métricas do banco ficam estáveis, seu gargalo está no parsing da consulta ou na serialização da resposta.

A partir daí, abrem-se caminhos de otimização:

- Agrupe resolvers usando dataloaders ou joins a nível de consulta para reduzir fetches redundantes.

- Adicione cache no nível de resolver ou de objeto para cortar trabalho duplicado.

- Implemente pontuação de complexidade de consulta para que a API possa rejeitar ou limitar consultas patológicas antes que elas derretam o back-end.

- Introduza consultas persistidas — operações pré-aprovadas armazenadas no servidor — para eliminar overhead de parsing e limitar comportamento imprevisível do cliente.

Depois que as melhorias forem aplicadas, execute novamente o mesmo modelo de carga. Otimizar sem retestar é como depurar sem logs — você está chutando.

Tornar o Teste de Carga em GraphQL Contínuo

Um teste de carga pontual é apenas uma caixa de conformidade. Um teste contínuo é uma vantagem de engenharia.

Esquemas GraphQL evoluem constantemente à medida que produtos crescem. Novos campos, novos joins e novas funcionalidades de cliente mudam as características de desempenho. Cada alteração no esquema pode alterar sutilmente caminhos de resolver ou volumes de dados.

Integre testes de carga reduzidos em pipelines de CI/CD — suficientes para captar regressões antes do deploy. Mantenha seus conjuntos de consultas atualizados conforme o tráfego de produção evolui. Agende testes mais aprofundados mensalmente ou antes de grandes lançamentos para validar que as otimizações ainda se mantêm.

Trate desempenho como parte do ciclo de vida do esquema, não como uma fase separada. No GraphQL, todo novo campo é uma potencial responsabilidade de desempenho até que seja comprovado o contrário.

Conclusão

O poder do GraphQL está em sua flexibilidade. Essa mesma flexibilidade facilita construir uma API que parece perfeita sob testes leves, mas desaba sob a variedade do mundo real.

A maneira certa de testar carga em GraphQL não é sobre números brutos — é sobre contexto. Simule consultas reais, meça o custo de sua profundidade e complexidade, e trace como cada uma se espalha pelos sistemas. Entenda a inclinação onde o desempenho começa a degradar, não apenas o ponto onde quebra.

Para equipes que executam esses testes em escala, o LoadView ajuda a estender o processo além do laboratório. Ao executar cenários JMeter ou dirigidos por navegador de múltiplas regiões globais, fornece uma imagem mais fiel do desempenho sob condições reais da internet — latência, variabilidade e tudo mais.

Usado dessa forma, o LoadView deixa de ser apenas uma ferramenta e torna-se um campo de provas: o ambiente onde APIs flexíveis enfrentam demanda do mundo real. Faça isso, e o teste de carga deixa de ser um ritual técnico — passa a ser um mapa de como sua arquitetura realmente se comporta quando a liberdade encontra escala.