Les agents d’IA redéfinissent ce que signifie la « charge ». Les tests de charge traditionnels ont été conçus pour les pages web, les API et les transactions — des systèmes qui se comportent de manière prévisible sous contrainte. Les charges de travail pilotées par l’IA ne le sont pas. Leurs entrées varient en longueur, en complexité et en contexte. Leur traitement est probabiliste, pas déterministe. Leur performance dépend autant de l’ordonnancement GPU et de la génération de tokens que de la latence réseau ou du débit du back-end.

Ce changement brise les hypothèses sur lesquelles la plupart des tests de charge ont été construits. On ne peut pas traiter un agent d’IA comme un autre point de terminaison d’API. Chaque requête est une conversation, pas un clic. Chaque réponse dépend de la précédente. Et chaque session s’alourdit à mesure que le contexte s’accumule.

Pour maintenir la fiabilité de ces systèmes, les ingénieurs performance ont besoin d’un nouveau manuel — un manuel qui comprend comment simuler un raisonnement concurrent, pas seulement un trafic concurrent. Cet article expose des stratégies modernes, alimentées par l’IA, pour tester des agents à l’échelle et les garder performants à mesure que la complexité augmente.

Défis de performance dans les tests de charge des agents d’IA

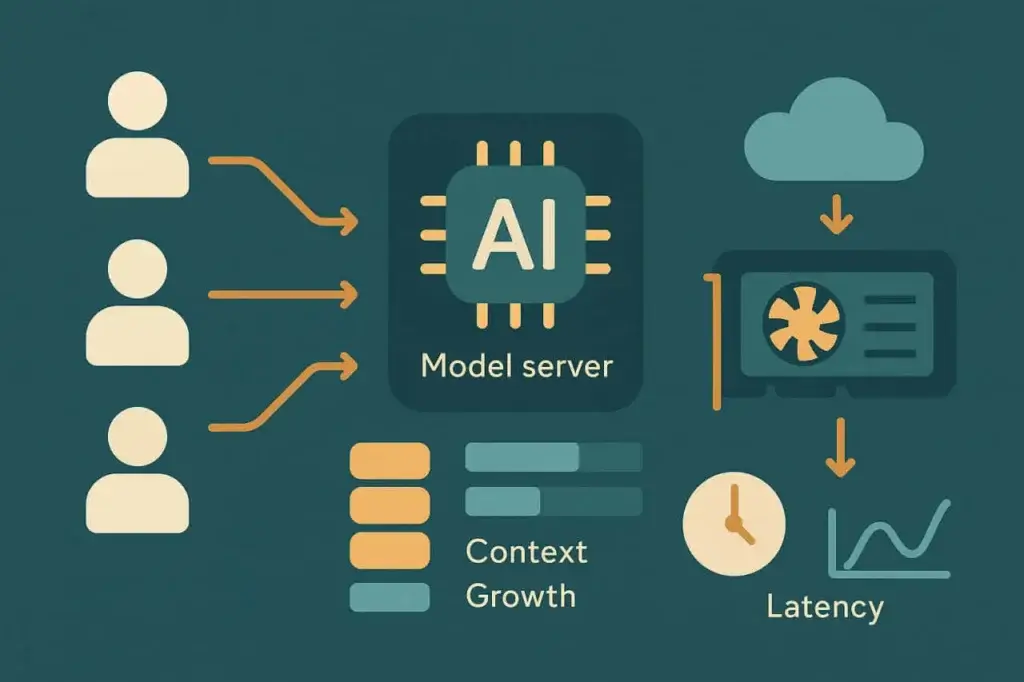

Les charges de travail IA ne se comportent pas comme le trafic web ou mobile. Chaque « utilisateur » dans un système piloté par l’IA peut représenter une série d’opérations en chaîne : une expansion de prompt, la récupération de contexte pertinent, l’inférence du modèle et le post-traitement ou l’exécution d’outils. La charge n’est pas fixe — elle évolue à chaque tour d’interaction.

À mesure que ces couches s’empilent, la dégradation des performances devient non linéaire. Une augmentation de 2x du nombre d’utilisateurs simultanés ne signifie pas 2x de latence — cela peut signifier 5x, selon la charge du modèle, la mémoire et l’allocation GPU. Les métriques traditionnelles de tests de charge comme les requêtes par seconde ou le temps de réponse moyen ne saisissent pas ces dynamiques sous-jacentes. Ce qui compte ici est l’élasticité de la latence — la façon dont la performance fléchit à mesure que les sessions se multiplient.

Il existe plusieurs facteurs de stress récurrents dans les systèmes d’agents IA :

Accumulation du contexte

Chaque requête utilisateur transporte un contexte historique — parfois des milliers de tokens de conversation ou de données de documents antérieurs. À mesure que la longueur du contexte augmente, la taille du prompt gonfle et le temps d’inférence du modèle augmente. À grande échelle, cela crée des pics de latence imprévisibles et une pression d’attente sur les GPU.

Mise à l’échelle liée au calcul

Contrairement aux serveurs web, l’inférence de grands modèles ne peut pas toujours s’étendre horizontalement. Les poids du modèle et les fenêtres de contexte consomment une mémoire GPU fixe ; dépasser la capacité signifie mettre les requêtes en file d’attente ou basculer vers des modèles plus petits. Cela rend les limites de concurrence beaucoup plus strictes que pour les systèmes basés sur le CPU.

Latence de récupération

Beaucoup d’agents récupèrent des données externes — via des bases de données vectorielles, des API ou des magasins de documents — avant de générer une réponse. Ces dépendances ajoutent une latence d’E/S et deviennent le premier goulot d’étranglement lors de pics de trafic.

Persistance de session

Les tests de charge traditionnels rejouent des requêtes sans état. Les sessions IA sont étatful. Chacune porte en elle de la mémoire, des embeddings et du contexte mis en cache. Plus la conversation dure, plus l’empreinte de la session est lourde.

Ces facteurs se combinent en un nouveau profil de contrainte. Le système peut sembler sain à 100 utilisateurs concurrents mais fléchir à 120, non pas par exhaustion de la bande passante mais par saturation des files GPU ou débordement du cache de contexte. Tester la charge des systèmes IA signifie révéler où commencent ces points d’inflexion non linéaires.

Comprendre le comportement des charges de travail d’agents d’IA

Avant de concevoir des tests, il est utile de modéliser comment un agent d’IA se comporte réellement sous le capot. La plupart des agents de production suivent un pipeline similaire :

- Ingestion d’entrée. L’utilisateur envoie une requête ou un message.

- Assemblage du contexte. L’agent collecte les données pertinentes des tours précédents ou d’une source externe.

- Inférence du modèle. Le prompt assemblé est envoyé à un point de terminaison de modèle local ou distant.

- Post-traitement. La sortie peut être analysée, validée ou enrichie avant d’être renvoyée.

- Livraison de la réponse. L’agent met à jour l’état de l’interface ou envoie une réponse API.

Chaque étape ajoute de la variabilité. Le temps d’inférence augmente à peu près en fonction du nombre de tokens en entrée et en sortie. La latence de récupération dépend de la proximité de la base de données et des taux de hit du cache. Le coût d’assemblage du contexte augmente à chaque tour de conversation.

Pour comprendre le comportement des performances, il faut observer comment ces dimensions interagissent. Par exemple, doubler la longueur du prompt peut augmenter le temps d’inférence moyen de 60 %, mais une concurrence au-delà d’un certain seuil peut l’augmenter de 300 %. Ces courbes importent plus que n’importe quelle métrique isolée.

En pratique, cartographier le comportement de la charge implique d’exécuter des tests de montée progressive. Commencez avec quelques sessions simultanées, capturez la latence de base, puis augmentez progressivement. Surveillez comment le débit de tokens, les temps de file d’attente et l’utilisation GPU réagissent. Chaque agent a sa propre signature de mise à l’échelle, et la trouver est la première étape vers des opérations fiables.

Métriques principales à mesurer dans les tests de charge des agents d’IA

Les métriques traditionnelles — RPS, TTFB, taux d’erreur — s’appliquent toujours, mais elles ne racontent pas toute l’histoire. Les tests de charge pour agents d’IA introduisent de nouvelles métriques qui reflètent comment l’intelligence, et non seulement l’infrastructure, se met à l’échelle.

Latence d’inférence mesure le temps total entre la soumission du prompt et la réponse complète du modèle. C’est le signal de performance le plus direct mais il doit être suivi en parallèle de la taille de l’entrée et du type de modèle. Comparer de simples moyennes sans normalisation par taille de contexte peut être trompeur.

Mise à l’échelle du contexte quantifie comment la latence croît à mesure que la fenêtre de prompt s’élargit. Les ingénieurs peuvent tracer le temps de réponse en fonction du nombre de tokens pour visualiser la courbe de coût. Un système bien optimisé montre une mise à l’échelle linéaire ou sous-linéaire, tandis que les systèmes mal optimisés présentent des pics exponentiels au-delà de certains seuils de contexte.

Débit de tokens — tokens traités par seconde sur l’ensemble des sessions concurrentes — reflète à la fois la performance et l’efficacité des coûts. Étant donné que la plupart des API facturent par token, une baisse du débit se traduit directement par une inefficacité économique.

Latence des dépendances capture les délais provenant des systèmes de support : recherches vectorielles, bases de connaissances ou API de plugins. Ceux-ci peuvent dominer le temps de réponse total même lorsque l’inférence est rapide.

Stabilité de la concurrence mesure comment le système se comporte sous charge simultanée. La latence augmente-t-elle de manière prévisible ? Les taux d’erreur restent-ils contenus ? Ou les temps de réponse oscillent-ils violemment à mesure que des files d’attente se forment ?

En combinant ces métriques, les équipes peuvent construire une image holistique des performances. L’objectif n’est pas seulement de mesurer la vitesse — c’est de comprendre où et pourquoi la dégradation commence.

Concevoir des tests de charge efficaces pour les systèmes IA

Avec les métriques définies, la stratégie de test devient une question de fidélité de simulation. Les agents d’IA ne servent pas des requêtes identiques, donc enregistrer une seule transaction et la rejouer sous charge est inutile. Chaque utilisateur synthétique doit représenter de la variation — différents prompts, longueurs et comportements. L’objectif n’est pas l’uniformité mais le réalisme.

1. Modéliser tout le pipeline de raisonnement, pas seulement le point de terminaison

Les vrais utilisateurs ne frappent pas /generate en isolation. Ils s’authentifient, soumettent du contexte, invoquent la récupération, puis génèrent la sortie. Un test de charge crédible imite cette séquence. Sauter une couche et vos données deviennent sans valeur.

2. Paramétrer les prompts pour refléter la diversité réelle

Les systèmes IA ralentissent à mesure que la longueur d’entrée ou la complexité sémantique augmente. Utilisez des modèles de prompts variables qui ajustent le nombre de tokens, les structures de phrase ou la profondeur du contexte intégré. Cela met en évidence comment la mise à l’échelle affecte la distribution des temps de réponse.

3. Monter progressivement la concurrence

Les backends IA mettent souvent les requêtes en file au niveau de l’inférence. Au lieu de passer instantanément à 1000 utilisateurs, augmentez progressivement selon des paliers définis — par exemple 10 → 50 → 100 → 200 — en maintenant chaque palier plusieurs minutes. La courbe résultante révèle où la saturation GPU ou des threads commence.

4. Suivre le coût en parallèle de la performance

Contrairement aux serveurs web, les API d’inférence entraînent un coût par token. Lors des tests de charge, calculez le coût par requête à chaque niveau de concurrence. L’optimisation des performances doit inclure l’efficacité économique — des modèles rapides mais coûteux peuvent échouer à l’échelle financièrement même s’ils passent techniquement.

5. Inclure le comportement de retry et de timeout

Les points de terminaison IA limitent souvent le débit ou se dégradent sous forte utilisation. Simulez la logique de retry du client pour observer les effets de charge composés. Un backoff exponentiel naïf peut doubler le trafic effectif lorsque les échecs augmentent.

Ces stratégies remplacent l’ancien modèle « enregistrer et rejouer » par une mentalité de simulation comportementale. Au lieu de tester des transactions, vous testez la cognition — comment le système raisonne et se met à l’échelle simultanément.

Tests de charge assistés par l’IA : laisser les modèles aider

Ironicement, l’IA peut aider à résoudre le problème qu’elle crée. Les plateformes de test modernes intègrent désormais des modèles d’apprentissage automatique directement dans leurs boucles d’analyse, produisant ce qu’on appelle souvent des tests de charge assistés par l’IA.

Ici, l’IA joue trois rôles :

Génération de prompts

Plutôt que de créer manuellement des centaines d’entrées de test, un modèle génératif peut produire des variations de prompts qui simulent la diversité réelle des utilisateurs. Il peut ajuster le ton, la structure et le contexte automatiquement, exposant le système à une gamme plus large de schémas de contrainte.

Détection d’anomalies

Les modèles d’IA peuvent détecter la dérive statistique dans les données de performance plus rapidement que des seuils statiques. Plutôt que d’alerter lorsque la latence dépasse une limite fixe, les modèles d’anomalie apprennent la variance normale et mettent en évidence les valeurs aberrantes qui signalent une vraie dégradation.

Analyse prédictive de saturation

En analysant les données historiques de charge, l’IA peut prévoir quand un système atteindra son prochain point critique de performance. Les modèles de régression ou les prédicteurs de séries temporelles identifient les schémas de mise à l’échelle non linéaires avant qu’ils ne cassent la production.

Le bénéfice n’est pas une automatisation magique, c’est une accélération. Les ingénieurs consacrent moins de temps à la maintenance répétitive et plus de temps à interpréter pourquoi la performance change. Les tests de charge assistés par l’IA transforment le scripting manuel en expérimentation adaptative.

Implémentation des tests d’agents IA dans LoadView

Les agents d’IA peuvent être à la pointe, mais ils communiquent toujours via des protocoles familiers — HTTP, WebSocket ou API REST. Cela signifie que vous pouvez les tester avec la même infrastructure que LoadView fournit déjà.

Les tests basés sur l’API sont la base. Chaque requête d’agent, quelle que soit sa complexité, se résout finalement en un appel API — souvent du JSON sur HTTPS. Les tests d’API de LoadView permettent aux équipes de simuler des milliers de requêtes d’inférence concurrentes, chacune paramétrée avec des charges dynamiques. Vous pouvez varier la taille du prompt, injecter du contexte et mesurer la latence de bout en bout.

Le scripting UserView étend cette simulation via l’interface utilisateur. Beaucoup d’agents vivent dans des tableaux de bord, portails de chat ou intégrations SaaS. Avec LoadView, vous pouvez enregistrer des workflows complets — connexion, saisie du prompt, rendu de la réponse — et les rejouer depuis des emplacements cloud distribués. Cette approche valide à la fois le back-end et le front-end sous des conditions de navigateur réelles.

L’orchestration évolutive relie le tout. Le réseau cloud de LoadView distribue les tests à travers les géographies, permettant aux équipes de voir comment le trafic global affecte des points de terminaison IA dépendant de clusters GPU centralisés. En corrélant les temps de réponse avec la distance géographique, vous pouvez séparer la latence réseau de la latence du modèle.

Les analyses et rapports complètent la boucle de rétroaction. LoadView suit toutes les métriques de performance standard mais peut aussi être personnalisé pour capturer des données spécifiques au modèle comme les tokens traités ou le coût par session. Cette combinaison transforme les tests synthétiques en une couche d’observabilité pour la performance IA.

Autrement dit, vous n’avez pas besoin d’une nouvelle plateforme de test pour les systèmes IA — vous avez besoin d’une conception de test plus intelligente au sein d’une plateforme existante. LoadView dispose déjà des primitives, et cette nouvelle catégorie de charges de travail exige simplement une philosophie de test différente.

L’avenir des tests de charge pour l’IA

Les systèmes IA ne sont pas des services statiques — ils sont adaptatifs, stochastiques et continuellement réentraînés. Cela signifie que leurs caractéristiques de performance changent même si l’infrastructure reste la même. Une mise à jour de modèle qui améliore la précision peut doubler le temps d’inférence. Un changement de prompt qui augmente la cohérence peut faire exploser la taille du contexte. Les tests de charge doivent évoluer pour tenir compte de ces cibles mouvantes.

Les futurs tests de performance mêleront simulation, analyse et boucles de rétroaction auto-apprenantes. Les tests s’adapteront en temps réel, élargissant ou réduisant la charge en fonction de la stabilité observée du modèle. Au lieu de « lancer un test, lire un rapport », les ingénieurs maintiendront des bases de référence de performance continues qui se mettent à jour à mesure que les modèles dérivent.

L’accent se déplacera au-delà du débit. La question clé ne sera plus « Peut-il gérer 1000 utilisateurs ? » mais « Peut-il réfléchir de manière cohérente sous pression ? » Mesurer la stabilité cognitive — comment la qualité du raisonnement se dégrade lorsque la demande augmente — deviendra une métrique standard.

Pour les organisations déployant des copilotes IA, assistants de chat et agents de décision automatisés, cette évolution est déjà en cours. Les systèmes sont nouveaux, mais le principe reste intemporel : on ne peut pas améliorer ce que l’on ne mesure pas. Les tests de charge ont toujours été la discipline qui expose les limites cachées. L’IA ajoute simplement une nouvelle limite — la frontière entre la performance et l’intelligence.

Tests de charge pour agents d’IA – En résumé

Les agents d’IA introduisent une nouvelle dimension aux tests de performance. Ils combinent calcul intensif, contexte dynamique et mise à l’échelle imprévisible. Les scripts de tests traditionnels ne suffisent plus, mais les approches assistées par l’IA peuvent aider. En se concentrant sur la latence d’inférence, la mise à l’échelle du contexte et la stabilité de la concurrence — et en utilisant des outils comme LoadView pour simuler des workflows de raisonnement complets — les équipes peuvent préserver la fiabilité même lorsque l’intelligence devient le cœur de leurs systèmes.

La prochaine ère des tests de charge ne mesurera pas seulement la rapidité des réponses. Elle mesurera la capacité des systèmes à réfléchir quand tout le monde pose des questions en même temps.