GraphQL a changé la façon dont les frontends consomment les données — et, ce faisant, il a changé la façon dont les API échouent sous pression.

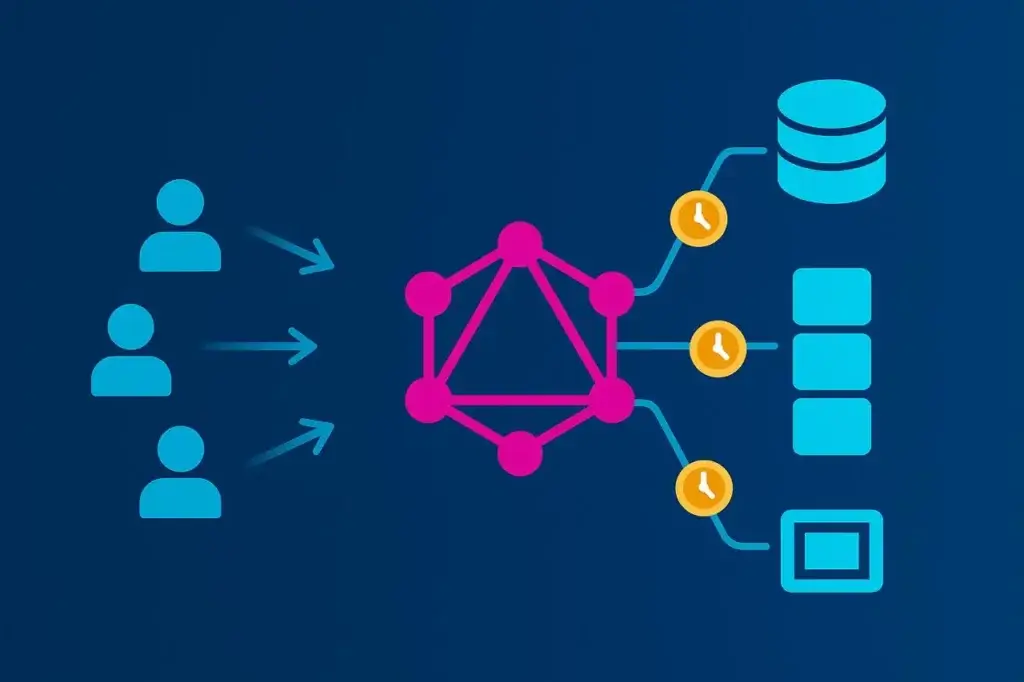

Contrairement au REST, où chaque route définit les données retournées, GraphQL inverse le contrôle. Le client décide quels champs récupérer, jusqu’où creuser et à quelle fréquence répéter la requête. Cette flexibilité est libératrice pour les développeurs, mais elle rend la performance imprévisible. Deux requêtes vers le même endpoint peuvent générer des charges serveurs radicalement différentes.

Les tests de charge traditionnels supposent la consistance : un chemin fixe, un payload prévisible, une latence mesurable. GraphQL brise ces hypothèses. Pour le tester efficacement, vous devez modéliser la variance des requêtes, la profondeur des resolvers et les schémas de concurrence qui reflètent l’utilisation réelle. Sinon, vous ne testez que votre cache — pas votre API.

Cet article explique comment concevoir, exécuter et interpréter des tests de charge qui capturent ce qui compte réellement dans un système GraphQL : le coût des resolvers, l’orchestration du back-end et le compromis entre flexibilité et scalabilité.

Pourquoi le test de charge GraphQL est différent

La plupart des tests de charge sont basés sur la répétition. Vous enregistrez une transaction d’API et la rejouez à grande échelle, en mesurant le temps nécessaire à son exécution. Cela fonctionne bien pour le REST. Chaque appel /api/orders renvoie à peu près le même payload, exerce la même logique et coûte à peu près la même chose en calcul.

GraphQL, en revanche, exécute un planificateur de requêtes personnalisé pour chaque requête. Chaque requête client définit sa propre charge de travail :

- Certaines récupèrent un ou deux champs.

- D’autres plongent cinq couches dans des relations imbriquées.

- Beaucoup combinent queries et mutations dans un seul appel.

Pour le générateur de charge, tout ressemble à un unique POST /graphql — mais sous la surface, vos serveurs peuvent effectuer 50 requêtes en base de données, se déployer vers une demi-douzaine de microservices et sérialiser des centaines de champs JSON.

C’est pourquoi le test de charge GraphQL ne peut pas être traité comme un simple test de débit. Il ne s’agit pas du nombre de requêtes par seconde que vous pouvez supporter. Il s’agit de la manière dont la forme de la requête pilote le comportement du back-end. La « bonne manière » consiste à concevoir des tests qui reflètent cette variabilité au lieu de la masquer.

Le coût caché de la complexité des requêtes

L’une des caractéristiques les moins comprises de GraphQL est le coût qu’il peut engendrer avec la profondeur. Une requête apparemment innocente peut se transformer en bombe computationnelle lorsqu’elle se déroule à travers des resolvers imbriqués.

Prenez un schéma e-commerce basique :

query GetCustomer {

customer(id: "42") {

name

orders {

id

total

products {

id

name

price

}

}

}

}

Sur le papier, cela semble simple. Mais si chaque resolver appelle la base de données séparément — un pour le client, un pour chaque commande, un par produit — vous venez de multiplier le coût de la requête de façon exponentielle. L’infâme problème « N+1 » transforme une seule requête client en un essaim d’appels côté back-end.

Imaginez maintenant 1 000 utilisateurs virtuels frappant cette requête en parallèle. Vous ne testez plus un endpoint ; vous testez chaque table de la base de données et chaque microservice en aval. Le défi ne se résume pas à la concurrence — il faut comprendre où cette concurrence se manifeste.

Pour rendre le test de charge pertinent, vous avez besoin de visibilité au niveau des resolvers. La profondeur des requêtes et le nombre de resolvers doivent faire partie de votre profil de test, pas seulement le temps de réponse. Sinon, vous ne verrez que la fumée, pas le feu.

Ce qu’il faut mesurer (et pourquoi)

Les métriques de performance pour GraphQL doivent être vues en couches : requête, resolver et système. Chacune raconte une part différente de l’histoire.

Au niveau requête, concentrez-vous sur :

- Les distributions de latence (p50, p95, p99) pour voir comment les requêtes complexes déforment la performance en queue.

- Le throughput (QPS) — utile surtout comme métrique contextuelle, pas comme objectif en soi.

- Les taux d’erreur et de timeout pour détecter la dégradation induite par la charge.

Au niveau resolver, collectez des données d’instrumentation autant que possible :

- Temps d’exécution par resolver ou par champ.

- Nombre d’invocations de resolver par requête.

- Taux de hits/misses du cache.

- Latence des appels en aval (bases de données, API externes).

Au niveau système, reliez ces métriques à l’utilisation de l’infrastructure — CPU, mémoire, nombre de threads et saturation des pools de connexions. Les serveurs GraphQL sont souvent limités par la CPU lors des pics de charge à cause du parsing des requêtes et de la sérialisation des resolvers, donc votre goulet d’étranglement peut ne pas se situer dans la base de données.

Les temps de réponse bruts seuls ne vous diront pas grand-chose. Corréler l’exécution des resolvers avec la télémétrie d’infrastructure permet d’isoler les véritables contraintes de scalabilité.

Construire un modèle de charge réaliste pour GraphQL

GraphQL n’est pas une API unique — c’est une interface pour des dizaines. Pour le tester de manière réaliste, vous devez refléter cette diversité.

Commencez par extraire du trafic de production ou des logs d’accès les noms d’opération et signatures de requêtes. Ils révèlent le mélange réel du comportement client — recherches courtes, agrégations profondes, mutations et, occasionnellement, des requêtes « abusives » qui demandent tout.

Ensuite :

- Pesez les requêtes par fréquence. Votre mix de test doit refléter les proportions de production — 80 % de requêtes légères, 20 % de requêtes imbriquées complexes, par exemple.

- Randomisez les valeurs des variables afin que les couches de cache ne faussent pas les résultats.

- Incluez les flux d’authentification lorsque pertinent. La génération de tokens, la validation de sessions et le rate limiting peuvent tous devenir des points d’étranglement sous charge.

- Modelez les schémas de concurrence. Les utilisateurs réels n’arrivent pas de façon uniforme. Simulez des rafales, des ramp-ups et des creux d’activité pour voir comment l’autoscaling se comporte.

Un test de charge qui rejoue une seule requête revient à un test de stress qui n’atteint que votre page d’accueil — tout paraît correct jusqu’à l’arrivée du monde réel. Plus votre charge de travail est représentative, plus vos données seront utiles.

Exécution des tests de charge GraphQL

Tester efficacement GraphQL signifie superposer réalisme et échelle. La flexibilité de l’API exige à la fois des tests scriptés contrôlés et des exécutions distribuées qui simulent des conditions utilisateurs réelles aux différents endroits.

Tests scriptés basés sur HTTP

JMeter reste une base solide pour les tests de charge GraphQL. Puisque GraphQL fonctionne via des requêtes HTTP POST standard, vous pouvez définir les queries comme des payloads JSON, injecter des variables dynamiquement et paramétrer les tokens ou données de session dans un plan de test JMeter.

Cette approche offre un contrôle total sur la concurrence, les en-têtes et la structure des payloads — idéal pour valider les performances du back-end sous un mix de requêtes réaliste. C’est léger et répétable, mais cela ne raconte qu’une partie de l’histoire : le temps de réponse au niveau du protocole. Cela ne prend pas en compte la latence réseau ou le comportement du navigateur.

Monter en charge avec LoadView

Pour passer des exécutions JMeter locales à une validation à l’échelle production, LoadView fournit une couche d’exécution gérée spécifiquement conçue pour les tests distribués. Il exécute vos scripts JMeter depuis plusieurs emplacements géographiques, introduisant la latence et la variabilité de bande passante du monde réel qu’un environnement local ne peut pas simuler.

LoadView étend la même flexibilité de scripting tout en gérant l’orchestration :

- Importez directement des plans JMeter existants.

- Exécutez des requêtes POST GraphQL avec variables dynamiques et tokens d’authentification.

- Exécutez des utilisateurs concurrents depuis des régions globales pour des données réalistes de performance.

- Visualisez les percentiles de latence, le throughput et les tendances d’erreur en temps réel.

Cette approche hybride — utiliser JMeter pour définir les tests et LoadView pour l’exécution distribuée — offre précision et échelle. Les équipes peuvent itérer rapidement en développement, puis valider en charge complète avant la mise en production, en utilisant la même logique de test de bout en bout.

Tests au niveau du navigateur

Quand GraphQL alimente des frontends orientés utilisateur, il est utile de valider la sensation de performance au niveau du navigateur. LoadView peut aussi exécuter des scénarios basés sur navigateur, en rendant les pages et en déclenchant des requêtes GraphQL via de vrais navigateurs. Cela mesure les temps de transaction complets — y compris le rendu, les délais réseau et le comportement de cache — offrant une vue bout en bout de l’expérience utilisateur sous charge.

Utilisées ensemble, ces couches — tests HTTP scriptés et exécutions navigateur — créent un modèle réaliste de la façon dont GraphQL se comporte réellement quand des centaines ou des milliers d’utilisateurs interrogent simultanément.

Éviter les pièges classiques des tests

Les tests de performance GraphQL regorgent de pièges qui rendent les données inutiles. Le pire est que la plupart d’entre eux semblent être des succès jusqu’à ce que la production démontre le contraire.

Une erreur fréquente est de tester une seule requête statique. Cela donne des chiffres propres et consistants — et ne dit rien sur la façon dont le système gère la diversité.

Une autre erreur est d’ignorer l’état du cache. La première exécution touche la base, et les cinq suivantes touchent Redis, et soudainement le rendement paraît excellent. Exécutez toujours des scénarios à cache froid et chaud.

Un piège plus subtil est de ne pas tenir compte de la variabilité au niveau des resolvers. Sans données de tracing, vous ne pouvez pas dire si une réponse lente provient d’une requête lourde ou d’un problème transitoire en back-end. Les hooks de temporisation des resolvers ou les extensions de tracing (Apollo Tracing, GraphQL Yoga, etc.) aident à séparer le coût des requêtes du bruit de l’infrastructure.

Enfin, ne confondez pas test de charge et chaos. L’objectif n’est pas de faire tomber votre API — c’est de trouver la pente où la latence commence à augmenter. Au-delà de ce point, vous mesurez la défaillance, pas la performance.

La bonne mentalité est diagnostique, pas destructive.

Interpréter les résultats des tests de charge GraphQL et agir

Les tests de charge ne consistent pas seulement à collecter des données ; il faut les traduire en décisions.

Commencez par la corrélation. Si les pics de latence s’alignent avec les comptes d’appels des resolvers, vous avez trouvé un problème N+1. Si la CPU augmente alors que les métriques de la base restent stables, votre goulet d’étranglement se situe dans le parsing de la requête ou la sérialisation de la réponse.

À partir de là, des voies d’optimisation s’ouvrent :

- Regroupez les resolvers à l’aide de dataloaders ou de jointures au niveau requête pour réduire les fetchs redondants.

- Ajoutez du cache au niveau resolver ou objet pour réduire le travail dupliqué.

- Mettez en place un score de complexité de requête afin que l’API puisse rejeter ou limiter les requêtes pathologiques avant qu’elles ne surchauffent le back-end.

- Introduisez des requêtes persistées — opérations pré-approuvées stockées côté serveur — pour éliminer l’overhead de parsing et limiter le comportement imprévisible du client.

Une fois les améliorations appliquées, relancez le même modèle de charge. Optimiser sans retester, c’est comme déboguer sans logs — vous devinez.

Rendre les tests de charge GraphQL continus

Un test de charge ponctuel est une case à cocher. Un test continu est un avantage d’ingénierie.

Les schémas GraphQL évoluent constamment à mesure que les produits grandissent. De nouveaux champs, de nouvelles jointures et de nouvelles fonctionnalités client modifient les caractéristiques de performance. Chaque modification de schéma peut altérer subtilement les chemins des resolvers ou les volumes de données.

Intégrez des tests de charge réduits dans les pipelines CI/CD — juste assez pour détecter les régressions avant le déploiement. Maintenez vos ensembles de requêtes à jour au fur et à mesure que le trafic de production évolue. Planifiez des tests approfondis mensuellement ou avant des lancements majeurs pour vérifier que les optimisations tiennent toujours.

Considérez la performance comme faisant partie du cycle de vie du schéma, pas comme une phase séparée. Dans GraphQL, chaque nouveau champ est une responsabilité potentielle de performance jusqu’à preuve du contraire.

Conclusion

Le pouvoir de GraphQL réside dans sa flexibilité. Cette même flexibilité facilite la construction d’une API qui semble parfaite sous des tests légers, mais qui s’effondre sous la variété du monde réel.

La bonne manière de tester la charge d’un GraphQL n’est pas une question de chiffres bruts — c’est une question de contexte. Simulez des requêtes réelles, mesurez le coût de leur profondeur et complexité, et tracez comment chacune se propage dans les systèmes. Comprenez la pente où la performance commence à se dégrader, pas seulement le point où elle casse.

Pour les équipes qui exécutent ces tests à grande échelle, LoadView aide à étendre le processus hors du laboratoire. En exécutant des scénarios JMeter ou pilotés par navigateur depuis plusieurs régions globales, il fournit une image plus fidèle des performances en conditions réelles d’internet — latence, variabilité et tout le reste.

Utilisé de cette manière, LoadView cesse d’être un simple outil et devient un terrain d’essai : l’environnement où les API flexibles affrontent la demande réelle. Faites cela, et les tests de charge cesseront d’être un rituel technique — ils deviendront une carte de la façon dont votre architecture se comporte réellement quand la liberté rencontre l’échelle.