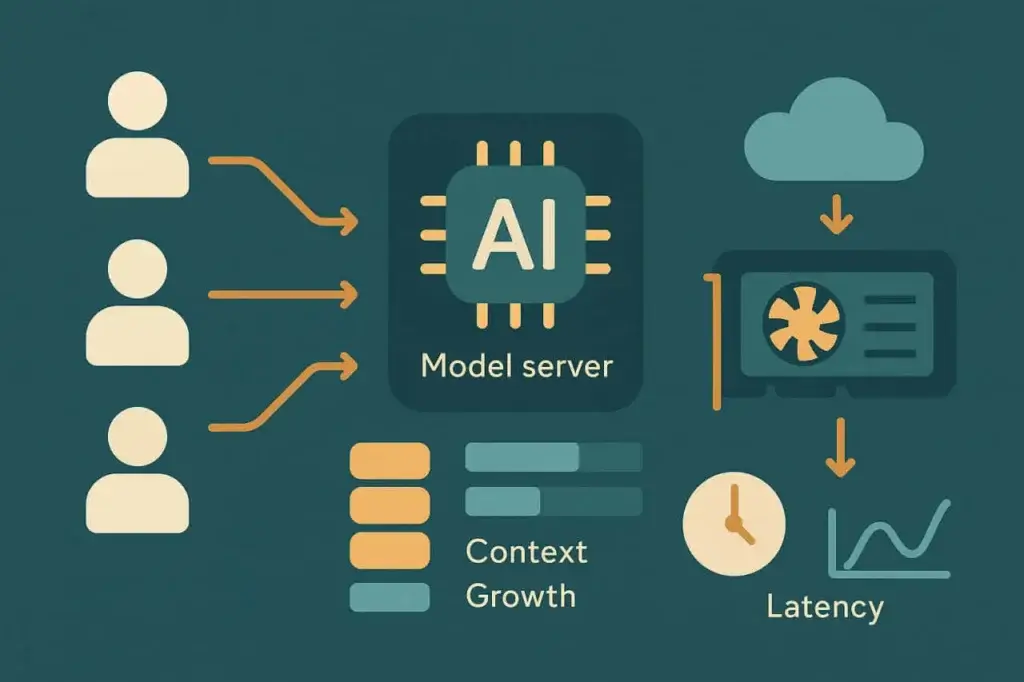

KI-Agenten verändern, was «Last» bedeutet. Traditionelle Lasttests wurden für Webseiten, APIs und Transaktionen entwickelt — Systeme, die sich unter Belastung vorhersehbar verhalten. KI-getriebene Workloads tun das nicht. Ihre Eingaben variieren in Länge, Komplexität und Kontext. Ihre Verarbeitung ist probabilistisch, nicht deterministisch. Ihre Leistung hängt genauso stark von GPU-Scheduling und Token-Generierung ab wie von Netzwerklatenz oder Backend-Durchsatz.

Dieser Wandel bricht die Annahmen, auf denen die meisten Lasttests aufgebaut wurden. Man kann einen KI-Agenten nicht wie einen anderen API-Endpunkt behandeln. Jede Anfrage ist eine Konversation, kein Klick. Jede Antwort hängt von der vorherigen ab. Und jede Session wird schwerer, wenn sich der Kontext anhäuft.

Um diese Systeme zuverlässig zu halten, brauchen Performance-Ingenieure ein neues Handbuch — eines, das versteht, wie man konkurrierendes Denken simuliert, nicht nur konkurrierenden Traffic. Dieser Artikel skizziert moderne, KI-gestützte Strategien zum Testen von Agenten in großem Maßstab und zum Erhalt ihrer Leistung, wenn die Komplexität wächst.

Leistungsherausforderungen bei Lasttests von KI-Agenten

KI-Workloads verhalten sich nicht wie Web- oder Mobiltraffic. Jeder «Nutzer» in einem KI-gesteuerten System kann eine Reihe verketteter Operationen darstellen: eine Prompt-Erweiterung, das Abrufen relevanten Kontexts, Modellinferenz und Nachbearbeitung oder Tool-Ausführung. Die Last ist nicht fix — sie entwickelt sich mit jedem Interaktionsschritt.

Wenn sich diese Schichten stapeln, wird die Leistungsverschlechterung nichtlinear. Eine 2-fache Zunahme gleichzeitiger Nutzer bedeutet nicht 2-fache Latenz — es können 5-fache Werte sein, abhängig von Modellbelastung, Speicher und GPU-Zuteilung. Traditionelle Lasttest-Metriken wie Requests pro Sekunde oder durchschnittliche Antwortzeit erfassen nicht die zugrunde liegenden Dynamiken. Entscheidend ist hier die Latenz-Elastizität — wie die Leistung nachgibt, wenn sich Sessions vervielfachen.

Es gibt mehrere wiederkehrende Stressfaktoren in Systemen mit KI-Agenten:

Kontextakkumulation

Jede Nutzeranfrage trägt historischen Kontext — manchmal tausende Tokens aus vorherigen Gesprächen oder Dokumentdaten. Wenn die Kontextlänge wächst, bläht sich die Prompt-Größe auf und die Modellinferenzzeit steigt. Im großen Maßstab erzeugt das unvorhersehbare Latenzspitzen und Warteschlangenbelastung auf GPUs.

Compute-gebundene Skalierung

Im Gegensatz zu Webservern lässt sich die Inferenz großer Modelle nicht immer horizontal skalieren. Modellgewichte und Kontextfenster verbrauchen feste GPU-Speicher; das Überschreiten der Kapazität bedeutet Warteschlangen oder Rückfall auf kleinere Modelle. Das macht die Grenzen der Konkurrenz weitaus restriktiver als bei CPU-basierten Systemen.

Retrieval-Latenz

Viele Agenten ziehen externe Daten — über Vektor-Datenbanken, APIs oder Dokumentenspeicher — bevor sie eine Antwort generieren. Diese Abhängigkeiten fügen I/O-Latenz hinzu und werden bei Verkehrsspitzen zum ersten Engpass.

Session-Persistenz

Traditionelle Lasttests spielen zustandslose Anfragen erneut ab. KI-Sessions sind zustandsbehaftet. Jede enthält Speicher, Embeddings und gecachten Kontext. Je länger das Gespräch, desto schwerer die Session-Footprint.

Diese Faktoren kombinieren sich zu einem neuen Stressprofil. Das System kann bei 100 gleichzeitigen Nutzern gesund wirken, aber bei 120 einknicken — nicht aufgrund ausgelaugter Bandbreite, sondern wegen GPU-Warteschlangen-Sättigung oder Überlauf des Kontext-Caches. Lasttests für KI-Systeme bedeuten, jene nichtlinearen Wendepunkte aufzudecken.

Verhalten von KI-Agent-Workloads verstehen

Bevor Sie Tests entwerfen, hilft es, zu modellieren, wie ein KI-Agent unter der Haube tatsächlich arbeitet. Die meisten Produktionsagenten folgen einer ähnlichen Pipeline:

- Eingabeaufnahme. Der Nutzer sendet eine Anfrage oder Nachricht.

- Kontextzusammenstellung. Der Agent sammelt relevante Daten aus vorherigen Runden oder einem externen Speicher.

- Modellinferenz. Der zusammengestellte Prompt wird an einen lokalen oder entfernten Modellendpunkt gesendet.

- Nachbearbeitung. Die Ausgabe kann geparst, validiert oder angereichert werden, bevor sie zurückgegeben wird.

- Antwortlieferung. Der Agent aktualisiert den UI-Zustand oder sendet eine API-Antwort.

Jede Stufe fügt Variabilität hinzu. Die Inferenzzeit skaliert grob mit der Anzahl von Eingangs- und Ausgangs-Tokens. Die Retrieval-Latenz hängt von der Nähe der Datenbank und den Cache-Hit-Raten ab. Die Kosten der Kontextzusammenstellung steigen mit jedem Gesprächsschritt.

Um das Performance-Verhalten zu verstehen, müssen Sie beobachten, wie diese Dimensionen interagieren. Beispielsweise kann eine Verdopplung der Prompt-Länge die durchschnittliche Inferenzlatenz um 60 % erhöhen, während eine Konkurrenz jenseits eines bestimmten Schwellenwerts sie um 300 % ansteigen lassen kann. Diese Kurven sind wichtiger als jede einzelne Metrik.

In der Praxis bedeutet das Kartieren des Workloads, progressive Rampentests durchzuführen. Beginnen Sie mit wenigen gleichzeitigen Sessions, erfassen Sie die Basislatenz und skalieren Sie dann schrittweise. Beobachten Sie, wie Token-Durchsatz, Warteschlangenzeiten und GPU-Auslastung reagieren. Jeder Agent hat seine eigene Skalierungs-Signatur, und sie zu finden ist der erste Schritt zu zuverlässigen Operationen.

Kernmetriken für Lasttests von KI-Agenten

Traditionelle Metriken — RPS, TTFB, Fehlerquote — gelten weiterhin, erzählen aber nicht die ganze Geschichte. Lasttests für KI-Agenten führen neue Metriken ein, die widerspiegeln, wie Intelligenz und nicht nur Infrastruktur skaliert.

Inferenzlatenz misst die Gesamtzeit von der Eingabe des Prompts bis zur fertigen Modellantwort. Sie ist das direkteste Leistungssignal, muss aber zusammen mit Eingabegröße und Modelltyp verfolgt werden. Der Vergleich einfacher Mittelwerte ohne Normalisierung nach Kontextgröße kann irreführend sein.

Kontextskalierung quantifiziert, wie die Latenz wächst, wenn das Prompt-Fenster sich erweitert. Ingenieure können die Antwortzeit gegen die Token-Anzahl auftragen, um die Kostenkurve zu visualisieren. Ein gut optimiertes System zeigt lineare oder unterlineare Skalierung, während schlecht optimierte Systeme exponentielle Spitzen jenseits bestimmter Kontextschwellen zeigen.

Token-Durchsatz — Tokens pro Sekunde über gleichzeitige Sessions — reflektiert sowohl Leistung als auch Kosteneffizienz. Da die meisten APIs pro Token abrechnen, führt ein Rückgang des Durchsatzes direkt zu wirtschaftlicher Ineffizienz.

Latenz von Abhängigkeiten erfasst Verzögerungen durch unterstützende Systeme: Vektorsuchen, Wissensbasen oder Plugin-APIs. Diese können die gesamte Antwortzeit dominieren, selbst wenn die Inferenz schnell ist.

Stabilität bei gleichzeitiger Last misst, wie sich das System unter simultaner Belastung verhält. Wächst die Latenz vorhersehbar? Bleiben die Fehlerraten begrenzt? Oder oszillieren die Antwortzeiten wild, wenn sich Warteschlangen bilden?

Durch die Kombination dieser Metriken können Teams ein ganzheitliches Bild der Performance erstellen. Das Ziel ist nicht nur, die Geschwindigkeit zu messen — es ist herauszufinden, wo und warum die Verschlechterung beginnt.

Entwurf effektiver Lasttests für KI-Systeme

Mit definierten Metriken wird die Teststrategie zur Frage der Simulations-Treue. KI-Agenten bedienen keine identischen Anfragen, daher ist das Aufzeichnen einer einzigen Transaktion und ihr Wiederabspielen unter Last nutzlos. Jeder synthetische Nutzer muss Variation repräsentieren — unterschiedliche Prompts, Längen und Verhaltensweisen. Das Ziel ist nicht Uniformität, sondern Realismus.

1. Modellieren Sie die gesamte Reasoning-Pipeline, nicht nur den Endpunkt

Reale Nutzer rufen /generate nicht isoliert auf. Sie authentifizieren sich, senden Kontext, rufen Retrieval auf und erzeugen dann die Ausgabe. Ein glaubwürdiger Lasttest imitiert diese Sequenz. Überspringen Sie eine Ebene, und Ihre Daten verlieren an Aussagekraft.

2. Parametrisieren Sie Prompts, um echte Vielfalt abzubilden

KI-Systeme verlangsamen, wenn Eingabelänge oder semantische Komplexität zunehmen. Verwenden Sie variable Prompt-Vorlagen, die Token-Anzahlen, Satzstrukturen oder eingebettete Kontexttiefe anpassen. So zeigt sich, wie Skalierung die Verteilung der Antwortzeiten beeinflusst.

3. Erhöhen Sie die Konkurrenz schrittweise

KI-Backends legen Anfragen auf Inferenz-Ebene oft in Warteschlangen. Statt sofort auf 1000 Nutzer zu springen, erhöhen Sie schrittweise in definierten Stufen — zum Beispiel 10 → 50 → 100 → 200 — und halten jede Stufe mehrere Minuten. Die entstehende Kurve zeigt, wo GPU- oder Thread-Sättigung beginnt.

4. Verfolgen Sie Kosten parallel zur Performance

Im Gegensatz zu Webservern verursachen Inferenz-APIs Kosten pro Token. Berechnen Sie während der Lasttests die Kosten pro Anfrage auf jedem Konkurrenzniveau. Performance-Optimierung sollte auch wirtschaftliche Effizienz beinhalten — schnelle, aber teure Modelle können wirtschaftlich bei Skalierung versagen, selbst wenn sie technisch bestehen.

5. Berücksichtigen Sie Retry- und Timeout-Verhalten

KI-Endpunkte drosseln häufig oder degradieren bei starker Nutzung. Simulieren Sie Client-Retry-Logik, um zusammengesetzte Lasteffekte zu beobachten. Ein naiver exponentieller Backoff kann den effektiven Traffic verdoppeln, wenn Ausfälle zunehmen.

Diese Strategien ersetzen das alte «Aufzeichnen und Wiederabspielen» durch eine Verhaltenssimulations-Mentalität. Statt Transaktionen zu testen, testen Sie Kognition — wie das System gleichzeitig denkt und skaliert.

KI-gestützte Lasttests: Lassen Sie die Modelle helfen

Ironischerweise kann KI helfen, das Problem zu lösen, das sie verursacht. Moderne Testplattformen integrieren zunehmend ML-Modelle direkt in ihre Analyse-Schleifen und erzeugen so das, was man oft KI-gestützte Lasttests nennt.

Hier übernimmt KI drei Rollen:

Prompt-Generierung

Anstatt manuell Hunderte Testeingaben zu erstellen, kann ein generatives Modell Prompt-Variationen produzieren, die die reale Nutzervielfalt simulieren. Es kann Ton, Struktur und Kontext automatisch anpassen und so das System einer breiteren Palette von Stressmustern aussetzen.

Anomalieerkennung

KI-Modelle können statistische Drift in Leistungsdaten schneller erkennen als statische Schwellenwerte. Anstatt zu alarmieren, wenn die Latenz eine feste Grenze überschreitet, lernen Anomalie-Modelle die normale Varianz und heben Ausreißer hervor, die auf echte Verschlechterung hindeuten.

Prädiktive Sättigungsanalyse

Durch die Analyse historischer Lastdaten kann KI vorhersagen, wann ein System seine nächste Leistungs-Klippe erreichen wird. Regressionsmodelle oder Zeitreihen-Prädiktoren identifizieren nichtlineare Skalierungsmuster, bevor sie die Produktion brechen.

Der Nutzen ist kein magisches Automatisieren, sondern Beschleunigung. Ingenieure verbringen weniger Zeit mit repetitiver Wartung und mehr Zeit damit, zu interpretieren, warum sich die Performance verschiebt. KI-gestützte Lasttests verwandeln manuelles Scripting in adaptive Experimente.

Implementierung von KI-Agent-Tests in LoadView

KI-Agenten mögen hochmodern sein, aber sie kommunizieren weiterhin über vertraute Protokolle — HTTP, WebSocket oder REST-APIs. Das bedeutet, dass Sie sie mit derselben Infrastruktur testen können, die LoadView bereits bietet.

API-basierte Tests sind die Grundlage. Jede Agenten-Anfrage, unabhängig von ihrer Komplexität, läuft letztlich auf einen API-Aufruf hinaus — oft JSON über HTTPS. Die API-Tests von LoadView ermöglichen es Teams, Tausende gleichzeitige Inferenz-Anfragen zu simulieren, jeweils parametrisiert mit dynamischen Payloads. Sie können Prompt-Größe variieren, Kontext injizieren und Latenz end-to-end messen.

UserView-Scripting erweitert diese Simulation über die Benutzeroberfläche. Viele Agenten leben in Dashboards, Chat-Portalen oder SaaS-Integrationen. Mit LoadView können Sie vollständige Workflows aufzeichnen — Login, Prompt-Eingabe, Antwortdarstellung — und sie von verteilten Cloud-Standorten wiedergeben. Dieser Ansatz validiert sowohl Backend- als auch Frontend-Verhalten unter realen Browserbedingungen.

Skalierbare Orchestrierung verbindet alles. Das Cloud-Netzwerk von LoadView verteilt Tests über Regionen hinweg, sodass Teams sehen können, wie globaler Traffic KI-Endpunkte trifft, die auf zentralisierte GPU-Cluster angewiesen sind. Durch die Korrelation von Antwortzeiten mit geografischer Distanz können Sie Netzwerklatenz von Modelllatenz trennen.

Analytics und Reporting schließen die Feedback-Schleife. LoadView verfolgt alle Standard-Performance-Metriken, kann aber auch angepasst werden, um modellspezifische Daten wie verarbeitete Tokens oder Kosten pro Session zu erfassen. Diese Kombination verwandelt synthetische Tests in eine Beobachtungsschicht für KI-Performance.

Mit anderen Worten: Sie brauchen keine neue Testplattform für KI-Systeme — Sie brauchen intelligenteres Testdesign innerhalb einer vorhandenen Plattform. LoadView hat bereits die Bausteine, und diese neue Klasse von Workloads verlangt lediglich eine andere Testphilosophie.

Die Zukunft der Lasttests für KI

KI-Systeme sind keine statischen Dienste — sie sind adaptiv, stochastisch und werden kontinuierlich nachtrainiert. Das bedeutet, dass sich ihre Leistungsmerkmale ändern, selbst wenn die Infrastruktur gleich bleibt. Ein Modell-Update, das die Genauigkeit verbessert, kann die Inferenzzeit verdoppeln. Eine Prompt-Änderung, die die Kohärenz erhöht, kann die Kontextgröße explodieren lassen. Lasttests müssen sich weiterentwickeln, um diese beweglichen Ziele zu berücksichtigen.

Zukünftige Performance-Tests werden Simulation, Analyse und selbstlernende Feedback-Schleifen verschmelzen. Tests passen sich in Echtzeit an und erweitern oder reduzieren die Last basierend auf der beobachteten Modellstabilität. Statt «Test laufen lassen, Bericht lesen» werden Ingenieure kontinuierliche Performance-Baselines pflegen, die sich mit dem Modell drift aktualisieren.

Der Fokus verschiebt sich über den Durchsatz hinaus. Die Schlüssel frage wird nicht mehr «Kann es 1000 Nutzer handhaben?» sein, sondern «Kann es unter Druck konsistent denken?» Die Messung der kognitiven Stabilität — wie die Qualität des Denkens nachlässt, wenn die Nachfrage steigt — wird zu einer Standardmetrik.

Für Organisationen, die KI-Copilots, Chat-Assistenten und automatisierte Entscheidungsagenten einsetzen, ist diese Entwicklung bereits im Gange. Die Systeme sind neu, aber das Prinzip bleibt zeitlos: Man kann nicht verbessern, was man nicht misst. Lasttests haben schon immer die Disziplin gewesen, verborgene Grenzen aufzudecken. KI fügt lediglich eine neue Grenze hinzu — die Grenze zwischen Leistung und Intelligenz.

Lasttests für KI-Agenten – Fazit

KI-Agenten führen eine neue Dimension in die Performance-Tests ein. Sie kombinieren rechenintensive Arbeit, dynamischen Kontext und unvorhersehbare Skalierung. Traditionelle Testskripte reichen nicht mehr aus, aber KI-gestützte Ansätze können helfen. Indem man sich auf Inferenzlatenz, Kontextskalierung und Stabilität bei gleichzeitiger Last konzentriert — und Werkzeuge wie LoadView nutzt, um vollständige Reasoning-Workflows zu simulieren — können Teams die Zuverlässigkeit bewahren, selbst wenn Intelligenz zum Kern ihrer Systeme wird.

Die nächste Ära der Lasttests wird nicht nur messen, wie schnell Systeme antworten. Sie wird messen, wie gut sie denken, wenn alle gleichzeitig fragen.