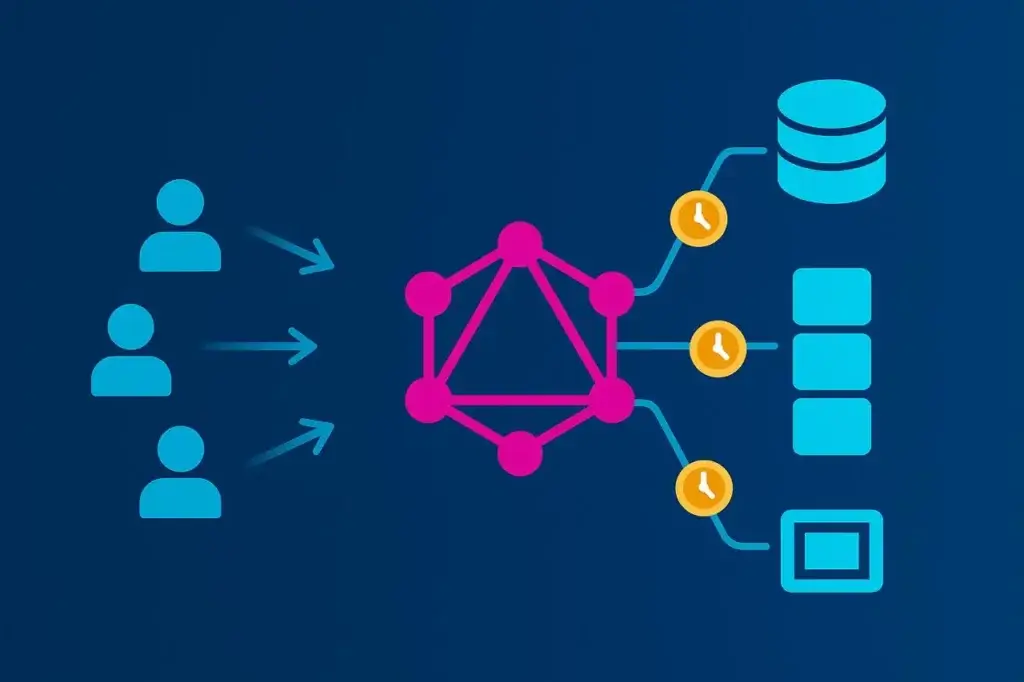

GraphQL hat die Art und Weise verändert, wie Frontends Daten konsumieren — und damit auch, wie APIs unter Druck ausfallen.

Im Gegensatz zu REST, bei dem jede Route definiert, welche Daten zurückgegeben werden, kehrt GraphQL die Kontrolle um. Der Client entscheidet, welche Felder abgefragt werden, wie tief er verschachtelte Strukturen durchläuft und wie oft die Anfrage wiederholt wird. Diese Flexibilität ist für Entwickler befreiend, macht die Performance aber unvorhersehbar. Zwei Abfragen gegen denselben Endpoint können völlig unterschiedliche Serverlasten erzeugen.

Traditionelle Lasttests setzen Konsistenz voraus: ein fixer Pfad, ein vorhersehbares Payload, messbare Latenz. GraphQL sprengt diese Annahmen. Um es effektiv zu testen, müssen Sie die Variabilität der Abfragen, die Tiefe der Resolver und die Konkurrenzmuster modellieren, die dem realen Einsatz entsprechen. Andernfalls testen Sie nur Ihren Cache — nicht Ihre API.

Dieser Artikel erklärt, wie man Lasttests entwirft, durchführt und interpretiert, die das erfassen, was in einem GraphQL-System wirklich zählt: Kosten der Resolver, Back-End-Orchestrierung und der Trade-off zwischen Flexibilität und Skalierbarkeit.

Warum Lasttests für GraphQL anders sind

Die meisten Lasttests basieren auf Wiederholung. Sie zeichnen eine API-Transaktion auf und spielen sie im Maßstab nach, um zu messen, wie lange deren Ausführung dauert. Das funktioniert gut für REST. Jeder /api/orders-Aufruf liefert ungefähr dasselbe Payload, fordert dieselbe Logik an und verursacht etwa dieselben Rechenkosten.

GraphQL führt hingegen für jede Anfrage einen eigenen Query-Planner aus. Jede Client-Anfrage definiert ihre eigene Arbeitslast:

- Manche holen ein oder zwei Felder.

- Andere tauchen fünf Ebenen tief in verschachtelte Beziehungen ein.

- Viele kombinieren Queries und Mutations in einem einzelnen Aufruf.

Für den Lastgenerator sieht das alles wie ein einzelner POST /graphql aus — aber unter der Oberfläche führen Ihre Server möglicherweise 50 Datenbankabfragen aus, verteilen Aufrufe an eine halbe Dutzend Microservices und serialisieren Hunderte von JSON-Feldern.

Deshalb kann ein GraphQL-Lasttest nicht als einfacher Durchsatztest behandelt werden. Es geht nicht darum, wie viele Anfragen pro Sekunde Sie verarbeiten können. Es geht darum, wie die Form der Abfrage das Verhalten des Back-Ends steuert. Die „richtige Weise“ bedeutet, Tests zu entwerfen, die diese Variabilität widerspiegeln, anstatt sie zu verbergen.

Die versteckten Kosten der Abfragekomplexität

Eine der am meisten missverstandenen Eigenschaften von GraphQL ist, wie teuer es mit zunehmender Tiefe werden kann. Eine scheinbar harmlose Abfrage kann sich in eine Rechenbombe verwandeln, wenn sie sich durch verschachtelte Resolver entfaltet.

Betrachten Sie ein einfaches E-Commerce-Schema:

query GetCustomer {

customer(id: "42") {

name

orders {

id

total

products {

id

name

price

}

}

}

}

Auf dem Papier wirkt das einfach. Ruft jedoch jeder Resolver die Datenbank separat auf — einen für den Kunden, einen für jede Bestellung, einen pro Produkt — haben Sie die Kosten der Abfrage exponentiell vervielfacht. Das berüchtigte N+1-Problem verwandelt eine einzelne Client-Anfrage in einen Schwarm von Back-End-Aufrufen.

Stellen Sie sich nun 1.000 virtuelle Nutzer vor, die diese Abfrage parallel ausführen. Sie testen dann nicht mehr nur einen Endpoint, sondern jede Datenbanktabelle und jeden nachgelagerten Microservice. Die Herausforderung ist nicht nur die Konkurrenz — es gilt zu verstehen, wo diese Konkurrenz auftritt.

Um Lasttests aussagekräftig zu machen, benötigen Sie Sichtbarkeit auf Resolver-Ebene. Abfragetiefe und Anzahl der Resolver müssen Teil Ihres Testprofils sein, nicht nur die Antwortzeit. Andernfalls sehen Sie nur den Rauch, nicht das Feuer.

Was zu messen ist (und warum)

Leistungskennzahlen für GraphQL sollten in Schichten betrachtet werden: Query, Resolver und System. Jede Schicht erzählt einen anderen Teil der Geschichte.

Auf der Query-Ebene konzentrieren Sie sich auf:

- Latzenzverteilungen (p50, p95, p99), um zu sehen, wie komplexe Abfragen die Tail-Performance verzerren.

- Durchsatz (QPS) — vor allem als kontextuelle Metrik nützlich, nicht als Selbstzweck.

- Fehler- und Timeout-Raten, um durch Last verursachte Verschlechterungen zu erkennen.

Auf der Resolver-Ebene sammeln Sie, wo möglich, Instrumentierungsdaten:

- Ausführungszeit pro Resolver oder Feld.

- Anzahl der Resolver-Aufrufe pro Abfrage.

- Cache-Hit/Miss-Verhältnisse.

- Latzenz von nachgelagerten Aufrufen (Datenbanken, externe APIs).

Auf der System-Ebene verknüpfen Sie diese Metriken mit der Infrastrukturauslastung — CPU, Speicher, Thread-Anzahl und Sättigung von Verbindungspools. GraphQL-Server sind bei Lastspitzen oft CPU-gebunden aufgrund des Parsings von Abfragen und der Serialisierung von Resolvern, sodass Ihr Engpass möglicherweise gar nicht in der Datenbank liegt.

Roh-Antwortzeiten allein sagen nicht viel aus. Die Korrelation von Resolver-Ausführung mit Infrastruktur-Telemetrie ist der Weg, echte Skalierbarkeits-Einschränkungen zu isolieren.

Ein realistisches Lastmodell für GraphQL aufbauen

GraphQL ist keine einzelne API — es ist eine Schnittstelle für Dutzende. Um es realistisch zu testen, müssen Sie diese Vielfalt abbilden.

Beginnen Sie damit, Produktions-Traffic oder Access-Logs nach Operationsnamen und Query-Signaturen zu analysieren. Diese zeigen die tatsächliche Mischung des Client-Verhaltens — kurze Lookups, tiefe Aggregationen, Mutations und gelegentlich „missbräuchliche“ »fetch everything«-Abfragen.

Davon ausgehend:

- Gewichten Sie Abfragen nach Häufigkeit. Ihre Test-Mischung sollte die Produktions-Proportionen widerspiegeln — z. B. 80 % leichte Lookups, 20 % komplexe verschachtelte Abfragen.

- Randomisieren Sie Variablenwerte, damit Caching-Schichten die Ergebnisse nicht verfälschen.

- Beziehen Sie Authentifizierungs-Flows ein, wenn relevant. Token-Erzeugung, Session-Validierung und Rate-Limiting können unter Last Engpässe werden.

- Modellieren Sie Konkurrenzmuster. Reale Nutzer kommen nicht gleichmäßig an. Simulieren Sie Bursts, Ramp-Ups und Leerlauf-Täler, um zu sehen, wie Autoscaling reagiert.

Ein Lasttest, der nur eine Abfrage wiederholt, ist wie ein Stresstest, der nur Ihre Startseite trifft — alles scheint in Ordnung, bis die Realität eintritt. Je repräsentativer Ihre Arbeitslast, desto wertvoller Ihre Daten.

GraphQL-Lasttests durchführen

GraphQL effektiv zu testen bedeutet, Realismus und Skalierung zu überlagern. Die Flexibilität der API erfordert sowohl kontrollierte, skriptbasierte Tests als auch verteilte Läufe, die reale Nutzerbedingungen über Regionen hinweg simulieren.

Skriptbasierte HTTP-Tests

JMeter bleibt eine solide Grundlage für GraphQL-Lasttests. Da GraphQL über standardmäßige HTTP-POST-Anfragen läuft, können Sie Queries als JSON-Payloads definieren, Variablen dynamisch injizieren und Tokens oder Session-Daten innerhalb eines JMeter-Testplans parametrieren.

Dieser Ansatz gibt volle Kontrolle über Konkurrenz, Header und Payload-Struktur — ideal, um Backend-Performance unter realistischer Query-Mischung zu validieren. Er ist leichtgewichtig und wiederholbar, erzählt aber nur einen Teil der Geschichte: die Antwortzeit auf Protokollebene. Netzwerk-Latenz oder Browser-Verhalten werden nicht berücksichtigt.

GraphQL-Tests mit LoadView skalieren

Um von lokalen JMeter-Runs zu einer Validierung im Produktionsmaßstab zu gelangen, bietet LoadView eine verwaltete Ausführungsschicht, die speziell für verteilte Tests entwickelt wurde. LoadView führt Ihre JMeter-Skripte aus mehreren geografischen Regionen aus und fügt reale Latenz- und Bandbreitenvariabilität hinzu, die lokale Umgebungen nicht nachbilden können.

LoadView erweitert die gleiche Scripting-Flexibilität und übernimmt die gesamte Orchestrierung:

- Bestehende JMeter-Pläne direkt importieren.

- GraphQL-POST-Anfragen mit dynamischen Variablen und Auth-Tokens ausführen.

- Konkurrierende Benutzer über globale Regionen ausführen, um realistische Performance-Daten zu erhalten.

- Latzenz-Percentile, Durchsatz und Fehlertrends in Echtzeit visualisieren.

Dieser hybride Ansatz — JMeter zur Testdefinition und LoadView zur verteilten Ausführung — bietet sowohl Präzision als auch Skalierung. Teams können während der Entwicklung schnell iterieren und dann vor dem Release mit derselben Testlogik in voller Last validieren.

Browser-Level-Lasttests

Wenn GraphQL Frontends für Endnutzer versorgt, lohnt es sich, zu prüfen, wie sich die Performance im Browser anfühlt. LoadView kann auch browserbasierte Szenarien ausführen, Seiten rendern und GraphQL-Anfragen über echte Browser auslösen. Das misst komplette Transaktionszeiten — einschließlich Rendering, Netzwerkverzögerungen und Cache-Verhalten — und liefert eine End-to-End-Sicht auf die Nutzererfahrung unter Last.

Kombiniert ergeben diese Ebenen — skriptbasierte HTTP-Tests und browserbasierte Ausführungen — ein realistisches Modell dafür, wie GraphQL tatsächlich performt, wenn Hunderte oder Tausende Nutzer gleichzeitig Abfragen stellen.

Klassische Testfallen vermeiden

GraphQL-Performance-Tests sind voller Fallen, die die Daten bedeutungslos machen. Das Schlimme ist, dass die meisten davon wie Erfolge aussehen, bis die Produktion das Gegenteil beweist.

Ein häufiger Fehler ist das Testen einer einzelnen statischen Abfrage. Das liefert saubere, konsistente Zahlen — und sagt nichts darüber aus, wie das System mit Vielfalt umgeht.

Ein weiterer Fehler ist das Ignorieren des Cache-Zustands. Die erste Ausführung trifft die Datenbank, die nächsten fünf treffen Redis, und plötzlich sieht die Performance großartig aus. Führen Sie immer Szenarien mit kaltem und warmem Cache durch.

Eine subtilere Falle ist das Nichtberücksichtigen der Variabilität auf Resolver-Ebene. Ohne Tracing-Daten können Sie nicht unterscheiden, ob eine langsame Antwort von einer schweren Abfrage oder einem transienten Back-End-Problem stammt. Timing-Hooks für Resolver oder Tracing-Erweiterungen (Apollo Tracing, GraphQL Yoga usw.) helfen, Abfragekosten vom Infrastruktur-Rauschen zu trennen.

Schließlich: Verwechseln Sie Lasttest nicht mit Chaos. Ziel ist nicht, Ihre API zum Absturz zu bringen — sondern die Steigung zu finden, bei der die Latenz zu steigen beginnt. Jenseits dieses Punkts messen Sie Ausfall, nicht Performance.

Die richtige Denkweise ist diagnostisch, nicht destruktiv.

Ergebnisse von GraphQL-Lasttests interpretieren und handeln

Lasttests sind nicht nur Datensammlung, sondern deren Übersetzung in Entscheidungen.

Beginnen Sie mit Korrelation. Wenn Latenzspitzen mit einer erhöhten Anzahl an Resolver-Aufrufen zusammenfallen, haben Sie ein N+1-Problem gefunden. Wenn die CPU steigt, während Datenbankmetriken stabil bleiben, liegt Ihr Engpass beim Parsen der Abfragen oder bei der Serialisierung der Antworten.

Darauf aufbauend öffnen sich Optimierungspfade:

- Batchen Sie Resolver mittels Dataloaders oder query-level Joins, um redundante Fetches zu reduzieren.

- Fügen Sie Caching hinzu auf Resolver- oder Objekt-Ebene, um doppelte Arbeit zu vermeiden.

- Implementieren Sie eine Komplexitätsbewertung für Abfragen, damit die API pathologische Abfragen ablehnen oder drosseln kann, bevor sie das Back-End schmelzen.

- Führen Sie persistente Abfragen ein — serverseitig gespeicherte, vorab genehmigte Operationen — um Parsing-Overhead zu eliminieren und unvorhersehbares Client-Verhalten einzuschränken.

Sobald Verbesserungen implementiert sind, führen Sie dasselbe Lastmodell erneut aus. Performance-Tuning ohne Nachtest ist wie Debugging ohne Logs — Sie raten.

GraphQL-Lasttests kontinuierlich machen

Ein einmaliger Lasttest ist ein Compliance-Häkchen. Ein kontinuierlicher Test ist ein Engineering-Vorteil.

GraphQL-Schemata entwickeln sich ständig weiter, wenn Produkte wachsen. Neue Felder, neue Joins und neue Client-Features verschieben Leistungscharakteristiken. Jede Schema-Änderung kann Resolver-Pfade oder Datenvolumen subtil verändern.

Integrieren Sie reduzierte Lasttests in CI/CD-Pipelines — gerade genug, um Regressionen vor dem Deployment zu erkennen. Halten Sie Ihre Query-Sätze aktuell, während sich der Produktionstraffic verändert. Planen Sie monatlich oder vor größeren Releases tiefere Tests, um zu prüfen, ob Optimierungen weiterhin greifen.

Behandeln Sie Performance als Teil des Schema-Lebenszyklus, nicht als separate Phase. In GraphQL ist jedes neue Feld eine potenzielle Performance-Verantwortung, bis das Gegenteil bewiesen ist.

Fazit

Die Stärke von GraphQL liegt in seiner Flexibilität. Dieselbe Flexibilität macht es leicht, eine API zu bauen, die unter leichten Tests perfekt wirkt, aber unter realer Vielfalt zusammenbricht.

Die richtige Methode für Lasttests in GraphQL dreht sich nicht um rohe Zahlen — sie dreht sich um Kontext. Simulieren Sie reale Abfragen, messen Sie die Kosten ihrer Tiefe und Komplexität und verfolgen Sie, wie sich jede einzelne über die Systeme verteilt. Verstehen Sie die Steigung, an der die Performance zu verschlechtern beginnt, nicht nur den Punkt, an dem sie bricht.

Für Teams, die diese Tests in großem Maßstab durchführen, hilft LoadView, den Prozess über das Labor hinaus zu erweitern. Durch das Ausführen von JMeter-basierten oder browsergesteuerten Szenarien aus mehreren globalen Regionen liefert es ein realistischeres Bild der Performance unter realen Internetbedingungen — Latenz, Variabilität und alles dazwischen.

Auf diese Weise wird LoadView weniger zu einem Werkzeug und mehr zu einem Prüfstand: der Umgebung, in der flexible APIs auf reale Nachfrage treffen. Tun Sie das, und Lasttests werden mehr als ein technisches Ritual — sie werden zu einer Landkarte, wie Ihre Architektur tatsächlich reagiert, wenn Freiheit auf Skalierung trifft.