In den komplexen digitalen Landschaften von heute, in denen Anwendungen und Systeme den sich ständig weiterentwickelnden Anforderungen ihrer Nutzer konsequent gerecht werden müssen, bleibt ein Faktor eine nicht verhandelbare Konstante: die Leistung. Als dynamische Brücke, die Benutzererwartungen und Systemfunktionen verbindet, ist Leistung nicht nur eine Kennzahl, sondern ein Versprechen für Zuverlässigkeit, Reaktionsfähigkeit und Robustheit.

Ein kurzer Überblick über Leistungstests

Leistungstests sind eine wichtige Methode, um dieses Versprechen zu bewerten und sicherzustellen. Es ist ein weit gefasster Begriff, der verschiedene Testtypen umfasst, die jeweils dazu dienen, bestimmte Aspekte der Leistung eines Systems zu messen. Von Auslastungstests, die den erwarteten Benutzerdatenverkehr emulieren, bis hin zu Belastungstests, bei denen das System seine Grenzen überschreitet, sind Leistungstests eine umfassende Bewertung der Leistung einer Anwendung oder eines Systems in verschiedenen Szenarien. Diese Tests befassen sich eingehend mit dem Systemverhalten und decken potenzielle Engpässe, Verlangsamungen und Abstürze auf, die sich auf die Systemverfügbarkeit und -funktionalität auswirken können.

Die Bedeutung von Leistungstests

Die Bedeutung von Leistungstests kann nicht hoch genug eingeschätzt werden. In einer Zeit, in der Benutzer sofortige Reaktionen und nahtlose Erlebnisse erwarten, können selbst geringfügige Leistungsprobleme zu erheblicher Unzufriedenheit der Benutzer, einem getrübten Ruf der Marke und letztendlich zu Geschäftsverlusten führen. Leistungstests liefern die Erkenntnisse, die zur Optimierung der Systemleistung erforderlich sind, um sicherzustellen, dass diese wichtigen Systeme auch bei intensivster Nutzung stabil und verfügbar bleiben.

Darüber hinaus sind strenge Leistungstests bei Systemen wie Finanzanwendungen, Online-Gaming-Plattformen oder E-Commerce-Anwendungen, die hohe Datenverkehrs- oder Datenlasten bewältigen müssen, noch wichtiger. Es stellt sicher, dass diese Systeme robust, skalierbar und in der Lage sind, auch unter extremen Bedingungen konstant hohe Leistung zu erbringen.

Im Wesentlichen sind Leistungstests ein wesentlicher Bestandteil des Lebenszyklus der Softwareentwicklung und bieten Unternehmen einen proaktiven Weg, um ihre Systeme und Anwendungen zu verbessern und so die Benutzerzufriedenheit und Geschäftskontinuität zu gewährleisten.

Die beliebtesten Arten von Leistungstests

1) Belastungstests

Auslastungstests sind eine Art von Leistungstests, bei denen die Leistung einer Anwendung oder eines Systems unter typischer und erwarteter Benutzerlast bewertet wird. Das Hauptziel von Auslastungstests besteht darin, zu verstehen, wie das System Benutzerdatenverkehr und Transaktionen verarbeitet, um sicherzustellen, dass es unter diesen Bedingungen stabil und zugänglich bleibt. Dies ist ein entscheidender Schritt, um die Zuverlässigkeit und Skalierbarkeit von Anwendungen oder Systemen zu gewährleisten, insbesondere von Anwendungen oder Systemen mit hohem Benutzeraufkommen oder solchen, die kritische Geschäftsprozesse verarbeiten.

Der Prozess des Auslastungstests umfasst die Simulation einer Workload, die den erwarteten Benutzerdatenverkehr und die erwarteten Transaktionen nachahmt. Tester können diese Simulation erreichen, indem sie automatisierte Testtools verwenden oder Daten manuell eingeben und Transaktionen ausführen. Durch die Anwendung dieser simulierten Last können Unternehmen Leistungsprobleme erkennen und beheben, bevor sie sich auf die Endbenutzer auswirken.

Für Lasttests stehen verschiedene Tools zur Verfügung, von denen jedes seine einzigartigen Funktionen und Fähigkeiten hat. Einige der am häufigsten verwendeten sind Apache JMeter, Gatling und LoadRunner. Diese Tools ermöglichen die Erstellung realistischer Lastszenarien, detaillierte Berichte und die Analyse der Systemleistung unter Last.

Auslastungstests können mehrere Herausforderungen mit sich bringen. Es erfordert ein gründliches Verständnis der Systemarchitektur und des erwarteten Benutzerverhaltens. Entscheidend ist auch die Auswahl eines geeigneten Lasttest-Tools, das realistische Lastszenarien simulieren kann. Die Interpretation der Ergebnisse von Lasttests erfordert Fachwissen, da sie die Analyse verschiedener Metriken und das Verständnis ihrer Auswirkungen auf die Systemleistung umfasst.

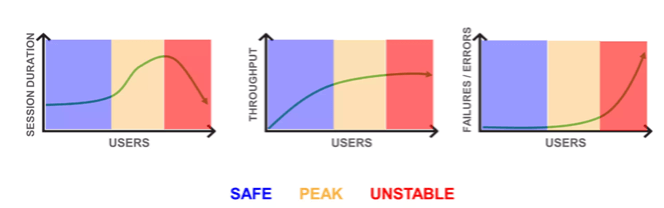

Ermitteln von Lastspitzen

Die Identifizierung von Lastspitzen ist ein wichtiger Aspekt von Auslastungstests. Die Spitzenlast bezieht sich auf die maximale Betriebskapazität, die eine Anwendung oder ein System bewältigen kann, bevor sich die Leistung verschlechtert oder ausfällt. Es ist wichtig, die Spitzenlast zu verstehen, um sicherzustellen, dass die Anwendung oder das System dem höchsten erwarteten Benutzerdatenverkehr standhalten kann.

Um die Spitzenlast zu ermitteln, muss die Last des Systems schrittweise erhöht werden, bis es den Punkt erreicht, an dem sich seine Leistung zu verschlechtern beginnt, d. h. die Antwortzeiten steigen, die Fehlerraten steigen oder die Ressourcen voll ausgelastet werden. Die Spitzenlast kann für verschiedene Anwendungen unterschiedlich sein und hängt von Faktoren wie Systemarchitektur, Ressourcen und der Art der Benutzeranforderungen ab.

Grundlegendes zu Lastkurven

Eine Lastkurve ist eine grafische Darstellung der Leistung eines Systems bei unterschiedlichen Lastniveaus. Es stellt Metriken wie Antwortzeit, Durchsatz oder Ressourcenauslastung im Vergleich zur Anzahl der Benutzer oder Anforderungen im Laufe der Zeit dar. Diese Kurve hilft zu visualisieren, wie sich das System unter verschiedenen Lastbedingungen verhält.

Abbildung

1

: Ermittlung der Spitzenlast des Systems

Lastkurven

Eine ideale Lastkurve sollte relativ flach sein, was darauf hinweist, dass die Leistung des Systems bei steigender Last stabil bleibt. Wenn die Last jedoch über die Kapazität des Systems hinaus ansteigt (Spitzenlast), beginnt die Kurve steil anzusteigen, was eine Verschlechterung der Leistung zeigt.

Das Verständnis der Lastkurve ist entscheidend für die Interpretation der Ergebnisse eines Belastungstests. Es hilft, Engpässe im System zu identifizieren, sein Verhalten unter verschiedenen Laststufen zu verstehen und seine Skalierbarkeits- und Kapazitätsplanungsanforderungen zu bestimmen. Die Lastkurve kann auch Systemoptimierungen und -verbesserungen leiten, um erhöhte Lasten effektiv zu bewältigen.

2) Stresstests

Belastungstests sind eine kritische Leistungstestmethode, die sich darauf konzentriert, festzustellen, wie sich eine Anwendung oder ein System unter extremen Lastbedingungen verhält, wobei häufig die maximale Kapazität überschritten wird. Der grundlegende Zweck von Stresstests ist zweierlei. Erstens erkennt es die absolute Grenze des Systems oder seine Sollbruchstelle, nach der es nicht mehr wie erwartet funktionieren kann. Zweitens zielen Stresstests darauf ab, zu verstehen, wie sich das System von diesen intensiven Stresssituationen erholt, die oft als Resilienz oder Robustheit bezeichnet werden.

Darüber hinaus sind Stresstests von größter Bedeutung, um potenzielle Leistungsprobleme zu identifizieren, die unter außergewöhnlichen Umständen auftreten können, einschließlich Systemengpässen, Verlangsamungen oder Abstürzen. Es ist von entscheidender Bedeutung, um die Stabilität und Verfügbarkeit kritischer Systeme oder Anwendungen zu gewährleisten, die hohen Datenverkehr oder Datenlasten bewältigen müssen, wie z. B. Finanzanwendungen, Online-Gaming-Plattformen oder E-Commerce-Anwendungen. Durch die Durchfuehrung von Stresstests koennen Unternehmen die Kundenzufriedenheit aufrechterhalten und Gewinneinbußen verhindern, indem sie sicherstellen, dass diese Systeme auch unter extremen Bedingungen robust bleiben.

Bei der Durchführung von Stresstests wird ein extrem hohes Datenverkehrs- oder Datenvolumen simuliert, das oft die maximale Kapazität des Systems übersteigt, um festzustellen, wie sich das System unter solchen Bedingungen verhält. Automatisierte Testtools können diese Simulation erreichen, indem sie eine große Anzahl von Benutzern generieren, oder Einzelpersonen können Daten manuell eingeben und Transaktionen ausführen. Die Methodik folgt einem progressiven Ansatz, bei dem die Last allmählich ansteigt, bis das System seine Belastungsgrenze erreicht. Beobachter überwachen die Systemleistung über diesen Punkt hinaus genau, untersuchen, wie es sich erholt und mit der extremen Last umgeht, und gewinnen so wertvolle Erkenntnisse über seine Robustheit.

Trotz ihrer erheblichen Vorteile bringen Stresstests ihre Herausforderungen mit sich. Eine der größten Herausforderungen besteht darin, das „richtige“ Maß an Belastung oder Last zu bestimmen, um die Grenzen des Systems auszutesten, ohne irreparable Schäden zu verursachen. Dies erfordert ein tiefes Verständnis der Systemarchitektur und ihrer Komponenten. Eine weitere Herausforderung ist die Interpretation der Ergebnisse des Stresstests, die komplex sein kann. Im Gegensatz zu anderen Formen von Tests, bei denen klare Pass/Fail-Kriterien existieren, sind die Ergebnisse von Stresstests nuancierter. Obwohl Analysten erwarten, dass das System ausfallen wird, müssen sie sorgfältig analysieren, an welchem Punkt es ausfällt und wie es sich erholt.

Darüber hinaus können Stresstests zeit- und ressourcenintensiv sein, insbesondere bei großen Systemen mit zahlreichen Komponenten. Auch die Replizierung einer produktionsähnlichen Umgebung, die extreme Bedingungen emulieren kann, kann technisch anspruchsvoll und kostspielig sein. Trotz dieser Herausforderungen sind die Erkenntnisse aus Stresstests von unschätzbarem Wert für die Verbesserung der Systemleistung und -robustheit, was sie zu einem wesentlichen Bestandteil des Leistungstestsystems macht.

3) Dauertest

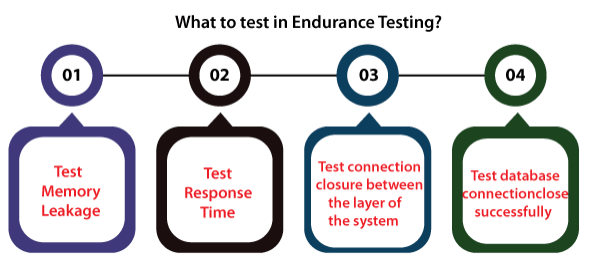

Die Methodik des Dauertests besteht darin, eine Belastung über einen längeren Zeitraum zu simulieren, der von mehreren Stunden bis zu Tagen oder sogar Wochen reichen kann, um zu beobachten, wie sich das System bei Dauerbetrieb verhält. Es erfordert die Erstellung realistischer Benutzerszenarien und die Aufrechterhaltung einer konsistenten Anwendungs- oder Systemlast.

Für diesen Prozess werden in der Regel automatisierte Testtools eingesetzt, obwohl auch die manuelle Eingabe von Daten und die Ausführung von Transaktionen Teil der Methodik sein können. Die Methoden für Dauerlauftests bestehen darin, eine typische Produktionslast zu simulieren und diese dann über einen längeren Zeitraum, je nach zu testendem System oft mehrere Stunden bis Tage, aufrechtzuerhalten. Der Test wurde entwickelt, um Probleme aufzudecken, die sich erst im Laufe der Zeit bemerkbar machen, wie z. B. eine allmähliche Verschlechterung der Antwortzeiten, Speicherlecks oder Ressourcenerschöpfung.

Dauertests bringen eine Reihe einzigartiger Herausforderungen mit sich. Erstens ist es zeitaufwändig, da lang andauernde Tests erforderlich sind, um die anhaltende Nutzung effektiv zu simulieren. Dies kann oft zu Verzögerungen im Entwicklungszyklus führen, wenn es nicht richtig geplant und gemanagt wird.

Zweitens kann es ressourcenintensiv sein und erfordert eine Testumgebung, die die Produktionsumgebung so genau wie möglich widerspiegelt. Darüber hinaus können aufgrund der verlängerten Testdauer Störungen oder Inkonsistenzen in der Testumgebung die Aussagekraft der Testergebnisse beeinträchtigen.

Schließlich kann das Erkennen und Diagnostizieren von Problemen bei Dauertests komplexer sein. Probleme wie Speicherverluste oder Ressourcenerschöpfung können subtil sein und erfordern möglicherweise eine sorgfältige Überwachung und Analyse, um sie zu erkennen und zu diagnostizieren. Trotz dieser Herausforderungen sind Dauertests eine wichtige Komponente von Leistungstests, da sie Erkenntnisse und Sicherheiten liefern, die mit Kurzzeittestmethoden nicht möglich sind.

4) Spike-Tests

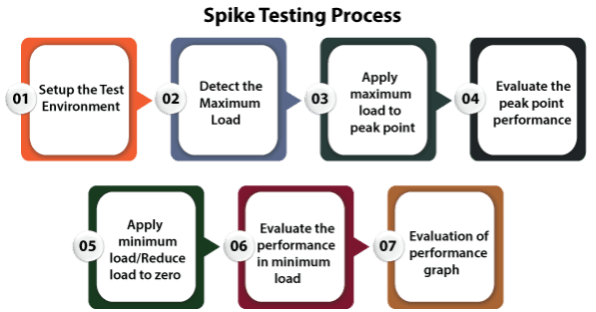

Spike-Tests sind eine spezielle Form von Leistungstests, bei denen die Widerstandsfähigkeit und Anpassungsfähigkeit einer Anwendung oder eines Systems bei plötzlichen, extremen Lastanstiegen, die als „Spikes“ bezeichnet werden, untersucht wird. Diese Spitzen ahmen häufig reale Szenarien nach, z. B. einen Anstieg des Benutzerdatenverkehrs während der Stoßzeiten oder unerwartete Ereignisse. Spike-Tests sind unerlässlich, um die Robustheit einer Anwendung oder eines Systems sicherzustellen.

Das Hauptziel von Spike-Tests besteht darin, festzustellen, ob die Anwendung oder das System unerwartete Lastspitzen effizient bewältigen kann, ohne dass es zu Leistungseinbußen oder -ausfällen kommt. Mit anderen Worten, es testet die Elastizität des Systems und stellt sicher, dass es nach oben skaliert werden kann, um die Nachfrage zu decken, und dann wieder herunterskaliert werden kann, wenn die Spitze nachlässt.

Die Methodik für Spike-Tests besteht darin, absichtlich plötzliche, extreme Lasten in das System einzuspeisen und zu beobachten, wie es reagiert. Automatisierte Testtools erreichen dies oft, indem sie einen abrupten Anstieg des Datenverkehrs simulieren oder es den Testern ermöglichen, die Spitze nachzubilden.

Die Tester setzen das System zunächst einer Standardlast in einem typischen Spike-Testszenario aus. Anschließend wird ein Spike eingeführt, der die Last vorübergehend erheblich erhöht. Nach der Spitze kehrt die Last auf ein normales Niveau zurück. In der Regel wiederholen die Tester diesen Zyklus mehrmals, um die Fähigkeit des Systems zu bewerten, mehrere Lastspitzen zu bewältigen.

Eine der größten Herausforderungen bei Spike-Tests ist die Unvorhersehbarkeit der Ergebnisse. Da bei Spitzentests die Reaktion des Systems auf plötzliche, extreme Lastanstiege getestet wird, können die Ergebnisse je nach Faktoren wie der Systemarchitektur, den verfügbaren Ressourcen und der Arbeitslast stark variieren.

Eine weitere Herausforderung besteht darin, zu definieren, was einen „Spike“ ausmacht. In realen Szenarien können Spitzen in Dauer, Intensität und Häufigkeit stark variieren. Daher kann die Definition einer geeigneten Spitze für Tests eine Herausforderung darstellen und ein tiefes Verständnis der Nutzungsmuster des Systems und potenzieller Lastszenarien erfordern.

Schließlich kann die genaue Simulation eines Spikes eine technische Herausforderung darstellen. Es erfordert ausgeklügelte Testwerkzeuge, die in der Lage sind, extreme Lastniveaus zu erzeugen und zu kontrollieren. Auch die Interpretation der Ergebnisse von Spike-Tests und die Identifizierung von Engpässen oder Leistungsproblemen erfordert ein hohes Maß an technischem Fachwissen.

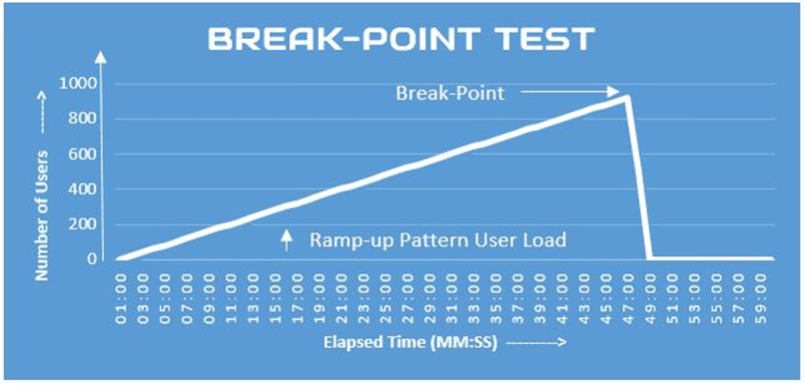

5) Breakpoint-Tests

Breakpoint-Tests sind ein wichtiges Werkzeug im Arsenal eines Entwicklers, das während der Softwareentwicklung verwendet wird, um Fehler im Code zu identifizieren und zu korrigieren. Im Wesentlichen ist ein Haltepunkt eine Markierung, die an einer bestimmten Zeile im Code festgelegt wird, an der ein Entwickler vermutet, dass ein Fehler vorhanden sein könnte. Wenn das Programm ausgeführt wird, wird die Ausführung am Haltepunkt angehalten, sodass der Entwickler den Zustand und das Verhalten des Programms genau zu diesem Zeitpunkt gründlich überprüfen kann.

Der Zweck von Haltepunkttests ist zweierlei. Erstens hilft es bei der Erkennung von Fehlern im Code während der Entwicklungsphase. Dieser präventive Ansatz stellt sicher, dass die Software korrekt funktioniert und frei von Fehlern ist, bevor sie für Endbenutzer freigegeben wird. Zweitens bietet es Entwicklern die Möglichkeit, den Ausführungsfluss innerhalb des Programms zu verstehen und zu steuern, wodurch ihre Fähigkeit verbessert wird, qualitativ hochwertigen und effizienten Code zu erstellen.

Die Methodik des Breakpoint-Tests ist unkompliziert und intuitiv. Ein Entwickler beginnt mit dem Festlegen eines Haltepunkts in einer bestimmten Codezeile, an der ein potenzieller Fehler vermutet wird. Entwickler erreichen dies, indem sie ein Debugtool oder eine integrierte Entwicklungsumgebung (IDE) wie Visual Studio oder Eclipse verwenden, die beide das Festlegen von Haltepunkten unterstützen. Das Programm wird bei der Ausführung an jedem Haltepunkt angehalten. Auf diese Weise kann der Entwickler den Zustand des Programms in genau dieser Codezeile untersuchen, einschließlich der Werte von Variablen, des Speicherzustands und der Aufrufliste. Wenn der Entwickler ein Problem entdeckt, kann er den Code ändern, um das Problem zu beheben, den Fix durch Fortsetzen der Ausführung überprüfen und bei Bedarf neue Haltepunkte für die weitere Diagnose und das Debuggen des Programms festlegen.

Trotz seiner vielen Vorteile bringt das Testen von Haltepunkten seine Herausforderungen mit sich. Zum einen kann es zeitaufwändig sein, insbesondere bei größeren, komplexeren Programmen mit mehreren potenziellen Fehlerpunkten. Darüber hinaus kann das Festlegen von zu vielen Haltepunkten den Ausführungsfluss unterbrechen und den Debugprozess verwirrender machen.

Darüber hinaus kann es schwierig sein, die genaue Position für einen Haltepunkt in komplexen Codebasen zu bestimmen. Auch das Problem von Heisenbugs, Fehlern, die ihr Verhalten ändern, wenn sie beobachtet werden (z. B. wenn ein Haltepunkt gesetzt wird), kann dazu führen, dass Fehler schwer fassbar und schwieriger zu diagnostizieren und zu beheben sind. Trotz dieser Herausforderungen bleiben Breakpoint-Tests eine unschätzbare Strategie in der Softwareentwicklung, die dazu beiträgt, die Erstellung zuverlässiger, leistungsstarker Softwareanwendungen sicherzustellen.

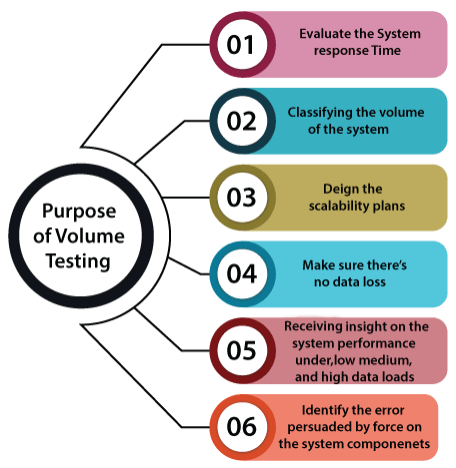

6) Volumenprüfung

Volumentests sind eine spezielle Form von Leistungstests, die entwickelt wurden, um die Leistung einer Anwendung oder eines Systems bei einem erheblichen Daten- oder Transaktionsvolumen zu bewerten. Diese Form des Testens ist entscheidend für Systeme, von denen erwartet wird, dass sie große Datenmengen verarbeiten oder eine große Anzahl von Transaktionen durchführen. Der Hauptzweck von Volumentests besteht darin, die maximale Menge an Daten oder Transaktionen zu ermitteln, die das System verarbeiten kann, während ein optimales Leistungsniveau beibehalten wird. Durch die frühzeitige Erkennung von Leistungsproblemen können Unternehmen potenzielle Leistungsprobleme proaktiv entschärfen und sicherstellen, dass das System zukünftige Wachstums- und Skalierbarkeitsanforderungen bewältigen kann.

Um Einschränkungen oder Engpässe im System zu identifizieren, beinhaltet die Durchführung von Volumentests die Simulation eines großen Daten- oder Transaktionsvolumens, das oft die maximal erwartete Nutzung übersteigt. Diese Simulation kann durch automatisierte Tools erreicht werden, die ein hohes Datenvolumen oder Transaktionen generieren, oder durch die manuelle Eingabe von Daten und die Durchführung von Transaktionen. Der Testprozess beginnt mit der Definition der Testbedingungen und dem Entwurf und der Erstellung von Testfällen, die das gewünschte Datenvolumen generieren. Die Tester überwachen dann das System auf Leistungseinbußen, Systemausfälle oder andere Probleme im Zusammenhang mit der Datenverarbeitung.

Die Volumenprüfung bringt mehrere Herausforderungen mit sich. Eine große Herausforderung ist der Aufbau einer Testumgebung, die die Produktionsumgebung genau abbildet, insbesondere in Bezug auf das Datenvolumen. Tester können auch vor Herausforderungen stehen, wenn es darum geht, realistische Testdaten zu erstellen, die alle möglichen Szenarien abdecken. Darüber hinaus kann die Analyse der Ergebnisse von Volumentests aufgrund des hohen Datenvolumens komplex sein. Trotz dieser Herausforderungen bleiben Volumentests für Systeme, von denen erwartet wird, dass sie hohe Datenmengen bewältigen können, von entscheidender Bedeutung, um sicherzustellen, dass sie zukünftige Wachstums- und Skalierbarkeitsanforderungen erfüllen können.

7) Kompatibilitätstests

Kompatibilitätstests sind ein wesentlicher Bestandteil der Software-Qualitätssicherung, um sicherzustellen, dass eine Anwendung oder ein System in verschiedenen Umgebungen funktioniert. Sein Hauptziel ist es, die Kompatibilität der Software mit verschiedenen Hardwarekonfigurationen, Betriebssystemen, Netzwerkumgebungen, Browsern und Geräten zu überprüfen. Kompatibilitätstests stellen sicher, dass die Endbenutzererfahrung konsistent und zufriedenstellend bleibt, unabhängig von den unzähligen Technologien, die sie für die Interaktion mit der Software verwenden.

Die Bedeutung von Kompatibilitätstests ist mit dem exponentiellen Anstieg der Technologievielfalt gewachsen. Die unzähligen Gerätetypen, Betriebssysteme, Browserversionen und Netzwerkkonfigurationen, die eine moderne Anwendung unterstützen muss, können atemberaubend sein. Die Gewährleistung der Kompatibilität zwischen all diesen Konfigurationen ist von entscheidender Bedeutung, um eine positive Benutzererfahrung zu bieten und eine breite Benutzerbasis aufrechtzuerhalten.

Kompatibilitätstests können sowohl manuelle als auch automatisierte Testansätze umfassen. Manuelle Tests können das physische Einrichten verschiedener Hardwarekonfigurationen oder die Verwendung verschiedener Geräte zum Testen der Anwendung umfassen. Auf der anderen Seite können automatisierte Tests Virtualisierungstechnologie oder Geräteemulationssoftware verwenden, um verschiedene Umgebungen zu simulieren, wodurch der Prozess schneller und effizienter wird.

Die größte Herausforderung bei Kompatibilitätstests ist die Anzahl der möglichen Konfigurationen. Bei zahlreichen Kombinationen von Hardware, Betriebssystemen, Browsern und Netzwerkumgebungen ist es unmöglich, sie alle gründlich zu testen. Daher müssen Tester auf der Grundlage von Benutzerdaten und Marktanteilen Prioritäten setzen. Eine weitere Herausforderung ist die ständige Weiterentwicklung der Technologie. Kontinuierliche Veröffentlichungen neuer Geräte, Betriebssystem-Updates und Browser-Versionen erfordern eine kontinuierliche Aktualisierung der Testmatrix.

Darüber hinaus kann die Wartung der Infrastruktur für Kompatibilitätstests, ob physisch oder virtuell, kostspielig und komplex sein. Trotz dieser Herausforderungen sind Kompatibilitätstests in der heutigen vielfältigen Technologielandschaft unerlässlich, um sicherzustellen, dass eine Anwendung oder ein System eine konsistente und zufriedenstellende Benutzererfahrung über alle unterstützten Konfigurationen hinweg bietet.

8) Latenz-Tests

Latenztests sind eine bestimmte Art von Leistungstests, mit denen die Zeit gemessen wird, die ein System oder eine Anwendung benötigt, um auf die Aktion oder Anforderung eines Benutzers zu reagieren. Das Verständnis der Latenz eines Systems ist in einer Welt, in der Benutzer schnelle und nahtlose Interaktionen verlangen, von entscheidender Bedeutung. Der Hauptzweck von Latenztests besteht darin, die Reaktionsfähigkeit von Anwendungen oder Systemen zu bewerten, die Echtzeitinteraktionen erfordern, um sicherzustellen, dass sie die Erwartungen und Leistungsstandards der Endbenutzer erfüllen.

Um Latenztests durchzuführen, wird eine Last, in der Regel in Form von Anforderungen, simuliert und an das zu testende System gesendet. Anschließend wird die Zeit gemessen, die das System benötigt, um auf diese Anfragen zu antworten. Diese Reaktionszeit wird gründlich aufgezeichnet und analysiert, um potenzielle Engpässe oder Verzögerungsbereiche im System zu identifizieren. Der Prozess umfasst die Auswahl geeigneter Testwerkzeuge, das Einrichten der Testumgebung, das Ausführen des Tests und die Analyse der Ergebnisse. Die Tester nutzen das Ergebnis dieser Analyse, um Leistungsprobleme zu identifizieren und Strategien zu entwickeln, um das System entsprechend zu optimieren.

Eine der größten Herausforderungen bei Latenztests besteht darin, eine realistische Testumgebung zu schaffen, die die Bedingungen, unter denen das System betrieben wird, genau darstellt. Weitere Herausforderungen können darin bestehen, die Ergebnisse richtig zu interpretieren und die identifizierten Probleme effektiv anzugehen.

9) Gleichzeitige Client-Tests

Gleichzeitige Clienttests sind eine spezielle Form von Leistungstests, bei denen bewertet wird, wie ein System oder eine Anwendung reagiert, wenn mehrere Benutzer gleichzeitig darauf zugreifen. Diese Tests zielen darauf ab, sicherzustellen, dass das System unter Hochlastbedingungen, die denen in realen Szenarien ähneln, stabil, zuverlässig und reaktionsschnell bleibt. Während der Haupteinkaufszeiten ist es eine wichtige Testmethodik für Anwendungen mit häufigen gleichzeitigen Benutzerinteraktionen, wie z. B. Multiplayer-Online-Spiele, Streaming-Plattformen oder E-Commerce-Websites.

Zu den wichtigsten Metriken, die während gleichzeitiger Clienttests ausgewertet werden müssen, gehören Antwortzeit, Durchsatz, Fehlerrate und Systemressourcennutzung. Diese Metriken können wertvolle Einblicke in die Fähigkeit des Systems liefern, mehrere gleichzeitige Benutzer zu verarbeiten.

Gleichzeitige Clienttests können komplex sein, da viele virtuelle Benutzer erstellt und verwaltet werden. Die Interpretation von Testergebnissen kann ebenfalls eine Herausforderung darstellen, da geringfügige Änderungen in der Systemkonfiguration oder im Benutzerverhalten die Leistung erheblich beeinträchtigen können. Darüber hinaus kann die Behebung der während des Tests festgestellten Leistungsprobleme erhebliche Ressourcen und Fachwissen erfordern.

10) Durchsatz-Tests

Durchsatztests sind eine Unterart von Leistungstests, bei denen die Kapazität eines Systems gemessen wird, um ein bestimmtes Volumen von Anforderungen innerhalb einer bestimmten Zeit zu verarbeiten. Durchsatztests zielen darauf ab, eine Grundlage für die Leistung des Systems zu schaffen und Einschränkungen oder Engpässe zu identifizieren, die die Fähigkeit zur Verarbeitung von Datenverkehr mit hohem Volumen beeinträchtigen könnten. Dies ist von entscheidender Bedeutung für Systeme, bei denen es darauf ankommt, große Datenmengen effizient und schnell zu verarbeiten, wie z. B. Rechenzentren, Netzwerkserver und Webanwendungen mit hohem Datenverkehr.

Die Methodik für Durchsatztests umfasst die Erstellung einer kontrollierten Testumgebung, die die Produktionsumgebung genau widerspiegelt. Eine große Anzahl von Anfragen wird dann innerhalb eines bestimmten Zeitrahmens an das zu testende System gesendet. Die Fähigkeit des Systems, diese Anfragen zu verarbeiten, wird überwacht und aufgezeichnet, wobei der Schwerpunkt auf Metriken wie Transaktionen pro Sekunde, der Datenübertragungsrate und der Anzahl der gleichzeitigen Verbindungen liegt, die es verarbeiten kann.

Es stehen verschiedene Testtools zur Verfügung, um Durchsatztests zu erleichtern. Diese Tools können große Mengen an Anfragen generieren und die Reaktion des Systems überwachen, indem sie detaillierte Berichte und Echtzeiteinblicke in die Leistung des Systems liefern. Das gewählte Tool hängt von den Besonderheiten des zu testenden Systems und den Anforderungen des Testszenarios ab.

Zu den wichtigsten Metriken bei Durchsatztests gehören die Transaktionsrate pro Sekunde, die Datenübertragungsrate und die Anzahl der gleichzeitigen Verbindungen, die das System verarbeiten kann. Die Analyse dieser Metriken kann Einblicke in die Kapazität und Effizienz des Systems geben.

Durchsatztests können eine Herausforderung darstellen, da eine große Anzahl von Anfragen generiert und die Reaktion des Systems genau gemessen wird. Die Interpretation der Ergebnisse kann ebenfalls komplex sein, da kleine Änderungen in der Systemkonfiguration oder den Workload-Merkmalen den Durchsatz erheblich beeinträchtigen können. Darüber hinaus kann die Behebung von Leistungsproblemen, die während der Tests festgestellt wurden, erhebliche Ressourcen und Fachwissen erfordern.

Bonus: Benchmark-Tests

Benchmark-Tests sind eine Methode des Leistungstests, bei der die Effizienz einer Anwendung gemessen wird, indem sie mit etablierten Standards oder der Leistung anderer ähnlicher Systeme verglichen wird. Es ist ein wichtiger Prozess für Anwendungen, von denen erwartet wird, dass sie auf bestimmten Branchenebenen funktionieren, wie z. B. Finanztransaktionssysteme, Datenbankserver oder Cloud-basierte Anwendungen.

Bei Benchmark-Tests werden bestimmte Leistungsindikatoren wie Transaktionsgeschwindigkeit, Systemdurchsatz, Latenz und Ressourcenauslastung unter die Lupe genommen. Diese Indikatoren helfen zu verstehen, wie gut eine Anwendung im Vergleich zu Mitbewerbern oder anhand einer Reihe vordefinierter Kriterien abschneidet.

Die Durchführung von Benchmark-Tests kann Feinheiten beinhalten, wie z. B. die Simulation realistischer Betriebsbedingungen und die Analyse von Vergleichsdaten. Für eine effektive Performance-Optimierung ist es entscheidend, die Ergebnisse genau zu interpretieren. Das Ansprechen von Bereichen, in denen eine Anwendung zu kurz kommt, kann ressourcenintensiv sein, ist aber unerlässlich, um sicherzustellen, dass die Anwendung eine optimale Benutzererfahrung bieten und einen Wettbewerbsvorteil auf dem Markt aufrechterhalten kann.

Diese Passage enthält ebenfalls 122 Wörter und bietet einen prägnanten, aber umfassenden Überblick über Benchmark-Tests, die in Ausführlichkeit und Komplexität dem Beispiel für gleichzeitige Client-Tests ähneln.

Messen von Testoptionen

Leistungstests sind ein wichtiger Aspekt der Softwareentwicklung, der sicherstellt, dass Anwendungen und Systeme bereit sind, in realen Szenarien eine optimale Leistung zu erbringen. Jede Art von Leistungstests spielt in diesem Prozess eine einzigartige und wichtige Rolle.

Auslastungstests

helfen Unternehmen zu verstehen, wie sich ihre Anwendung oder ihr System unter der erwarteten Benutzerlast verhält, und stellen Stabilität und Verfügbarkeit auch bei Spitzenauslastung sicher.

Belastungstests

ermöglichen es Teams, die Sollbruchstellen einer Anwendung oder eines Systems oder sichere Nutzungsgrenzen zu identifizieren, was zu einer verbesserten Ausfallsicherheit und Robustheit führt.

Skalierbarkeitstests

stellen sicher, dass die Anwendung das Wachstum in Bezug auf Benutzer, Datenvolumen und Transaktionsvolumen bewältigen kann, was sie für eine zukunftsorientierte Entwicklung unverzichtbar macht.

Kompatibilitätstests

garantieren, dass die Anwendung oder das System in verschiedenen Umgebungen, einschließlich Hardware, Betriebssystemen, Netzwerkumgebungen und anderer Software, ordnungsgemäß funktioniert, um eine reibungslose Benutzererfahrung zu gewährleisten.

Latenztests

bewerten die Reaktionsfähigkeit einer Anwendung, was für Anwendungen, die eine Echtzeitinteraktion erfordern, von entscheidender Bedeutung ist, wodurch die Benutzerzufriedenheit erhöht wird.

Gleichzeitige Benutzertests

und

Durchsatztests

Messen Sie die Leistung des Systems, wenn mehrere Benutzer gleichzeitig auf die Anwendung zugreifen, und die Menge an Arbeit, die das System in einer bestimmten Zeit bewältigen kann. Diese Tests sind entscheidend für Systeme, die eine hohe Benutzerinteraktion erwarten, um einen reibungslosen Betrieb zu gewährleisten.

Best Practices erfordern, dass Entwicklungs- und Qualitätssicherungsorganisationen Leistungstests in die frühen Phasen des Entwicklungszyklus integrieren und regelmäßig durchführen. Es kann nicht genug betont werden, wie wichtig es ist, eine Testmodalität frühzeitig in den Entwicklungsprozess zu integrieren. Dieser Ansatz hilft dabei, Probleme früher zu erkennen und zu beheben, wodurch die Kosten und die Komplexität von Korrekturen reduziert werden. Die Automatisierung des Testprozesses, wo immer dies möglich ist, sollte ebenfalls eine hohe Priorität haben, da dies die Effizienz und Konsistenz erhöht.

Mit Blick auf die Zukunft, da Softwaresysteme immer komplexer werden und die Erwartungen der Benutzer an die Leistung weiter steigen, werden Leistungstests nur noch wichtiger. Mit den Fortschritten bei KI und maschinellem Lernen können wir intelligentere Tools für Leistungstests erwarten, die in der Lage sind, Leistungsprobleme noch effektiver vorherzusagen und zu diagnostizieren.

Wenn Sie mit Auslastungstests beginnen möchten, melden Sie sich noch heute für eine kostenlose Testversion von LoadView an!