Qu’est-ce que la mise à l’échelle automatique?

La mise à l’échelle automatique est une méthode associée au cloud computing qui augmente ou diminue automatiquement le nombre de ressources que vous avez dans votre application, à tout moment en fonction de leurs besoins. Avant d’utiliser le cloud computing, il était très difficile de mettre à l’échelle automatiquement une installation de serveur. Dans un environnement d’hébergement physique, vos ressources matérielles sont limitées, de sorte que nous subirons une dégradation des performances de l’application, ou notre application tombera en panne.

Aujourd’hui, le cloud computing permet de créer une configuration de serveur évolutive. Si votre application a besoin de plus de puissance de traitement, la mise à l’échelle automatique offre aux utilisateurs la possibilité d’utiliser et de mettre fin à des ressources supplémentaires au besoin. La mise à l’échelle automatique ne permet d’utiliser les ressources efficacement que lorsque cela est nécessaire, s’assure que votre application a la capacité lorsque la demande augmente ou diminue, et surtout, vous épargne de payer potentiellement plus que vos besoins d’organisation. Plongeons plus profondément dans la mise à l’échelle automatique, comment elle fonctionne et les avantages qu’elle offre aux organisations.

Pourquoi la mise à l’échelle automatique est nécessaire

La mise à l’échelle automatique est très fonctionnelle lorsque votre application a besoin de ressources serveur supplémentaires pour prendre en charge le nombre de demandes de page ou de rendu. Il vous offre une capacité évolutive à l’échelle ou à la réduction automatiques pour répondre à vos besoins. La mise à l’échelle automatique offre les avantages suivants :

- La mise à l’échelle automatique permet à certains serveurs d’entrer en mode veille pendant les périodes de faible charge, ce qui réduit les coûts.

- Augmentation de la disponibilité et plus grande disponibilité lorsque les charges de travail varient.

- Sur le site front-end, il offre la possibilité d’échelle basée sur le nombre de demandes entrantes.

- Sur l’extrémité arrière, il fournit l’échelle basée sur le nombre d’emplois et combien de temps les travaux ont été dans la file d’attente dans la file d’attente.

Utilisation de LoadView pour s’assurer que la mise à l’échelle automatique fonctionne correctement

LoadView est une solution de test de charge basée sur le Web qui peut tout tester, des API et des pages Web aux scénarios utilisateur complexes au sein d’applications Web internes / externes. Loadview partage avec les tests qu’il exécute des rapports qui aident à trouver des problèmes et des pépins qui ralentissent ou retardent notre système. Lorsque vous testez la charge de pages Web, par exemple, vous pouvez tester une page spécifique par rapport à des centaines, voire des milliers d’utilisateurs simultanés pour voir comment la page fonctionne sous des niveaux de charge spécifiques.

Lors de l’essai des chemins utilisateur, LoadView, avec l’enregistreur Web EveryStep,transforme votre écran en script pour tester les interactions en temps réel avec les applications, capturer toutes les actions effectuées et peut être rejoué sous charge.

Configuration LoadView

Pour notre exemple, nous testerons une application interne. Lors du test d’applications internes, les adresses IP doivent être mises sur liste blanche avant d’effectuer des tests de charge sur les applications internes. Grâce aux injecteurs de charge, nous pouvons liste blanche des adresses IP et effectuer des tests avec de nombreux utilisateurs simultanés.

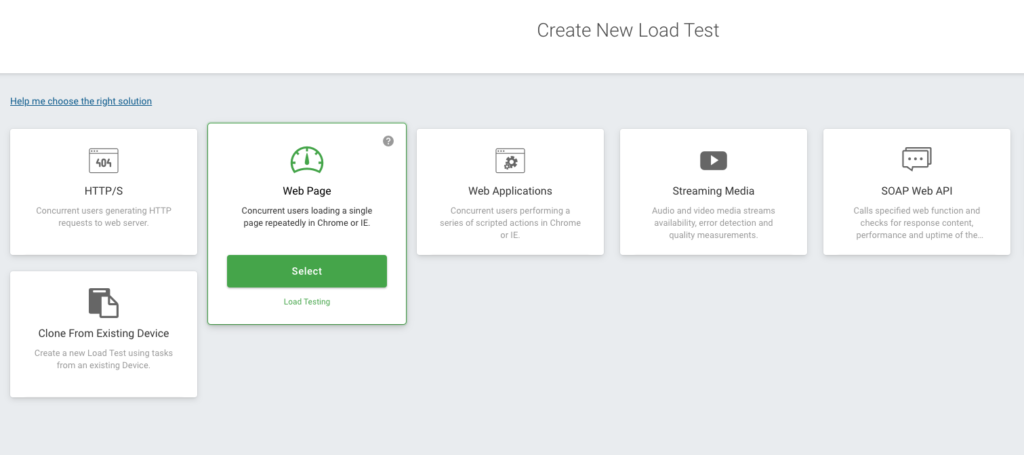

La page principale de LoadView s’ouvre et vous verrez plusieurs options différentes, telles que les applications Web, les API, les pages Web, les médias en streaming, etc. Nous sélectionnerons l’option Page Web.

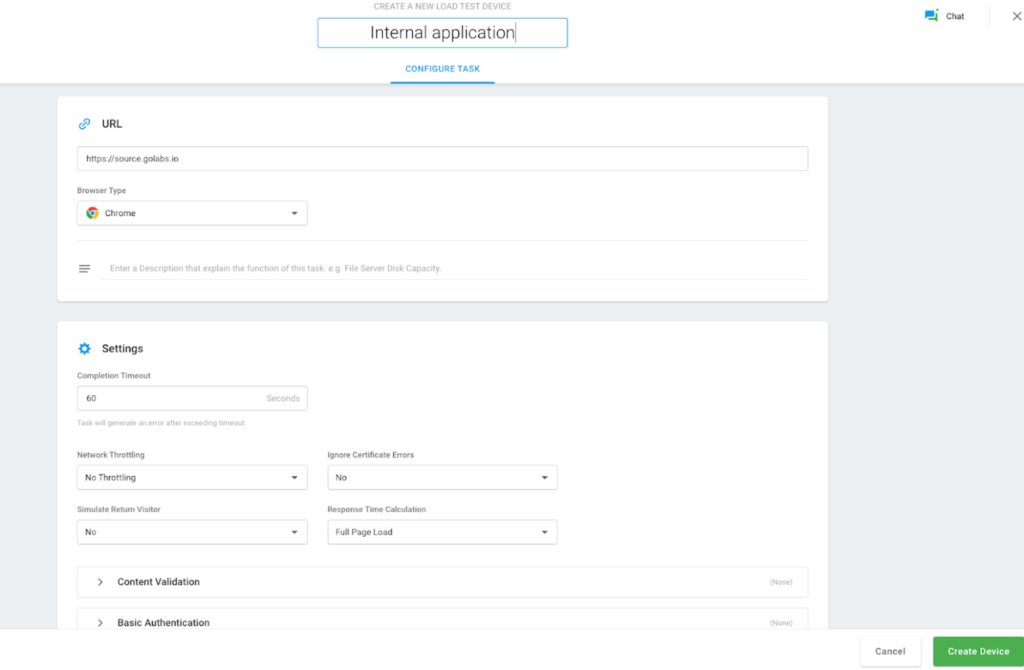

Une nouvelle page s’ouvre où nous pouvons ajouter l’heure souhaitée pour exécuter le test de charge, ajouter notre nom d’hôte interne au site Web, notre navigateur, etc. Après avoir entré vos coordonnées, cliquez sur le bouton Créer l’appareil.

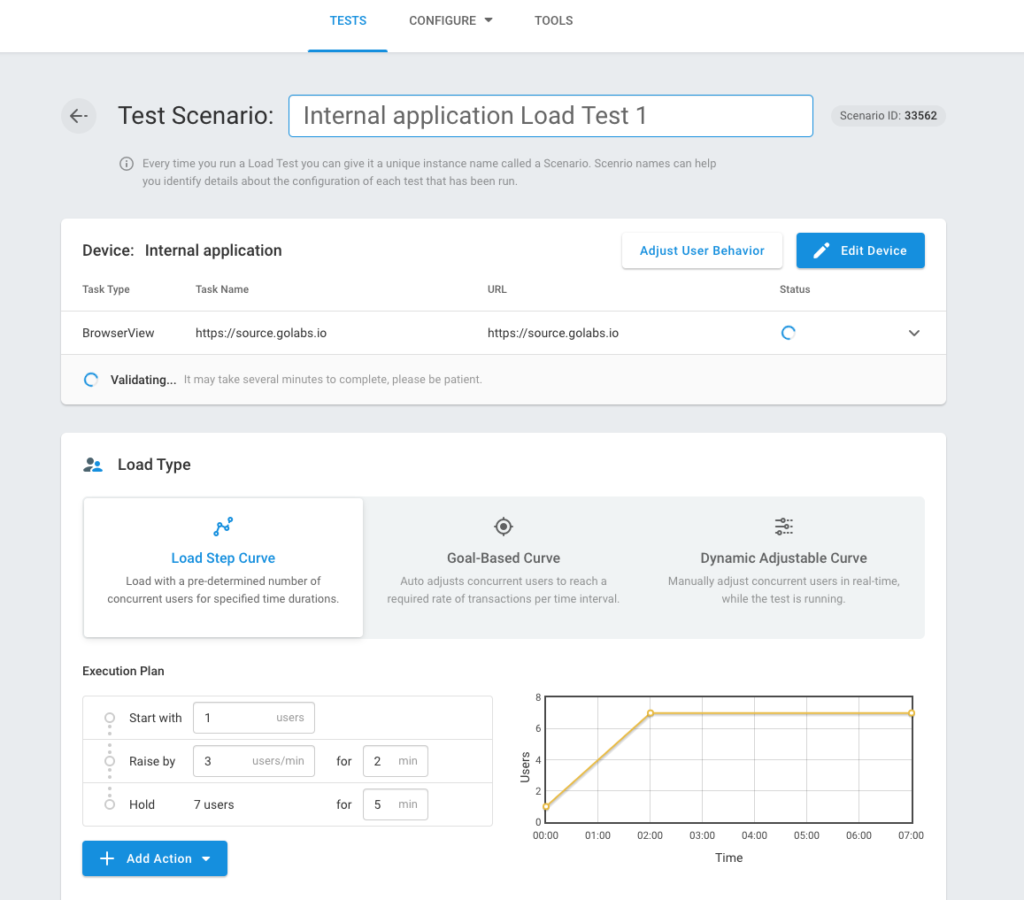

Après avoir réussi à créer un périphérique, vous verrez l’écran scénario de test où vous pouvez définir et définir le type de charge, les emplacements des injecteurs de charge, etc. Ensuite, nous sélectionnerons l’option Courbe d’étape de charge.

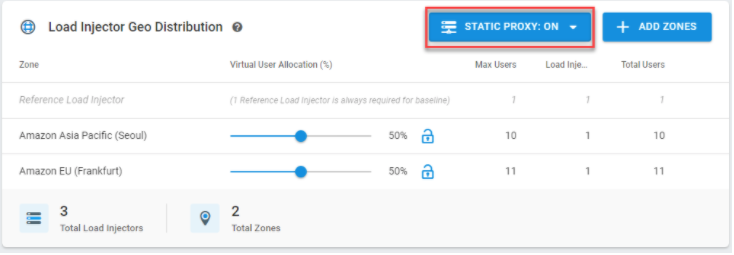

LoadView commencera à vérifier si vous avez accès à l’application interne. Sélectionnez Proxy Statique et incluez vos adresses IP sur liste blanche et sélectionnez Ajouter des zones pour choisir les régions où nous voulons le trafic généré. En fait, la plate-forme LoadView peut vous aider à tester des applications Web, des pages Web, des API et d’autres services Web qui résident uniquement dans votre réseau, derrière le pare-feu.

Les utilisateurs de LoadView ont le choix entre plusieurs options, telles que la mise en liste blanche des adresses IP ou l’installation d’un agent local si les organisations ne peuvent pas ouvrir leur réseau au trafic entrant pour des raisons de sécurité. Pour plus d’informations sur les tests de charge derrière un pare-feu,visitez notre base de connaissances.

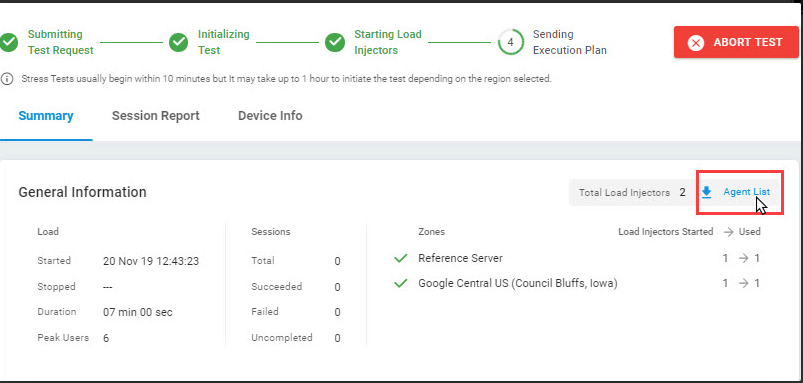

Une fois terminé, sélectionnez Démarrer le test. Nous devons trouver des adresses IP statiques dans la partie Liste des agents de cet écran; Chargez les créateurs pour accéder aux applications internes qui doivent être redirigées vers la liste blanche. Vous pouvez trouver les adresses IPs statiques dans la liste des agents sur cet écran pour accéder aux applications internes qui doivent être prises à la liste blanche.

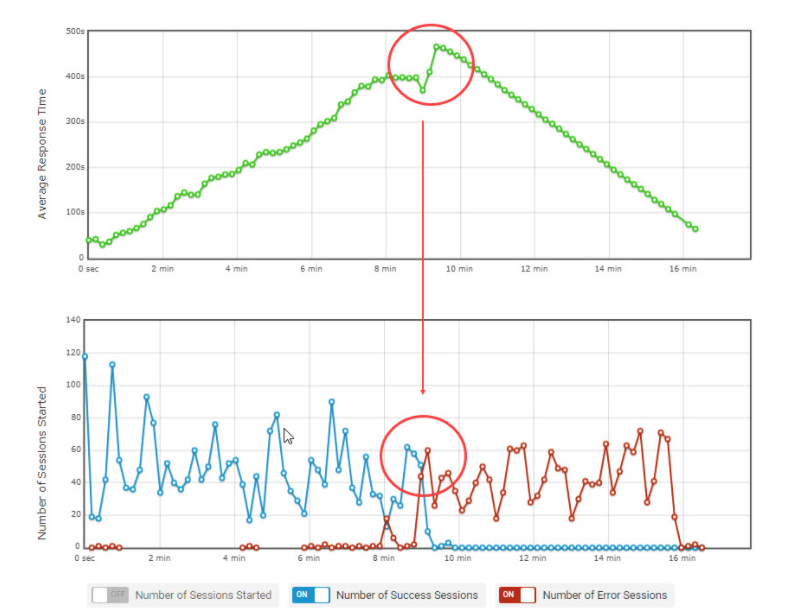

Pendant que le test est en cours d’exécution, les injecteurs récupèrent chaque fois de nouvelles adresses IP uniques sur la liste blanche. Nous pouvons voir les performances à travers des panneaux et des graphiques des tests que nous avons créés dans notre application en prenant les ADRESSES statiques dans la liste blanche. Un exemple est montré ci-dessous.

Parallèle Nombre moyen d’utilisateurs avec le graphique du temps de réponse moyen.

Surveiller les ressources supplémentaires dans AWS à mesure que la charge augmente

Paramètres CloudWatch

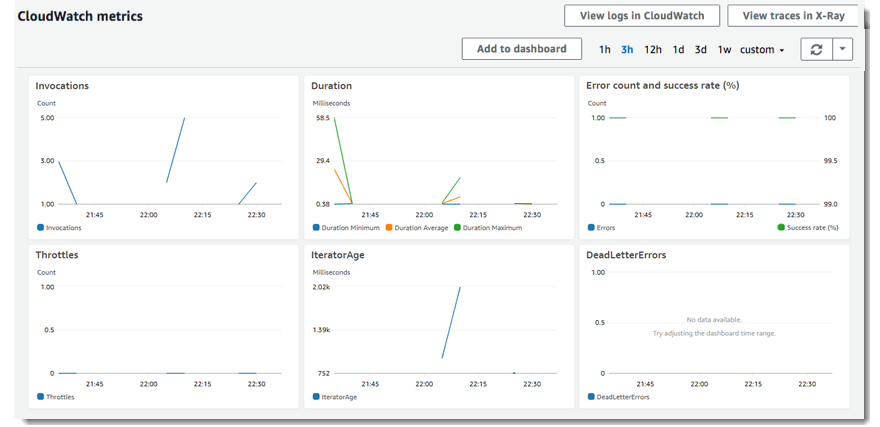

Avec CloudWatch, nous pouvons obtenir des statistiques sur les données. Nous utilisons des mesures pour vérifier que notre système fonctionne comme prévu. Vous pouvez créer l’alarme CloudWatch pour suivre une mesure spécifique et recevoir des notifications d’alarme dans votre courrier. L’équilibrage de charge ne signale les données à CloudWatch que lorsque les demandes passent par l’équilibriste de charge et mesure les mesures d’équilibrage de la charge élastique à chaque minute et les envoie à CloudWatch.

Afficher les mesures CloudWatch à votre balanceur de charge

Vous pouvez afficher les mesures CloudWatch de vos 3èmes de charge à l’aide de la console EC2. Si l’électriseur de charge est activé et reçoit des demandes, nous pouvons afficher les points de données.

Journaux d’accès

Grâce aux journaux d’accès, nous pouvons analyser le trafic et les utiliser pour résoudre nos problèmes. Nous pouvons également stocker les demandes que nous faisons à notre 3e balanceur de charge dans Amazon S3 en tant que fichiers journaux.

Recherche de demandes

L’électrificateur de charge ajoute un identificateur de suivi pour chaque demande qu’il reçoit, de sorte que vous pouvez surveiller les demandes HTTP.

Journaux CloudTrail

Avec CloudTrail, les journaux de transactions effectués par les comptes de tous les utilisateurs peuvent être suivis. De cette façon, vous pouvez gérer les demandes d’autorisation et d’accès.

Assurer aucune dégradation de l’expérience utilisateur avec la mise à l’échelle automatique

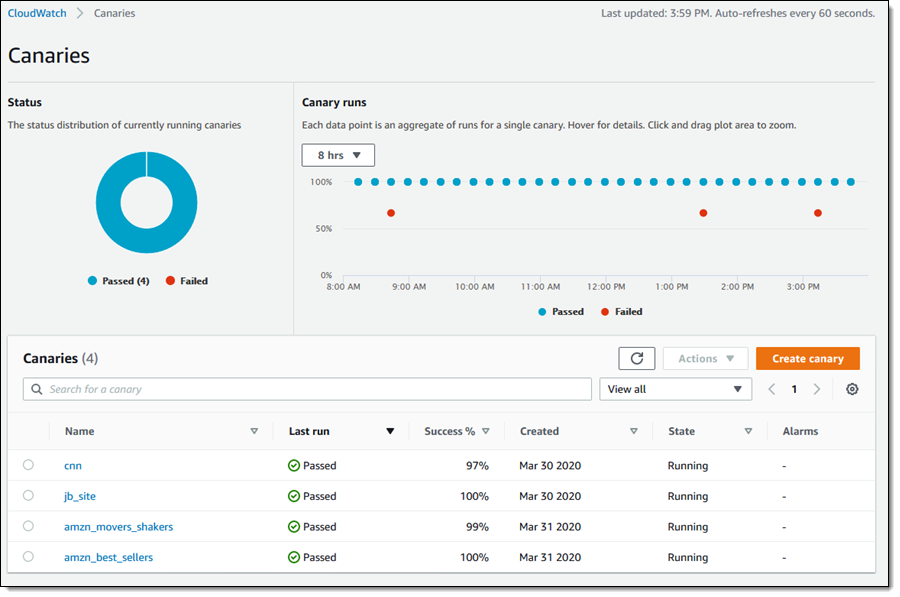

CloudWatch Synthetics vous permet de surveiller les performances des utilisateurs. Il fournit une meilleure vue d’ensemble des performances et de la convivialité, ce qui vous permet de détecter les problèmes plus tôt et de répondre plus rapidement, augmentant ainsi le plaisir des clients et garantissant que votre application peut mieux répondre aux demandes. Canaries sont utilisés pour nous laisser avec un avertissement précoce. Pour une utilisation canarien, nous cliquent sur Canaries dans la console CloudWatch où nous pouvons observer l’état de tous les canaris sur un seul écran.

Examinons comment les canaris fonctionnent sur les données. Pour cela, lorsque nous examinons des points de données individuels dans la section canari, vous pouvez voir que chaque point datum est la somme des études réalisées pour un canari.

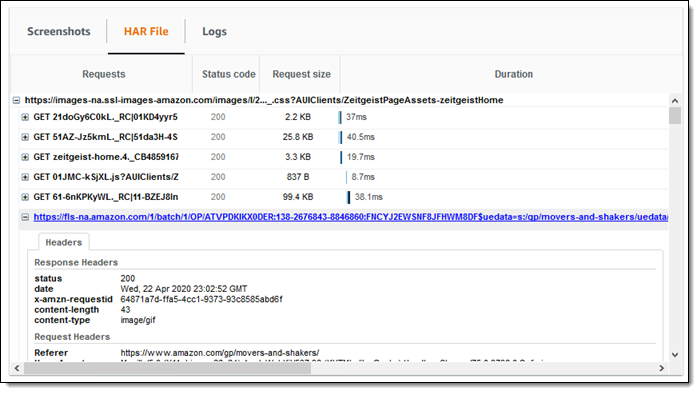

Dans la capture d’écran ci-dessous, vous pouvez voir qu’il ya un sujet TimeoutError pendant 24 heures. Nous pouvons également voir des captures d’écran obtenues avec des fichiers HAR et des journaux. Dans chaque enregistrement HAR, nous voyons les temps écoulés pour les réponses et les demandes et les demandes HTTP faites pour Canary.

Les tâches canaries sont effectuées en utilisant des fonctions lambda. À partir de l’onglet Métriques, vous pouvez accéder aux mesures d’exécution de la fonction.

Éclosion d’un canari

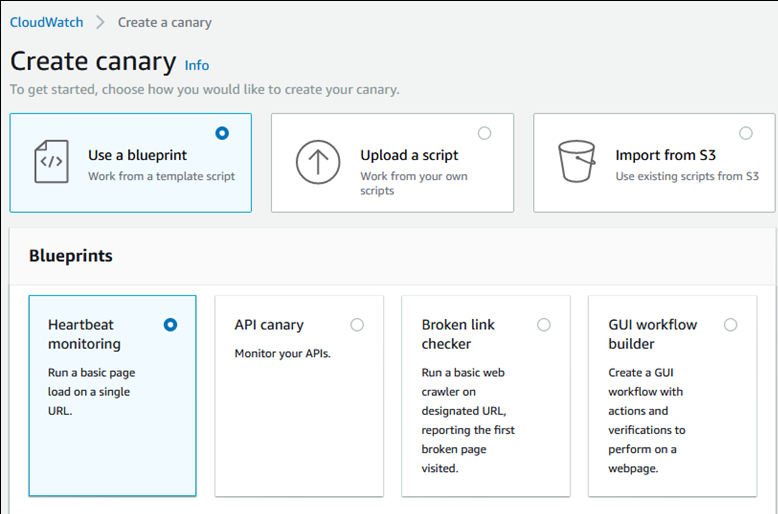

Pour créer un canari, nous appuyez sur le canari pour le créer. Nous pouvons sélectionner parmi les cases à cocher, charger le script existant ou importer d’Amazon S3.

À la suite des méthodes que nous créons, l’exécution du script une fois ou l’exécution périodique est créée. Nous pouvons utiliser les méthodes GET ou PUT, les en-têtes HTTP demandés lors de la création de canaris pour les points de terminaison API. Nous pouvons également créer notre processus de construction de canaris via GUI. Nous pouvons facilement donner nos caractéristiques canaris. Les scripts canaries utilisent le temps d’opération syn-1.0. Vous pouvez voir l’exemple de script ci-dessous.

Dans les scripts, nous pouvons voir les résultats réussis et les erreurs comme des exceptions. Nous créons la période de conservation des données pour le script. Nous choisissons seau S3 pour les structures qui seront formés après chaque travail de notre canari. Lors de la création de notre canari, nous pouvons également définir certaines des installations telles que le rôle IAM (Identity and Access Management), CloudWatch Alarms, VPC (Virtual Private Cloud) Settings et Tags.

Conclusion : Test de la mise à l’échelle automatique dans AWS

Afin d’éviter que nos utilisateurs ne soient affectés par la dégradation, nous pouvons utiliser Canary pour détecter les problèmes possibles devant les utilisateurs, les enregistrer, et intervenir à un stade précoce et les répondre plus rapidement. En outre, grâce aux alarmes fournies dans nos canaris, nous pouvons augmenter les sources en cas de besoin, ce qui empêche également les utilisateurs d’être affectés négativement.

De plus, afin de maximiser la satisfaction des clients et de s’assurer que vos applications peuvent mieux répondre aux demandes, CloudWatch Synthetics, combiné à la plate-forme LoadView, peut vous aider à obtenir une meilleure vue d’ensemble des performances et de la facilité d’utilisation et à vous assurer que l’échelle automatique fonctionne comme prévu lors des tests de charge.

Inscrivez-vous à l’essai gratuit de LoadView et commencez à tester les performances de toutes vos pages Web, applications et API dès aujourd’hui.

Ou si vous souhaitez d’abord voir la solution LoadView en action, inscrivez-vous, vous-même et n’importe qui d’autre dans votre équipe, pour une démo privée avec l’un de nos ingénieurs de performance. Ils fourniront une démo complète, couvrant tout, de la création et l’édition de scripts de test de charge, à la configuration et l’exécution des scénarios de test de charge et l’analyse des rapports. Planifiez votre démo.